python抓取网页数据(爬虫分析网页2.对网页发送请求,获取响应3.提取解析 )

优采云 发布时间: 2022-03-30 22:04python抓取网页数据(爬虫分析网页2.对网页发送请求,获取响应3.提取解析

)

相信很多朋友还是喜欢买基金的,今天正好有时间给大家送个基金。虽然不可能致富,但对理财还是有帮助的。代码放在下面。

爬虫大体思路:

1.分析网页

2.向网页发送请求并获得响应

3.提取解析数据

4.保存数据

Python版本:3.6.5

import requests

import time

import csv

import re

分析网页

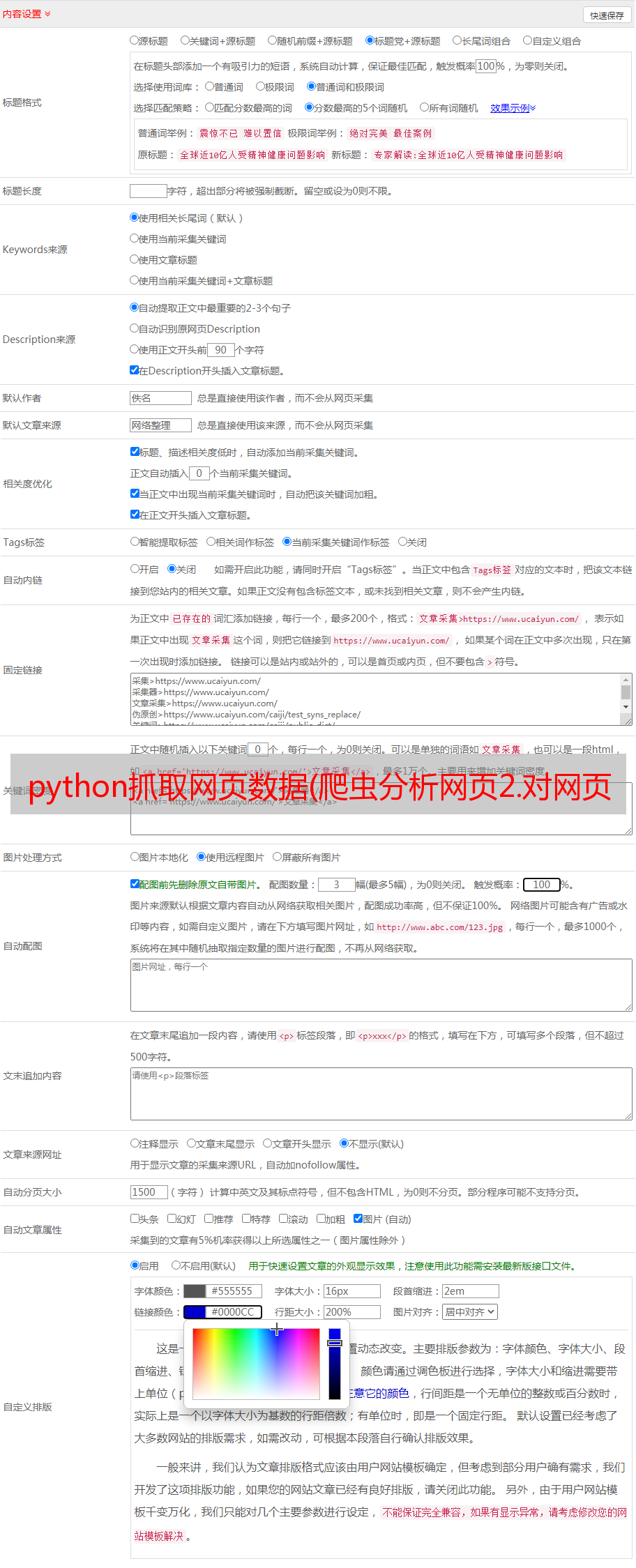

其实这个网站的网页数据并没有太多的反爬,就是网页需要构造一个params的参数,里面收录翻页的数据和时间戳数据。这些是动态的,你需要如何自己做呢?指定它,如图所示:

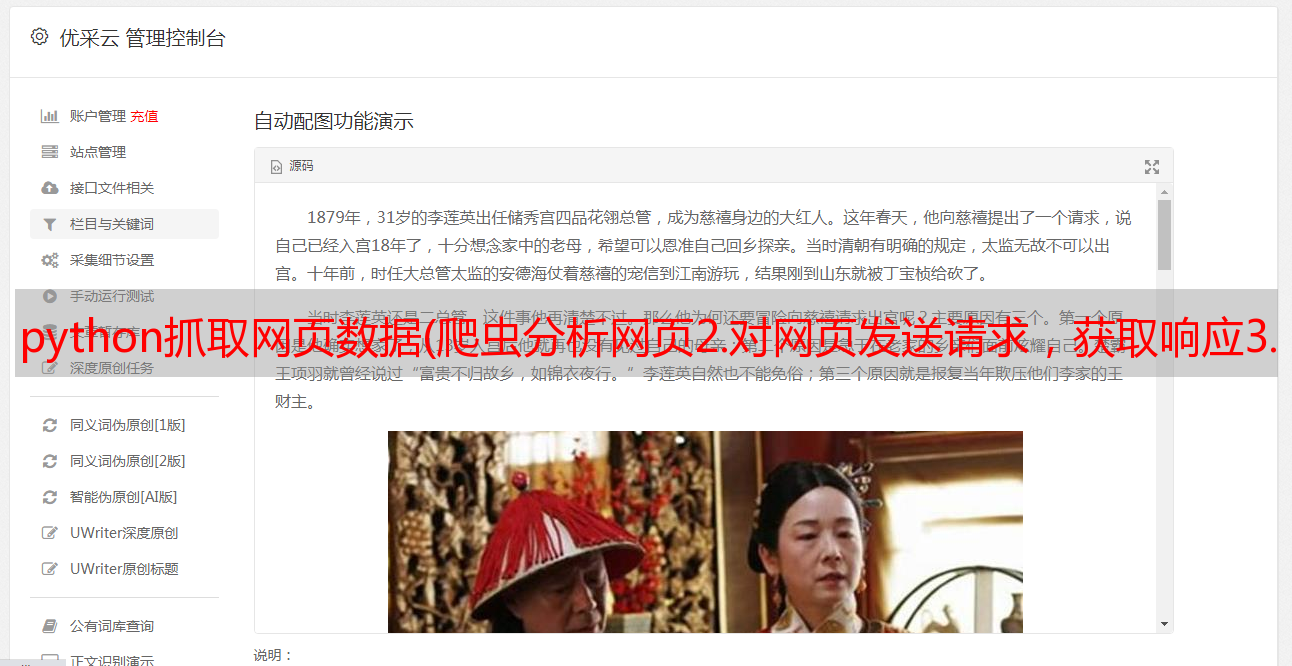

经过上面的分析,你可以向链接发送请求,但是这个网站和其他地方不同。他返回给你的不是html源码,也不是json数据,而是字符数据。如图所示:

我们可以看到这些不同的html和json数据,所以我们需要使用正则表达式来过滤和提取。经过上面的分析,我的大致思路是先爬取一页数据,使用正则抽取成功爬取一页数据,然后再做一个循环爬取多页数据。

代码部分:

构建请求所需的参数

###

###Python学习交流Q群:906715085####

def get_params(self):

"""

构建params参数的方法

:return:

"""

params = {

"t": "1",

"lx": "1",

"letter": "",

"gsid": "",

"text": "",

"sort": "zdf,desc",

"page": f"{str(self.page)},200",

"dt": str(self.TIMESTRF),

"atfc": "",

"onlySale": "0",

}

return params

上面提到的dt参数是一个不规则的时间戳,那我们该怎么办呢?思路是用time模块先提取出真正的当前时间戳,然后用int()强制成整数,再乘以1000,就可以得到这个不规则的时间戳。构造的时候可以把这个时间戳转换成str()。

int(time.time()) * 1000

发送请求,获取响应数据

def parse_url(self, url):

"""

发送请求,获取响应数据的方法

:param url:

:return:

"""

params = self.get_params()

response = requests.get(url, headers=self.headers, params=params)

if response.status_code == 200:

return response.content.decode()

提取数据

def get_data(self, data_str):

"""

提取基金数据的方法

:param data_str:

:return:

"""

str_data = re.findall('var db=.*,datas:(.*),count:.*}', data_str, re.S)[0]

data_list = eval(str_data)

for data in data_list:

yield {

'基金代码': data[0],

'基金简称': data[1],

'单位净值': data[3],

'累计净值': data[4],

'日增长值': data[6],

'日增长率': data[7],

'手续费': data[17]

}

实现方案的完整思路

def run(self):

"""

实现主要逻辑思路

:return:

"""

with open('./jjData.csv', 'a', encoding='utf-8-sig', newline="") as csvfile:

fieldnames = ['基金代码', '基金简称', '单位净值', '累计净值', '日增长值', '日增长率', '手续费']

write_dict = csv.DictWriter(csvfile, fieldnames=fieldnames)

write_dict.writeheader()

# 1,发送请求,获取响应数据

data_str = self.parse_url(self.API_URL)

# 2,提取数据

fund_data_list = self.get_data(data_str)

for fund_data in fund_data_list:

print(fund_data)

# 3,保存数据

write_dict.writerow(fund_data)

显示结果

结尾

最后,这里没有更多了。不明白的可以关注视频再学习。本文文章到此结束。喜欢的可以点赞,不明白的可以评论留言。