python抓取网页数据(python爬虫的代理ip必不可少的收获与见解!(组图))

优采云 发布时间: 2022-03-21 09:14python抓取网页数据(python爬虫的代理ip必不可少的收获与见解!(组图))

这几年,python的人气特别火爆!在大学期间,我也做了一些深入的研究。毕业后,我也尝试过用python作为我的职业方向。虽然我没有如愿成为一名 Python 工程师,但掌握 Python 也让我现在的工作和职业发展更有效率。便利。本期文章主要与大家分享我在python爬取方面的收获和感悟。

Python爬虫是最熟悉的python应用方式。因为python有丰富的第三方开发库,所以可以进行很多工作:比如web开发(django),应用程序开发(tkinter,wxpython,qt),数据统计和计算(numpy),图形和图像处理,深度学习、人工智能等。我一般用python爬虫(结合tkinter开发爬虫应用),用django开发一些小个人网站,django框架可以根据实体类自动生成管理端,大大提高了系统的开发效率,感兴趣的朋友可以试试。

一个成功的爬虫需要对应一个标准化的网站。爬虫主要是为了方便我们获取数据。如果目标系统的开发不规范,没有规则,很难用爬虫定制一套规则来爬取,而爬虫基本是定制的,需要针对不同的系统进行调整。

首先,如果你想做一个好的爬虫,一个好的代理IP是必不可少的

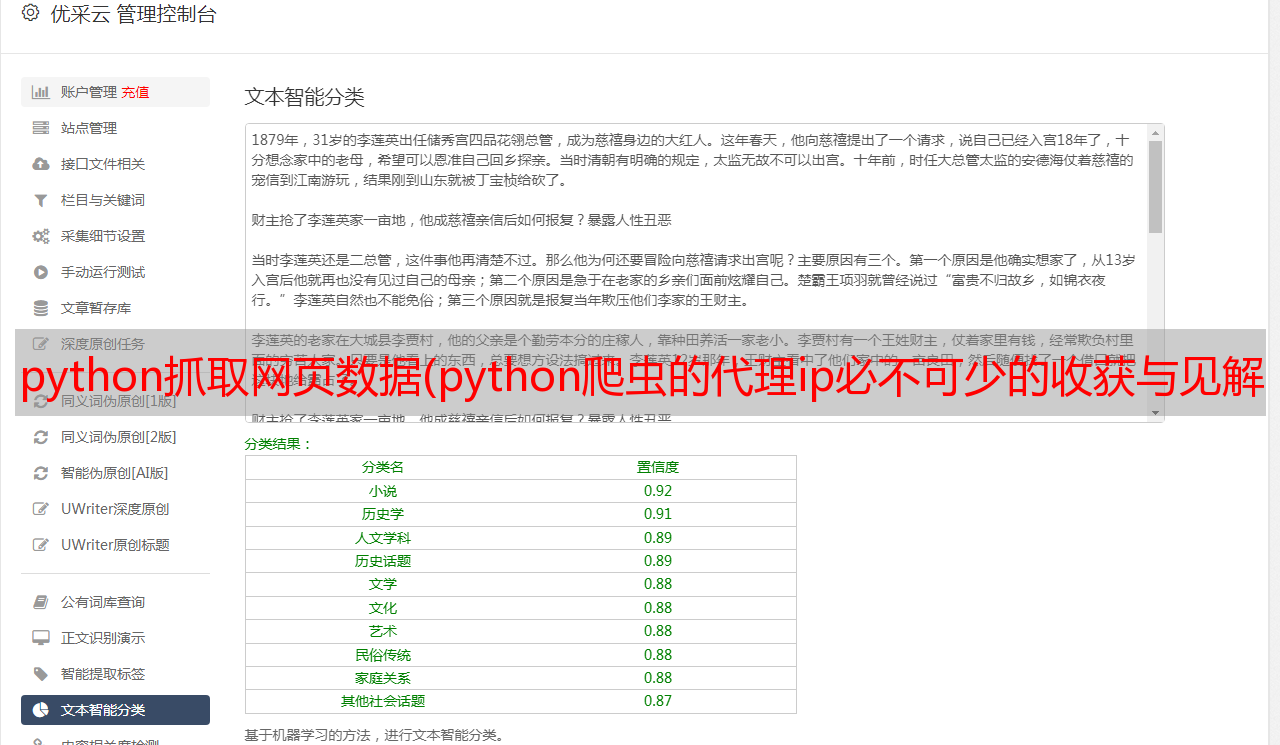

这里推荐一个适合爬虫的代理ip---代理云

爬虫小伙伴可以去获取免费代理IP试试

国产优质动态IP。限时2-10分钟,现在注册即可免费领取10000个代理IP

爬虫爬取数据的第一步是分析目标网站的技术和网站数据结构(通过前端源码),可以借助铬浏览器。目前python爬虫主要面对三种网站:

1.前后端分离网站

前端通过传参访问接口,后端返回json数据。对于这种网站,python可以模拟浏览器前端,发送参数然后接收数据,完成爬虫数据的目标。

2. 静态网站

通过python的第三方库(requests、urllib),下载源码,通过xpath,正则匹配数据

3.动态网站

如果采用第二种方式,下载的源码只是简单的html,源码中没有数据,因为这种动态的网站需要加载js,源码会有数据,对于这种类型的 网站 ,可以使用自动化测试工具 selenium

爬虫步骤:

1.分析网站技术和目标数据结构

2.根据第一步分析结构,选择对应的技术策略

3.爬取数据

4.提升性能,提升操作舒适度(结合客户端技术定制爬虫界面)

5.按需进行数据清洗

6.数据存储,存储到数据库,文档等。

防裂机制:

1. 当系统判断属于同一个ip的客户端有不间断的多次访问时,会拒绝访问这个ip

解决方法:动态代理,不断改变ip访问目标系统,或者从免费ip代理网站爬取ip,创建ip池,如果目标数据量不大,可以降低访问速度,避免反向挑选

2. 目标系统需要注册登录才能访问

解决方法:通过python的第三方库(Faker)生成假的登录名、密码、*敏*感*词*进行自动注册登录

3. 需要处理目标系统中目标数据页面的链接,才能进入目标数据页面进行访问

解决方法:目标网站的目标数据页链接无法正常访问。需要研究页面中的js脚本并处理链接。我个人使用搜狗浏览器爬取了微信账号文章。,我也遇到过这个问题,爬取的文章链接需要拼接到js脚本中才能得到正确的链接地址

从哪里获取目标数据:

通过xpath获取数据的位置,可以使用chrome浏览器调试功能获取对应数据的xpath路径

通过正则匹配

Python爬虫第三方常用库:

抓取静态网页数据:

抓取前后端分离系统的数据:

抓取动态数据:

以下代码示例使用 Google 浏览器,使用 selenium 库,并将浏览器设置为无头模式。爬虫会配合浏览器在后台模拟人工操作。根据代码中定义的xpath地址,爬虫会在浏览器中找到对应的位置。操作,使用selenium爬取数据时,需要安装对应版本的浏览器驱动

作为合法公民,爬虫只是一种技术。当我们使用它来爬取目标数据时,我们必须遵循一定的规则。每个 网站 的根目录下都会有一个 robots.txt(爬虫协议)文件,里面规定了可以访问哪些网页。在爬取公开信息和数据时,不会对目标系统造成严重破坏。因此,我们呼吁大家在使用各种技术开展工作的过程中,要遵守各种技术。规章制度规范,共同营造你我他文明的网络环境!

———————————————

版权声明:本文为CSDN博主“菜鸟阿杜”的原创文章,遵循CC4.0 BY-SA版权协议。转载请附上原文出处链接和本声明。

原文链接:python爬虫数据采集_rookie adu-CSDN博客_python数据采集代码