seo深度解析:全面挖掘搜索引擎优化的核心秘密(2.1.2Spider的抓取策略在大型搜索引擎Spider的搜索引擎抓取过程)

优采云 发布时间: 2022-03-08 05:03seo深度解析:全面挖掘搜索引擎优化的核心秘密(2.1.2Spider的抓取策略在大型搜索引擎Spider的搜索引擎抓取过程)

2.1.2蜘蛛的爬行策略

在大型搜索引擎Spider的爬取过程中,有很多策略,有时可能会使用多种策略的组合。这里简单介绍一个比较简单的爬虫抓取策略,帮助大家了解爬虫的工作流程。蜘蛛抓取网页。在尝试爬取尽可能多的网页的前提下,首先要注意的是避免重复爬取。为此,爬虫程序一般会建立已爬取的URL列表和待爬取的URL列表(实际上是通过Hash表来记录URL的两种状态)。爬取新页面时,提取页面上的链接,将提取的链接与爬取的URL列表中的链接一一进行对比。如果发现链接已经被爬取过,则直接丢弃。

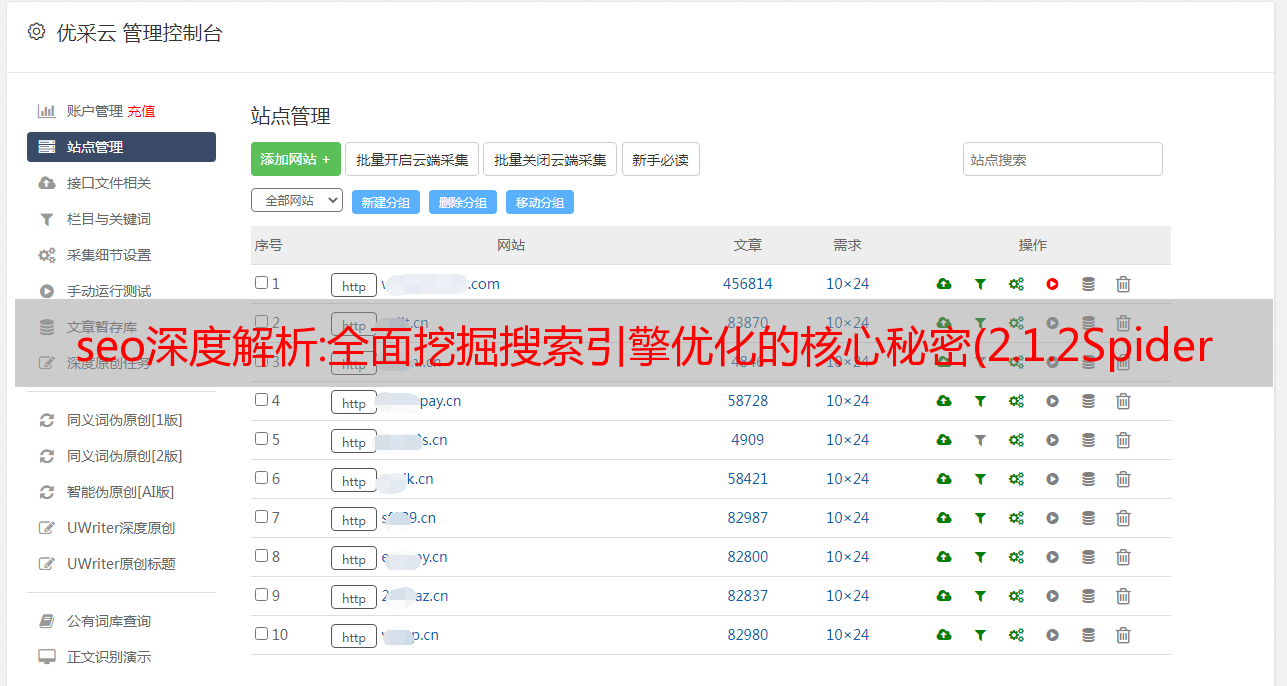

蜘蛛眼中的网页可以分为以下四类,如图2-2所示。

图 2-2 Spider 眼中的互联网网页

(1)被爬取的页面,即Spider已经爬取的页面。

(2)要爬取的页面,即这些页面的url已经被加入到Spider要爬取的url队列中,但是还没有被爬取。

(3)页面可以被爬取,Spider最终可以根据网上的链接关系找到这些页面,也就是说这些页面的存在,目前可能不知道,但是随着爬取增量Spider,最终会发现这些页面的存在。

(4)暗网中的页面,这些页面与地表的网页解耦,这些页面中可能存在上述三类网页的链接,但是通过以上三类网页,比如网站内需要手动提交查询获取的网页被归类为暗网,估计暗网比非暗网大几个数量级网页。

全文搜索引擎Spider一直致力于爬取全网数据。现在 Spider 拥有大量针对非暗网页面的高效爬取策略。对于暗网的爬取,各个搜索引擎都在努力研究各自不同的蜘蛛爬取策略。百度推出“阿拉丁”计划,鼓励网站拥有优质资源直接使用站内资源以XML文件形式提交给百度,百度将直接抓取并展示优先级排行。这里主要讨论Spider对非黑暗网页的爬取策略。

当 Spider 从一个入口页面开始爬取时,它会获取该页面上所有的外链。当 Spider 随机抓取其中一个链接时,它也会采集到很多新的链接。此时Spider面临一个抓取方式的选择:

(1)跟随一个链接逐层爬取,直到该链接到达末尾,然后再回来按照同样的规则爬取其他链接,即深度优先爬取策略。

(2)最好先爬取入口页面中的链接,将新发现的url依次排列入库,然后遍历爬取这些新发现的页面,再将新发现的url放入库中排列等待抢,依次抢,即广度优先的抢策略。

① 深度优先策略

深度优先策略是一条路走黑路,当一条路走不通时,再回去走另一条路。图2-3为深度优先爬取策略*敏*感*词*。假设页面A是Spider的入口,Spider在页面A上找到了三个1、7、11页面的链接,然后Spider就会按照图中数字表示的顺序抓取。当第一条路径抓取3页结束时,会返回2页抓取第二条路径中的4页,如果也抓取了4页,则返回1页抓取第三条路径。5页,一直抓着。抓到人头后,它会按照之前的规则,一个一个的去抓。

图 2-3 深度优先策略

②广度优先战略

广度优先策略是指当Spider在一个页面上发现多个链接时,并不会一路黑下去继续跟踪一个链接,而是先爬取这些页面,然后再爬取从这些页面中提取出来的页面。关联。广度优先爬取策略*敏*感*词*如图2-4所示。假设页面A是Spider的入口,Spider在页面A上找到了三个页面1、2、3,爬取了1个页面后,只是把1个页面中的4和5个页面的链接放入待爬取的URL列表,不会继续爬取1页中的其他链接,而是2页。当b级页面爬取完成后,从b级页面提取到c级页面的4、5、6、7、8、会被抓取 9. 六页。c级页面爬取后,

图 2-4 广度优先策略

理论上,无论Spider采用深度优先策略还是广度优先策略,只要有足够的时间,它都可以爬取互联网上的整个网页。但是,搜索引擎本身的资源也是有限的。快速爬取互联网上有价值的页面只是一种奢望。因此,搜索引擎的蜘蛛并不仅仅使用一种策略无限抓取新页面,而是采用两种策略。联合捕获的方法。一般来说,Spider 可以在域级别的页面上使用广度优先的爬取策略来采集尽可能多的网站。在网站的内页级别,一般根据网站的权重采用广度和深度优先的爬取策略。也就是说网站的权重越高,爬取的量就越大。新推出的网站可能只在一个主页上被抓到。这也是很多新的网站只有首页在搜索引擎中被索引一段时间的原因之一。

上面讨论的这两种策略是需要根据Spider只是想捕获整个互联网数据来选择的策略。事实上,在搜索引擎中,Spider虽然在尽力保证爬取页面的全面性,但由于资源有限,在尽力爬取全网的同时,也必须考虑重要页面的优先爬取。这个“重要页面”的定义应该是指互联网中比较重要的页面,页面的内容应该具有影响力比较大、需要了解内容的网民较多、或者传播时效性比较强的特点。体现在爬取策略上,就是这个页面有很多入链,或者是具有高权限的大型网站中的网页。总结起来有两种策略:重要网页的优先爬取策略和大型站点链接的优先爬取策略。

(1)重要页面优先爬取策略

一般认为,一个页面的重要性,除了受主站本身质量和权重的影响外,还取决于传入链接的数量和传入链接的质量。蜘蛛爬取级别的“重要页面”一般由传入链接决定。在上面讨论的爬取策略中,Spider一般将新发现的未被爬取的URL依次放在待爬取URL队列的末尾,等待Spider依次爬取。在重要页面优先爬取的策略中并非如此。被爬取的 URL 队列的顺序是不断变化的。排序是根据页面获取到的爬取页面的链接数和链接权重的高低来进行排序的。如图2-2所示,按照一般的抓取策略,

(2)大网站优先策略

大站优先策略,这个思路很简单。被搜索引擎认可为“大站点”的网站必须有稳定的服务器、良好的网站结构、优秀的用户体验、及时的信息内容、权威的相关信息、丰富的内容类型和海量网页等特点,当然也会相应地产生大量高质量的反向链接。也就是说,在一定程度上可以确定,这些网站的内容能够满足相当一部分网友的搜索请求。为了在有限的资源范围内尽量满足大部分普通用户的搜索需求,搜索引擎一般都会对大站“特别照顾”。所以,可以看到,新浪和网易网站上几乎所有自发的内容都会被百度秒级接收,因为百度在这些网站上搜索Spider是7×24小时不间断的爬取。如果这些网站 重要页面上出现了指向新站点的链接,它也会被快速抓取并相应地收录。有朋友曾经尝试过秒接收新站点的策略:将新站点的链接推送到一些大站点的首页,或者挂在大站点首页推荐的页面上,效果非常好。因此。有朋友曾经尝试过秒接收新站点的策略:将新站点的链接推送到一些大站点的首页,或者挂在大站点首页推荐的页面上,效果非常好。因此。有朋友曾经尝试过秒接收新站点的策略:将新站点的链接推送到一些大站点的首页,或者挂在大站点首页推荐的页面上,效果非常好。

这两种策略与前面结合广度优先策略和深度优先策略讨论的抓取方法有一些共同点。比如从另一个角度来说,如果Spider按照前两种策略进行爬取,那么一个页面获取的传入链接越多,被提前抓到的概率就越大,也就是类似于重要页面的优先爬取; 在蜘蛛资源有限的情况下,广度优先策略和深度优先策略的组合会根据站点的大小区别对待。大型 网站 页*敏*感*词*有内在的高度重要性,并且通常很容易获得更多的链接支持。因此,从宏观上看,

与整个互联网的网页相比,Spider的资源即使充足也是有限的。因此,一个优秀的Spider程序应该首先保证重要网页的抓取,然后在互联网网页上尝试抓取尽可能多的信息。从中也可以看出,依靠外链引导Spider,提升网站权重,以及长期依靠内容操作网站权重的重要性。6UY9moKsfFGLxXkde0zN5ugImRzvam03ha26o/gnkrThKhvRAqR8bETSbp42Gy4D