爬虫抓取网页数据(Linux命令分析之nginx服务器进行分析日志文件所在目录:)

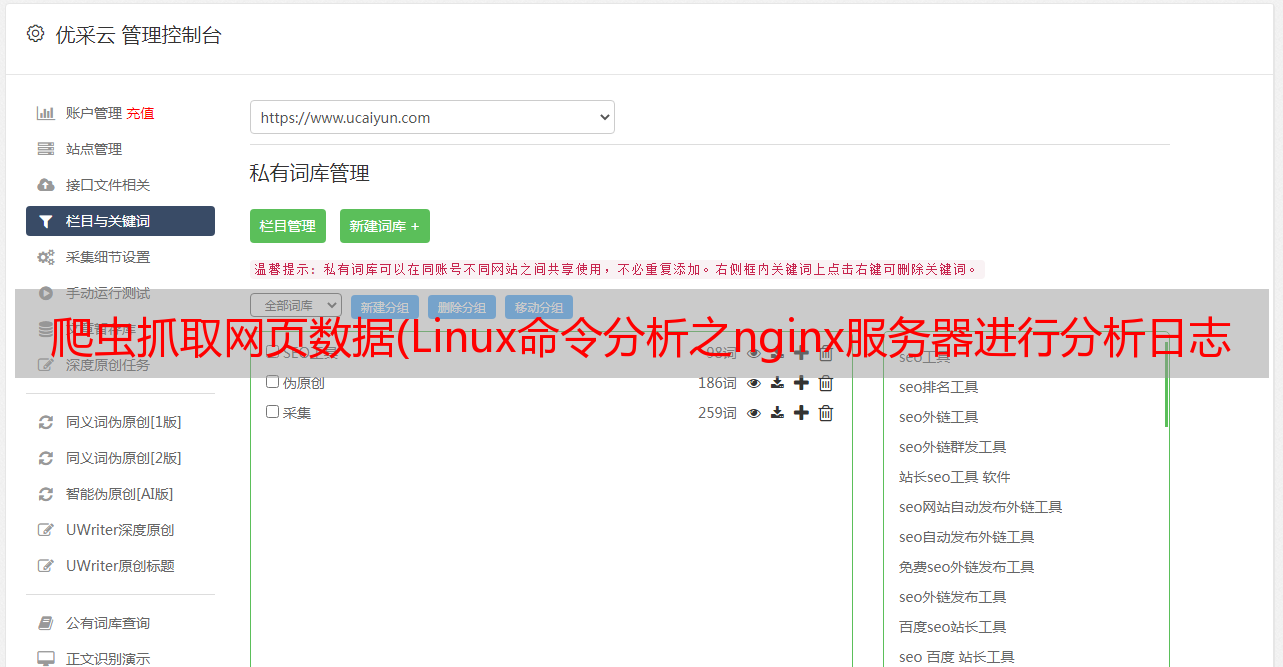

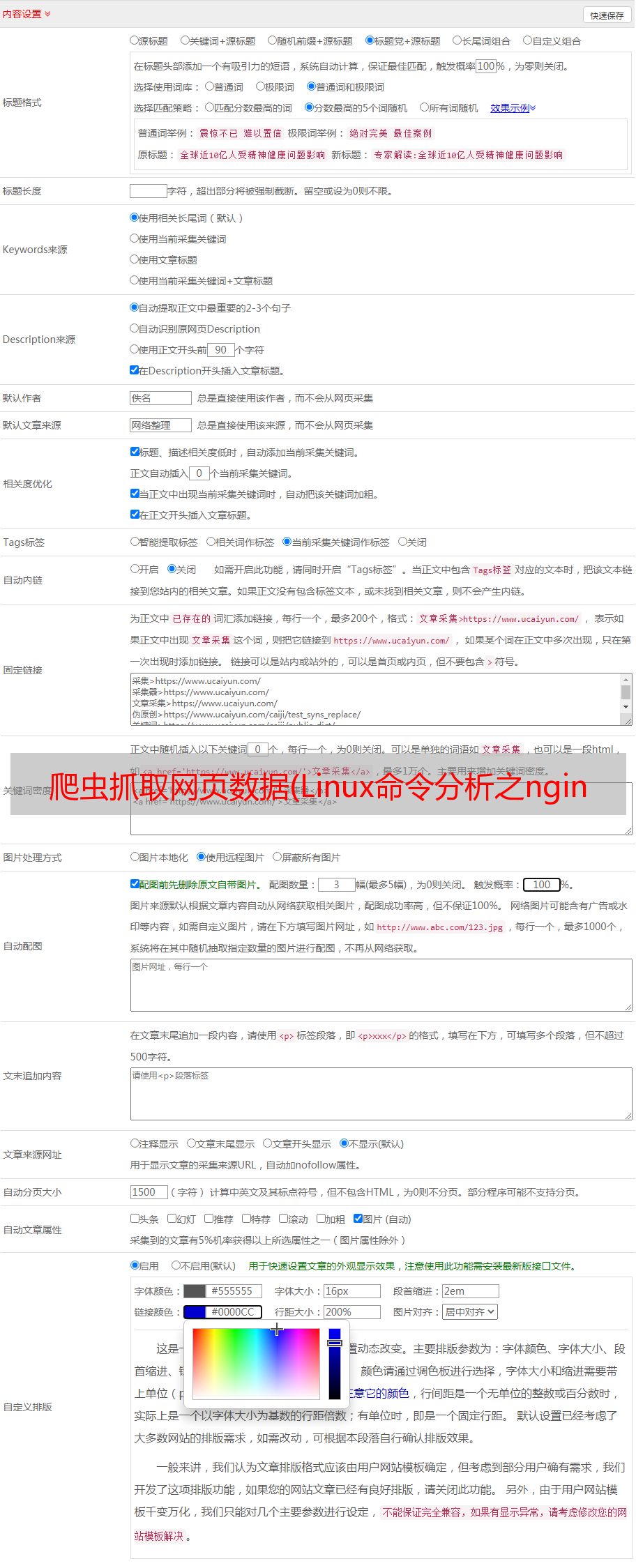

优采云 发布时间: 2022-03-02 17:00爬虫抓取网页数据(Linux命令分析之nginx服务器进行分析日志文件所在目录:)

概述

最近阿里云经常被各种爬虫访问,有的是搜索引擎爬虫,有的不是。通常这些爬虫都有UserAgent,我们知道UserAgent是可以伪装的。UserAgent 的本质是 Http 请求头中的一个选项设置。,您可以以编程方式为请求设置任何 UserAgent。

下面的Linux命令可以让你清楚的了解蜘蛛的爬行情况。我们分析nginx服务器。日志文件位于目录:/usr/local/nginx/logs/access.log。access.log 文件应该记录最后一天的日志情况。首先,请检查日志大小。如果比较大(超过50MB),建议不要使用这些命令进行分析,因为这些命令会消耗大量CPU,或者更新并在分析机上执行,以免影响服务器性能。

常见的蜘蛛域名

常用蜘蛛的域名与搜索引擎官网的域名有关,例如:

1、统计百度蜘蛛爬取的次数

猫访问.log | grep 百度蜘蛛 | 厕所

最左边的值显示爬网次数。

2、百度蜘蛛详细记录(Ctrl C可以终止)

猫访问.log | grep 百度蜘蛛

您还可以使用以下命令:

猫访问.log | grep 百度蜘蛛 | 尾 -n 10

猫访问.log | grep 百度蜘蛛 | 头 -n 10

说明:只看后10个或前10个