网页qq抓取什么原理( 搜索引擎爬虫的工作流程及对照的思考方法)

优采云 发布时间: 2022-03-01 19:13网页qq抓取什么原理(

搜索引擎爬虫的工作流程及对照的思考方法)

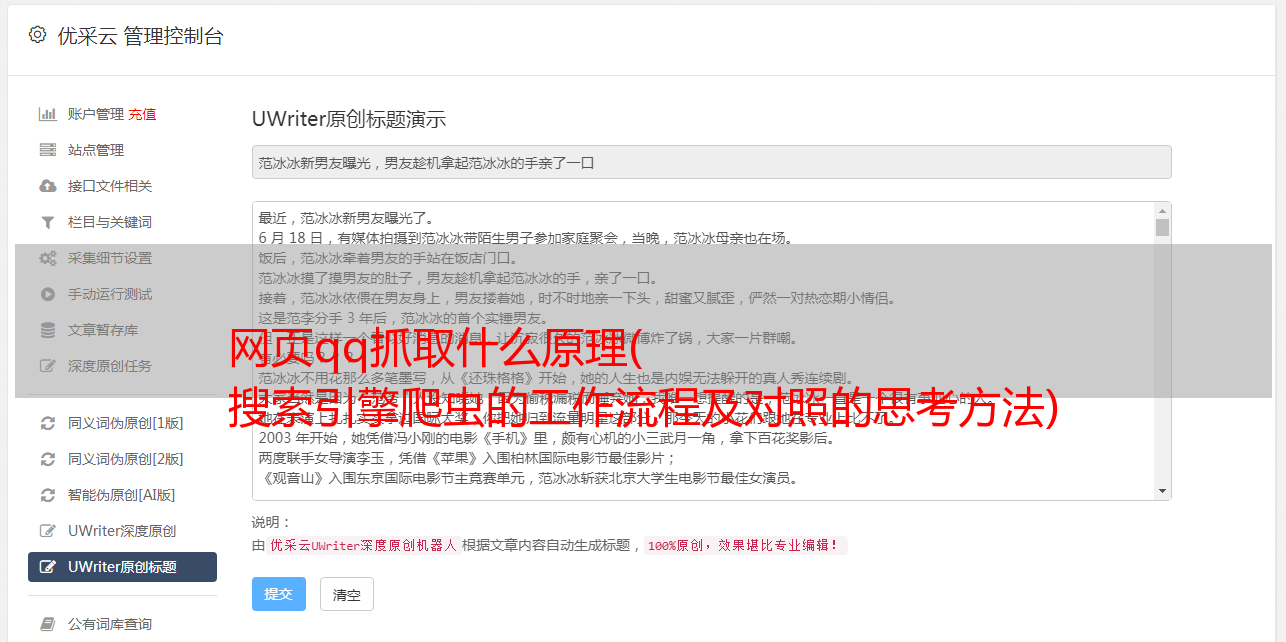

搜索引擎爬虫的工作流程是SEO的基础篇章,也是每一个从事SEO工作的同事都应该掌握的必备知识。PHPSEO刚刚整理完毕并画了一张图,让你即使不懂技术也能了解搜索引擎爬虫的工作流程。一起来聊聊吧。

如上图所示,请您在阅读以下内容时与我一起思考。

1、*敏*感*词*网址

1、所谓*敏*感*词*URL,是指开头选择的URL地址。大多数情况下,网站的首页、频道页等内容更丰富的页面都会作为*敏*感*词*URL;

然后将这些*敏*感*词*网址放入要爬取的网址列表中;

2、要爬取的url列表

爬虫从要爬取的 URL 列表中一一读取。在读取URL的过程中,会通过DNS解析URL,并将URL地址转换为网站服务器IP地址+相对路径的方法;

3、网页下载器

接下来,把这个地址交给网页下载器(所谓网页下载器,顾名思义,就是负责下载网页内容的模块;

4、源码

对于下载到本地的网页,也就是我们网页的源代码,一方面网页要保存在网页库中,另一方面又会从下载的网页中重新提取URL地址.

5、提取网址

新提取的 URL 地址会在已爬取的 URL 列表中进行比较,以检查该网页是否已被爬取。

6、新的URL存放在待爬取队列中

如果网页还没有被爬取,新的URL地址会被放在待爬取URL列表的最后,等待被爬取。

这样,爬虫就完成了整个爬取过程,直到待爬队列为空。

然后下载的网页会进入一定的分析,分析后我们就能看到收录的结果。

对于真正的爬虫来说,哪些页面先爬,哪些页面后爬,哪些页面不爬,都有一定的策略。这里介绍一个比较常见的爬虫爬取过程。作为我们中的 SEO,我们已经足够了解这一点。