抓取网页数据违法吗( 网站通过Robots协议告诉爬虫哪些页面可以抓取文件? )

优采云 发布时间: 2022-02-24 19:05抓取网页数据违法吗(

网站通过Robots协议告诉爬虫哪些页面可以抓取文件?

)

2.当 网站 声明 rebots 协议时。

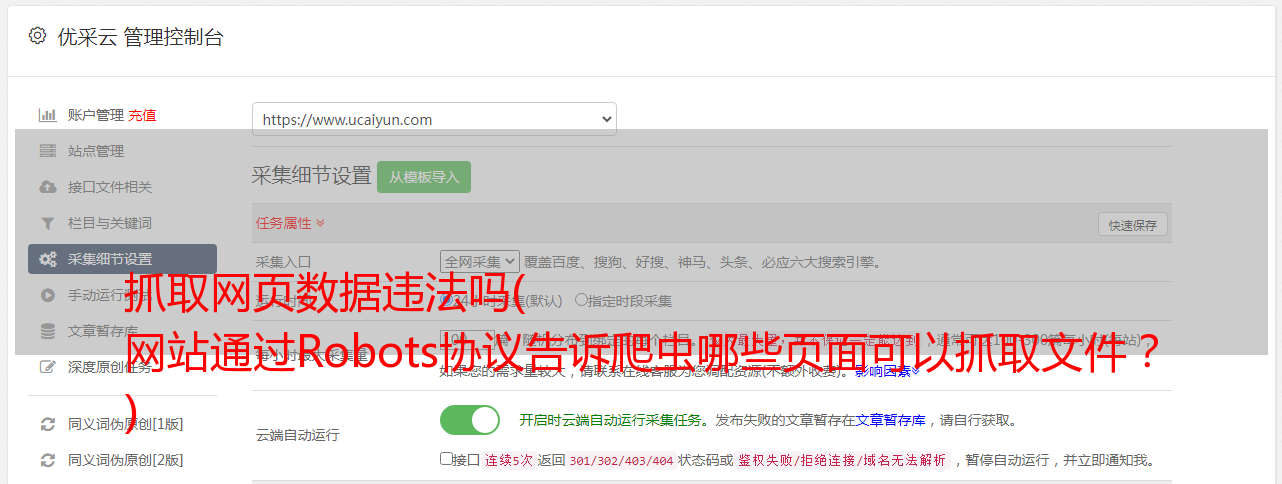

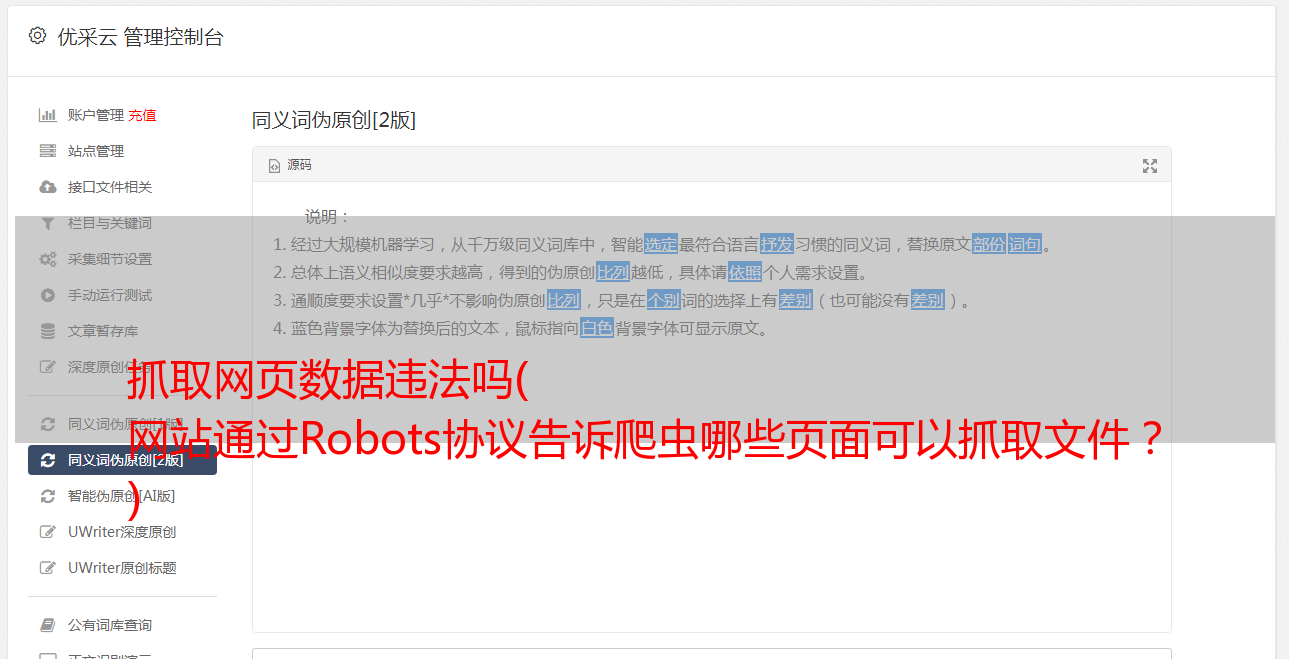

Robots Protocol(也称Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”。网站机器人协议告诉爬虫哪些页面可以爬取,哪些页面不能爬取。

robots.txt 文件是一个文本文件,可以使用任何常见的文本编辑器(例如 Windows 附带的记事本)创建和编辑。robots.txt 是协议,而不是命令。robots.txt 是搜索引擎在访问 网站 时查看的第一个文件。robots.txt 文件告诉蜘蛛可以查看服务器上的哪些文件。

如何检查采集的内容是否有rebots协议?

方法很简单。如果您想查看它,请在 IE 上输入您的 URL/robots.txt。如果有专业的相关工具可以查看和分析机器人,可以使用站长工具。

爬虫作为一种计算机技术,决定了它的中立性,所以爬虫本身并没有被法律禁止,但是利用爬虫技术获取数据是违法的,甚至是*敏*感*词*的。

例如:像谷歌这样的搜索引擎爬虫每隔几天就会扫描整个网页供大家查看,而大多数网站扫描的网站都非常高兴。这被定义为“善意的爬行动物”。但是像抢票软件这样的爬虫被定义为“恶意爬虫”。

爬行动物带来的风险主要体现在以下三个方面:

违背网站的意志,如网站采取反爬措施后,强行突破其反爬措施;

爬虫干扰访问的网站的正常运行;

爬虫抓取某些类型的受法律保护的数据或信息。

解释爬虫的定义:网络爬虫,也称为网络蜘蛛,是一种用于自动浏览万维网的网络机器人。

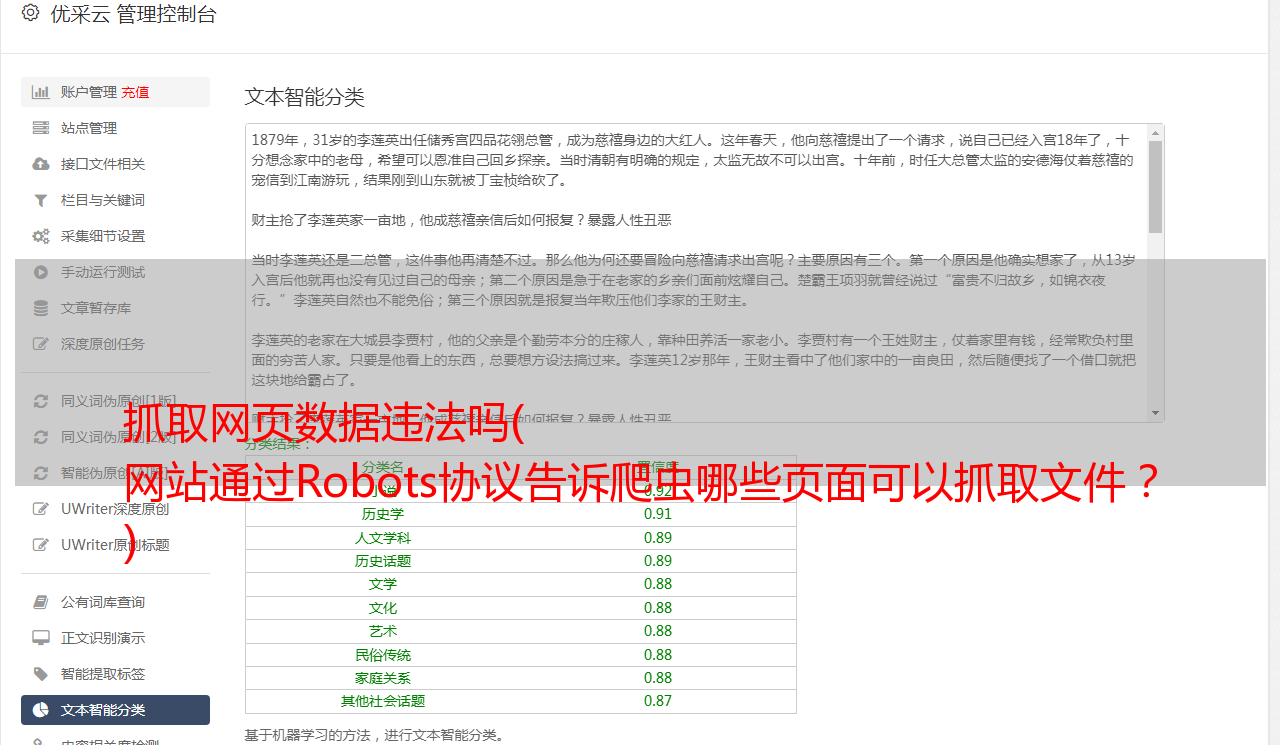

网络爬虫爬取的数据有以下规则:

√ 数据全面披露

√ 没有未经授权的访问和爬取

常见误解:认为爬虫是用来抓取个人信息的,与基本信用数据有关。

一般来说,技术是无罪的。

但是,如果您使用技术来抓取他人的隐私和业务数据,那么您就是在藐视法律!

结尾