搜索引擎禁止的方式优化网站( 如何禁止搜索引擎蜘蛛访问我们的网站?.txt文件)

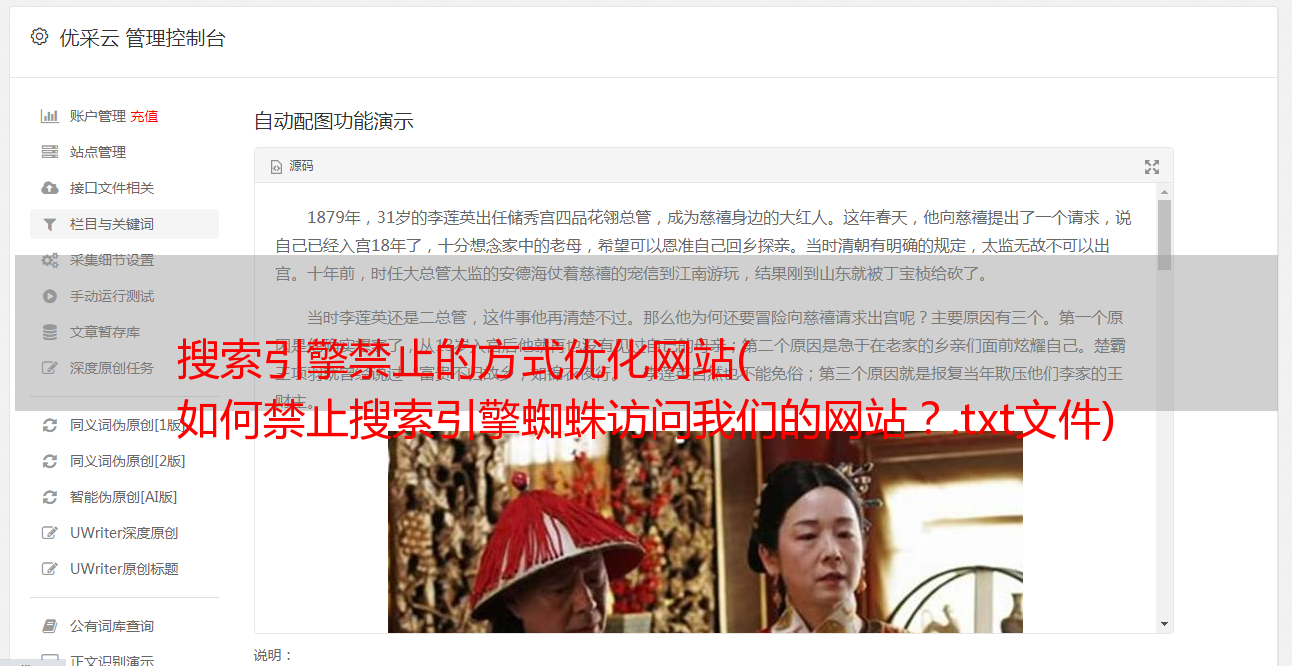

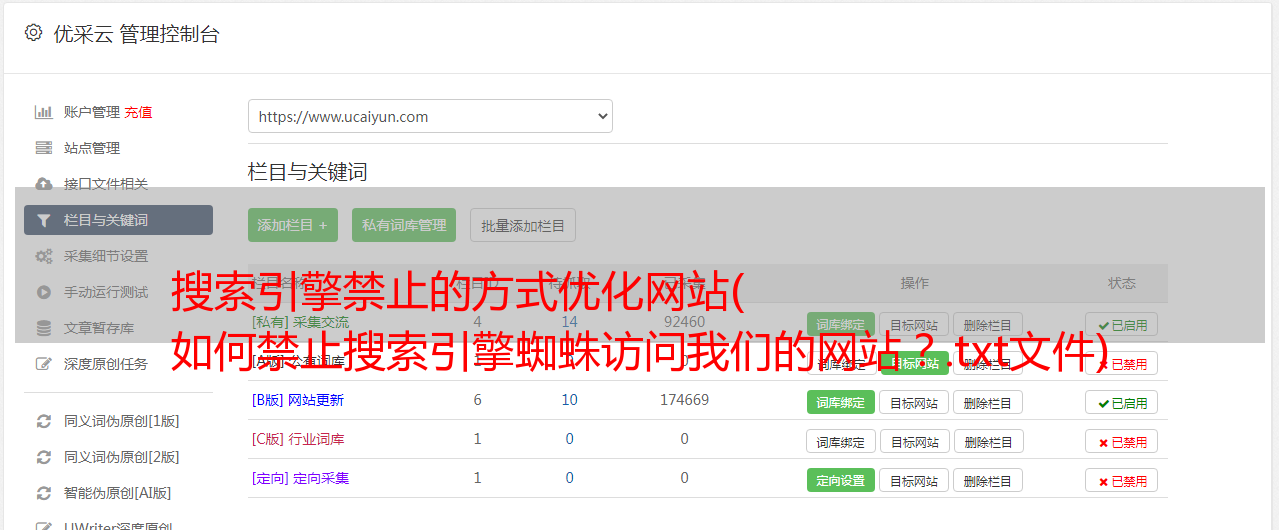

优采云 发布时间: 2022-02-18 20:16搜索引擎禁止的方式优化网站(

如何禁止搜索引擎蜘蛛访问我们的网站?.txt文件)

在网站确定结构和内容之前,我们的首要任务就是阻止搜索引擎蜘蛛爬取网站,从而减少搜索引擎收录网站@的数量> 可能。有的朋友会问,为什么要这样做?因为我们的网站TKD可能会在建站的时候修改,网站结构会不断调整,会长期影响搜索引擎蜘蛛的惠顾,不利于< @网站 搜索引擎优化。那么,我们如何防止搜索引擎蜘蛛访问我们的 网站?跟着服务器往下看就知道了!

创建一个 robots.txt 文件并将该文件放在 网站 根目录中。

robots.txt 是搜索引擎在访问 网站 时查看的第一个文件。Robots.txt 文件告诉蜘蛛可以在服务器上查看哪些文件。robots.txt 是一个纯文本文件,网站管理员可以在其中声明他们不想被机器人访问的 网站 部分,或者指定搜索引擎仅 收录 指定内容。

文件内容如下:

阻止所有搜索引擎访问 网站 的任何部分:

用户代理:*(网络蜘蛛)

不允许:/(拒绝)

(我们可以在网站确定结构和内容之前使用这个写作内容)

例子:

用户代理:baiduspider

禁止:/folder1/

(禁止百度蜘蛛访问文件夹1)

用户代理:Googlebot

禁止:/folder2/

(禁止谷歌蜘蛛访问文件夹2)

当我们网站设置好可以上线的时候,记住一定要修改robots.txt文件中禁止所有蜘蛛访问网站的规则,否则会导致各大搜索引擎无法< @收录 我们 网站,所以不会有排名。

robots.txt文件一般只需要禁止搜索引擎蜘蛛访问:后台管理文件、程序文件、附件、图片、数据库文件、模板文件、样式表文件、编码文件、脚本文件等你认为你做的文件不需要访问。

例子:

禁止:/admin/(后台管理文件)

禁止:/require/(程序文件)

禁止:/attachment/(附件)

禁止:/images/(图像)

禁止:/data/(数据库文件)

禁止:/template/(模板文件)

禁止:/css/(样式表文件)

禁止:/lang/(编码文件)

禁止:/script/(脚本文件)

以上只是一个例子,不同程序的文件名不同,需要根据你使用的程序来编写。

还记得上面小编介绍的阻止搜索引擎蜘蛛访问网站的方法吗?如果您有任何问题,请在下方留言。