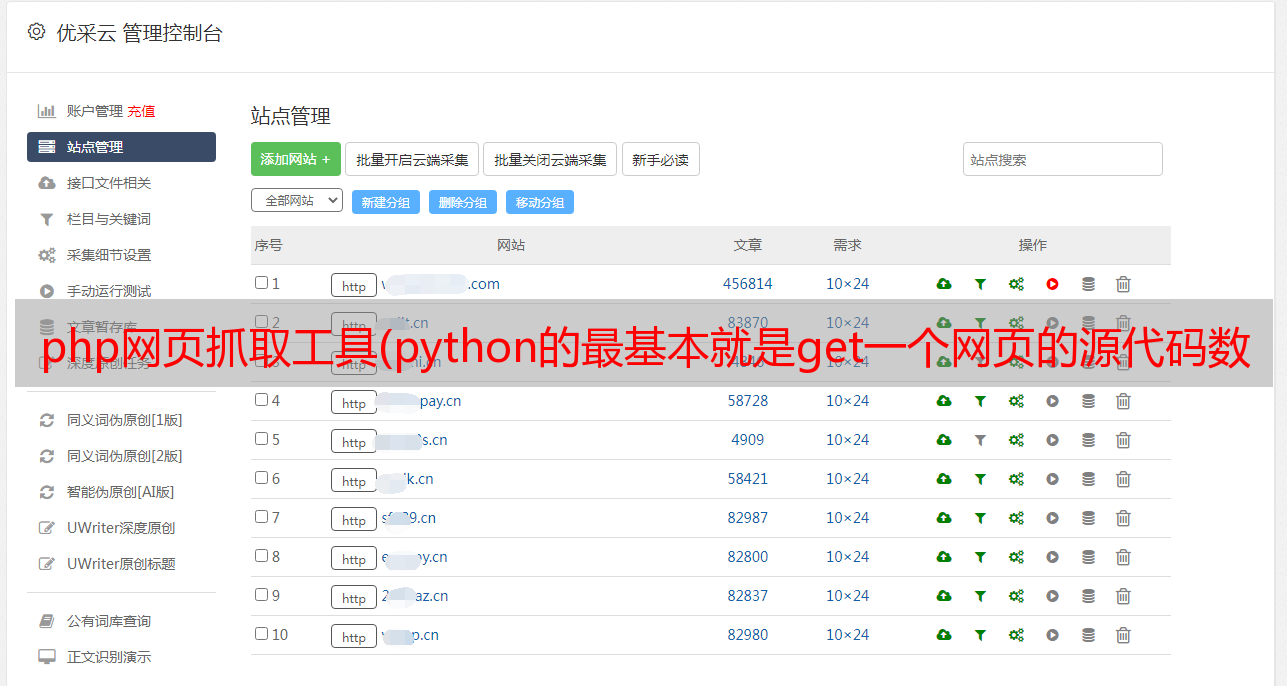

php网页抓取工具(python的最基本就是get一个网页的源代码数据,如果更初学爬虫 )

优采云 发布时间: 2022-02-08 19:00php网页抓取工具(python的最基本就是get一个网页的源代码数据,如果更初学爬虫

)

相关话题

python示例爬虫代码怎么做

11/8/202015:02:54

python爬虫代码示例的方法:先获取浏览器信息,使用urlencode生成post数据;然后安装 pymysql 并将数据存储在 MySQL 中。python爬虫代码示例的方法:1、urllib和BeautifulfuSoup获取浏览器

谈爬虫,绕过网站反爬机制

25/8/202018:04:17

【相关学习推荐:网站制作视频教程】什么是爬虫?简单地说,爬虫是一种自动与服务器交互以通过计算机获取数据的工具。爬虫最基本的就是获取一个网页的源代码数据。

初级爬虫一、获取某个类别下的所有页面地址

2/3/2018 01:10:32

总结:初学者,做个简单的爬虫深入理解python获取jb51书籍的列表和地址

谈爬虫,绕过网站反爬机制

15/12/2017 09:03:00

什么是爬虫?简单地说,爬虫是一种自动与服务器交互以获取数据的工具。

爬行动物和反爬行 - 爬行动物

2018 年 4 月 3 日 01:08:51

总结:爬虫与反爬——爬虫

Scrapy爬虫--02

2018 年 2 月 3 日 01:11:17

爬虫最基本的部分是下载网页,最重要的部分是过滤——获取我们需要的信息。而scrapy只是提供了这个功能:首先我们必须定义项目:Itemsarecontainersthatwillbeloadedwiththescrapeddata;它们工作起来像简单的pythondicts但是提供了额外的pro

为什么爬虫需要很多ip

2015 年 9 月 11 日:06:24

爬虫需要大量IP的原因:1、因为在爬取数据的过程中,经常被网站阻塞;不一样,还是刮掉空白数据。为什么爬虫需要很多IP

关于网络爬虫的事情:变相杀死爬虫

2009 年 11 月 8 日 14:29:00

在那些关于网络爬虫的事情中(一)提到如果爬虫伪装自己的User-Agent信息,就必须找到新的方法来阻止爬虫。其实对于网站来说,最大的挑战是如何准确识别一个IP发起的请求,是真实用户访问还是爬虫访问?

教你任意使用谷歌爬虫DDoS网站

30/6/201509:14:00

教你任意使用谷歌爬虫DDoS网站!Google 的 FeedFetcher 抓取工具将缓存电子表格的 =image("link") 中的所有链接。

简单高效的nodejs爬虫模型

2018 年 4 月 3 日 01:09:06

这篇文章解释了yunshare项目的爬虫模型。使用nodejs开发爬虫非常简单。你不需要像python的scrapy这样的爬虫框架。只需要使用 request 或 superagent 等 http 库即可完成大部分爬虫工作。使用nodejs开发爬虫半年左右,爬虫可以很简单也可以很复杂。一个简单的爬虫定向爬取一个网站,可能有几万或几十万的页面请求,复杂的爬虫类似于googlebot之类的搜索引擎

开源爬虫软件总结

2018 年 4 月 3 日 01:13:50

摘要:世界上有数百种爬虫软件。本文整理了比较知名和常见的开源爬虫软件,并按照开发语言进行了总结,如下表所示。虽然搜索引擎也有爬虫,但是这次我只总结爬虫软件,不是大型复杂的搜索引擎,因为很多兄弟只是想爬数据,而不是操作搜索引擎。

爬虫概述

2018 年 2 月 3 日 01:10:10

摘要:爬虫概述

hao123 简单的网络爬虫

2018 年 4 月 3 日 01:09:06

项目地址:github网络爬虫使用的主要技术是Jsoup和httpclientJsoup,用于解析网页数据,可以根据网页节点获取需要的数据。httpclient用于请求网页,获取整个网页数据。页面的域名和二级页面,即主模块在hao123首页的超链接,以及通过超链接包com.kunteng.crawler访问的页面上的所有链接;/*

Pythonscrapy爬虫爬取博乐在线所有文章并写入数据库

2018 年 4 月 3 日 01:10:02

博乐在线爬虫项目目的及项目准备:1.使用scrapy创建项目2.创建爬虫,博乐域名3.start_urls=['']4.爬取所有页面 文章5.文章列表页面需要数据 a) 缩略图地址 b) 详细 url 地址6.详细页面要提取的数据#博客标题#博客创建

33个可用于抓取数据的开源爬虫软件工具

2018 年 4 月 3 日 01:12:56

玩大数据,没有数据怎么玩?下面为大家推荐33款开源爬虫软件。爬虫,或称网络爬虫,是一种自动获取网页内容的程序。它是搜索引擎的重要组成部分,因此搜索引擎优化主要针对爬虫进行优化。网络爬虫是一种自动提取网页的程序。它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成部分。传统的爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL,在抓取网页的过程中不断地从当前页面中提取新的URL。