js 爬虫抓取网页数据(JS搭建后台环境始终略为麻烦,可不可以直接在浏览器客户端直接实现)

优采云 发布时间: 2022-02-04 20:20js 爬虫抓取网页数据(JS搭建后台环境始终略为麻烦,可不可以直接在浏览器客户端直接实现)

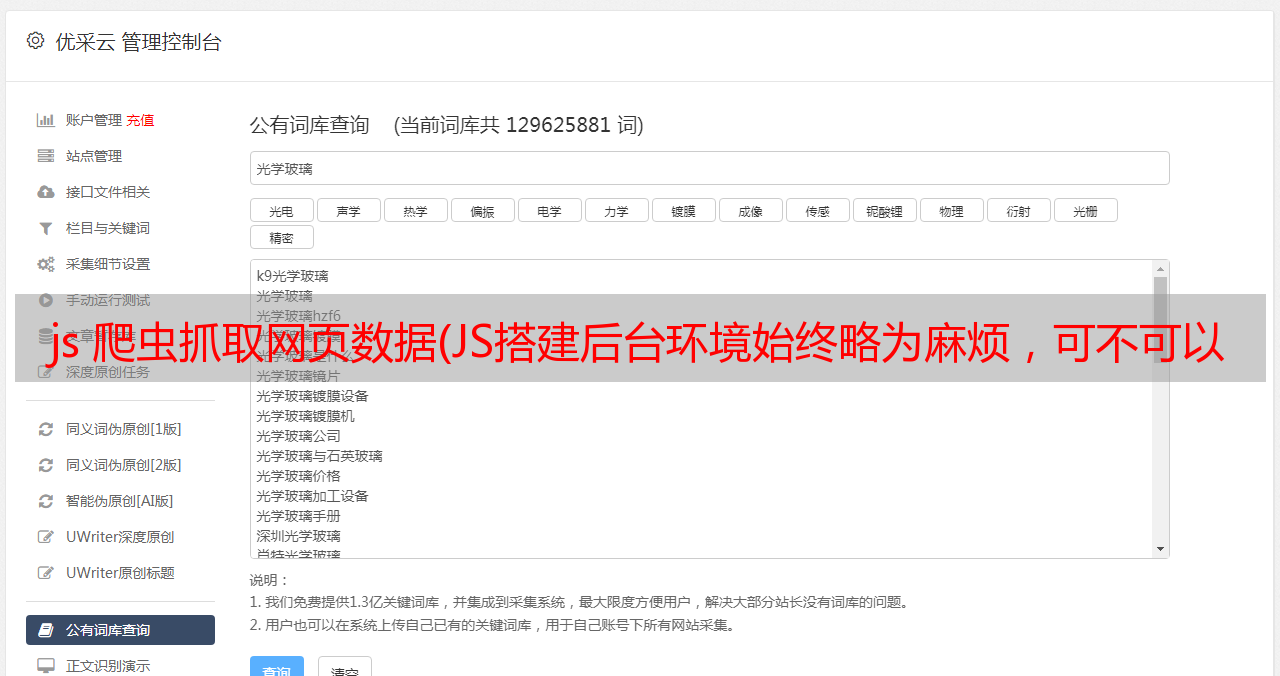

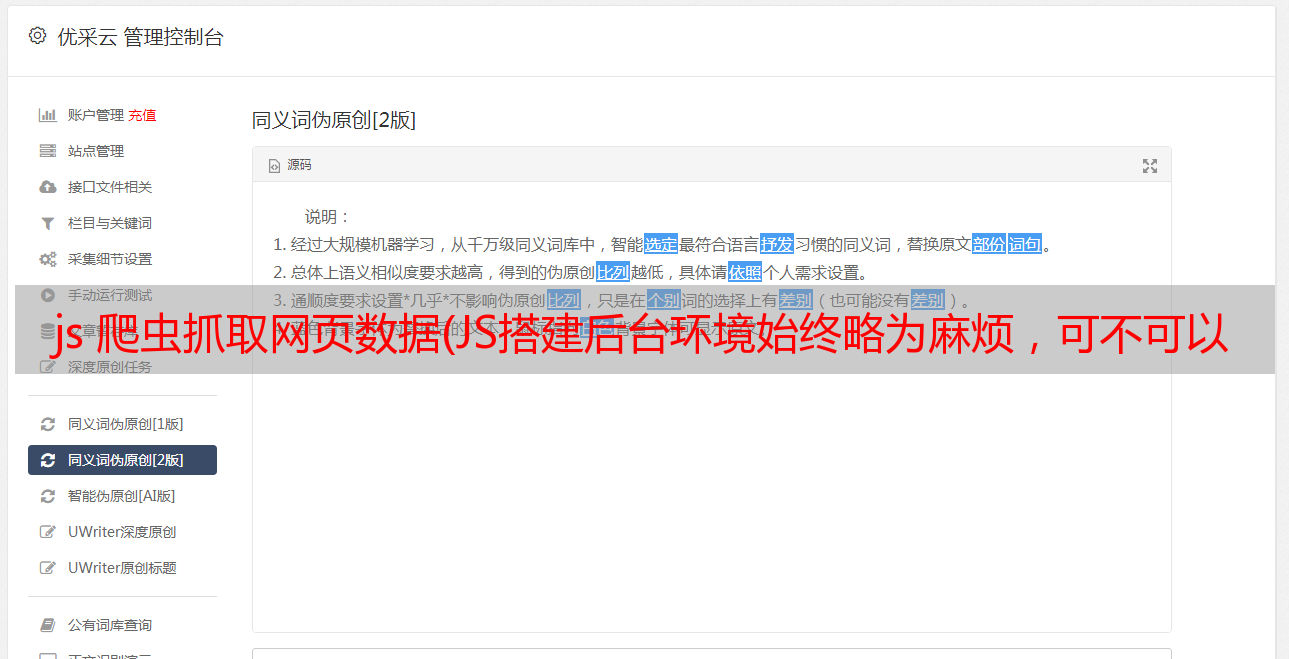

JS 是一种神奇的语言。有了Node.js的后端环境,我们就可以开发相应的爬虫了。不过搭建后台环境总是有点麻烦。当你拿到一台新电脑时,你不需要配置环境。可以直接在浏览器客户端实现吗?

答案肯定是肯定的。这里简单介绍一下在浏览器客户端实现爬取页面数据的爬虫。

爬虫,简单来说就是发送一个请求,然后按照一定的逻辑解析得到的数据。在 Node 环境下,可以使用 Request 模块请求地址,获取返回信息,然后使用正则匹配数据,或者使用 Cheerio 模块进行包装,方便定位相关标签。

在浏览器环境下也是类似的,可以使用标签的src属性或者ajax请求地址,获取返回信息,然后使用正则匹配的数据,或者使用jQuery模块进行包装——很方便定位相关标签项

实现的本质是打开浏览器的开发者工具,写一段JS代码注入到页面中,然后让相关代码自行执行地址请求,再通过代码处理返回的数据,打开Chrome浏览器的开发者工具,选择面板。在sources部分,选择二级菜单的script snippets部分,然后右键新建脚本,在右侧输入你要注入的代码,然后右键scriptsnippets脚本运行(或者使用快捷键 Ctrl + Enter 运行)开始注入,你可以在下面的控制台部分看到相应的结果。注入JS代码的方式是使用一个script标签来定义src指向的脚本地址,