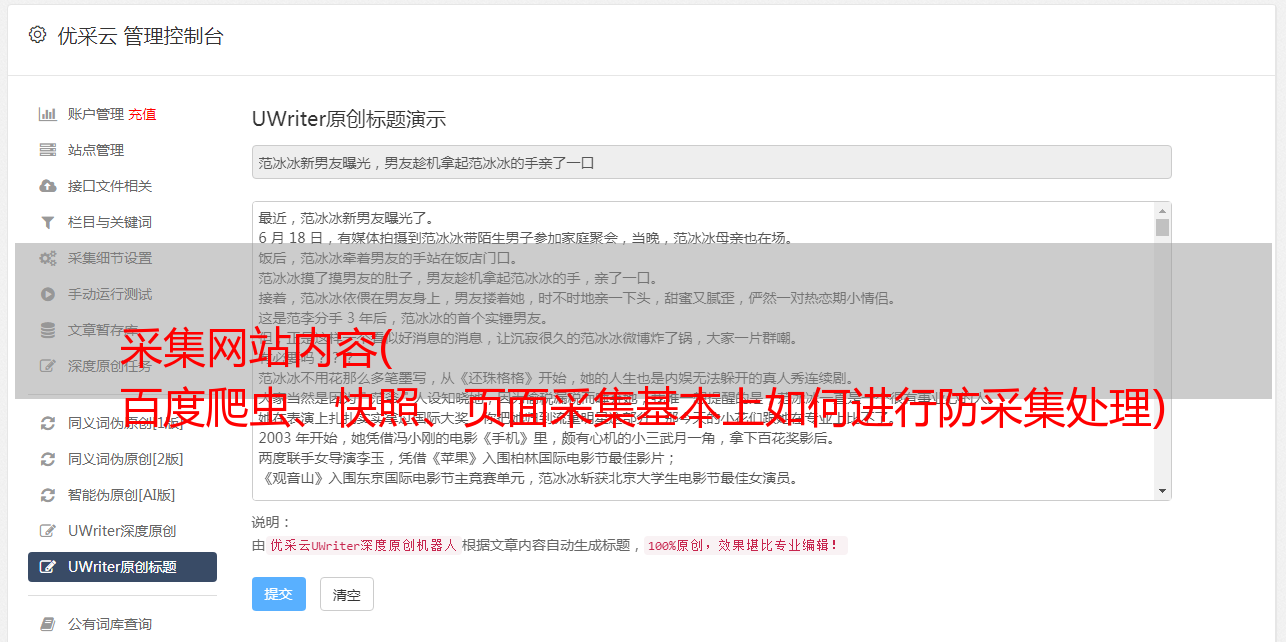

采集网站内容( 百度爬虫、快照、页面采集基本上如何进行防采集处理)

优采云 发布时间: 2022-02-03 10:25采集网站内容(

百度爬虫、快照、页面采集基本上如何进行防采集处理)

很多网站为了用户体验,通常会把自己想看的部分数据直接加载到页面上供用户查看。这时候采集用户只需要解析页面的html结构,然后采集就可以下载页面的所有信息了。百度爬虫、快照、页面采集基本都是用这个原理。

直接窃取网络数据库更高级。采集通常会写一个爬虫,让爬虫自动发现网站上的查询接口,模拟接口的数据标准,将对应的查询传递给接口命令,最后将返回的数据组织到完成相应的资源 采集。

手动采集字面意思是手动处理资源采集。此方法适用范围灵活,可手动下载和复制资源。采集。这种方法看起来非常低效且低效。但往往这种采集方法让人非常头疼。

PS:1位用户在A网站上下载了word profile,简单编辑后上传到自己的网站中使用。这个过程无法通过技术手段追踪(整个过程是用户的真实操作)。即使发现了这种现象,也不能确定对方盗取了自己的资源,因为你没有实际证据。这里可以想想百度文库的部分内容是怎么来的。

反采集方法策略

以上简单介绍了一些采集用户的采集方法。接下来我们来说说如何防范采集。

处理泄露下载链接的策略

通过这个过程,我们发现如果采集用户可以直接获取到第3步的下载链接,就可以直接下载资源而无需经过第2步的验证。 采集 方法,我们的重点是防止用户获取资源的下载链接。然后我们可以进行如下操作:

加密下载链接

程序员在开发过程中,基本都会对下载链接进行加密。加密就像一把钥匙。没有钥匙,锁无法打开。加密也是一样的。如果不知道解密方法,就无法破解下载链接,从而实现对资源采集的保护。

解密需要知道加密规则,所以在做加密处理的时候,最好不要使用第三方机器的加密规则,自己做最安全。加密规则的定期维护也是必要的。

防止采集人拦截下载链接

有的采集用户会截取第3步和第4步之间传输的下载链接,这样他就不用再经过第2步,也能拿到我们返回的下载链接下载。发生这种情况时,我们可以考虑在下载 url 中添加用户认证。浏览器在解析url时,会验证当前用户是否是我们的下载用户,以达到防止采集的目的。除非用户有权访问我们的帐户信息,否则他们无法采集访问我们的内容。但是这种方法不支持断点下载。