java爬虫抓取网页数据(一下NetDiscovery爬虫爬虫框架里的downloader对象对象1))

优采云 发布时间: 2022-02-01 08:12java爬虫抓取网页数据(一下NetDiscovery爬虫爬虫框架里的downloader对象对象1))

大家好,本文文章介绍NetDiscovery爬虫框架中的downloader对象

1) 前言

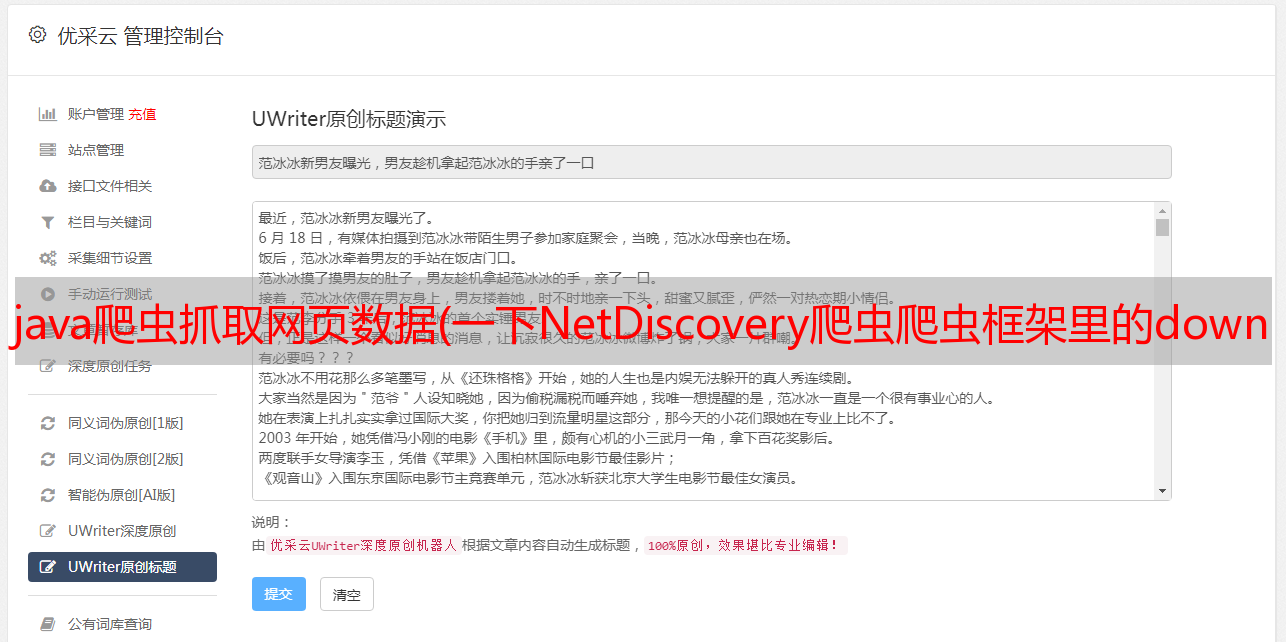

面向对象设计仍然是当前编程的核心思想。从下面的截图可以了解爬虫框架的主要对象:

程序在本地组织好一个请求后,交给下载器从网络抓取数据到本地,然后解析器对本地数据进行处理,最终生成可用信息。

2) 下载器介绍

下载器也称为下载器。它的主要功能是访问网络并成功获取我们想要的数据:如html网页、json/xml数据、二进制流(图片、办公文档等)

NetDiscovery 目前支持的下载器实现有:

面向接口的编程是该框架的重要设计思想之一。

下面介绍一些下载器代码。这些代码的共同点是实现Downloader接口。

作为程序开发人员,您还可以实现接口 discovery.core.downloader.Downloader 来创建自己的下载器类。

//1、构建一个URL对象

url = new URL(request.getUrl());

//2、获取一个HttpURLConnection对象

conn = url.openConnection();

//3、一堆设置

conn .setDoOutput(true);

conn .setDoInput(true);

conn .setRequestMethod("POST");

......

//4、访问网络服务

conn.connect();

//5、执行成功的话,获取结果

conn.getResponseCode();

conn.getInputStream();

//1、获取一个HttpManager对象(框架自己封装的)

HttpManager httpManager = HttpManager.get();

//2、然后把request扔进去,等结果就可以了.request也是框架封装的

httpManager.getResponse(request)

//3、等来结果后,进行处理

@Override

public Response apply(CloseableHttpResponse closeableHttpResponse) throws Exception {

String charset = null;

if (Preconditions.isNotBlank(request.getCharset())) {

charset = request.getCharset(); //针对一些还是GB2312编码的网页

} else {

charset = "UTF-8";

}

String html = EntityUtils.toString(closeableHttpResponse.getEntity(), charset);

Response response = new Response();

response.setContent(html.getBytes());

response.setStatusCode(closeableHttpResponse.getStatusLine().getStatusCode());

if (closeableHttpResponse.containsHeader("Content-Type")) {

response.setContentType(closeableHttpResponse.getFirstHeader("Content-Type").getValue());

}

return response;

}

3) 总结

总之,爬虫程序本质上是一个网络程序,而网络程序的核心模块离不开对网络数据的处理。建议学习爬虫的小伙伴,如果想看源码,可以从框架中的下载器相关代码入手。我相信会有收获。