网页中flash数据抓取(爬虫软件工程师教你怎么做SEO,没有什么比我们更了解 )

优采云 发布时间: 2022-01-23 13:07网页中flash数据抓取(爬虫软件工程师教你怎么做SEO,没有什么比我们更了解

)

爬虫软件工程师教你如何做SEO。没有什么比我们更了解搜索引擎了。我们都接触过数据聚合类型网站至少几千万的数据或者搜索引擎。URL就是人为设置一些URL供爬虫爬取。可以理解为爬取的入口URL,然后通过其内部链接传播爬取。

搜索引擎原则

在搜索引擎网站的后台,会有一个非常大的索引库,里面存储着大量的关键词,而每个关键词对应着很多的URL,这些URL被称为它是为“搜索引擎蜘蛛”或“网络爬虫”程序从浩瀚的互联网下载的点点滴滴采集而来。随着各种网站的出现,这些勤劳的“蜘蛛”每天都在网上爬行,从链接到链接,下载内容,分析提炼,找到关键词,如果“蜘蛛” " 认为 关键词 在数据库中不可用并且对用户有用,它将在后台存储在数据库中。相反,如果“蜘蛛”认为是垃圾邮件或重复信息,就会丢弃,继续爬取,查找最新和有用的信息并将其保存以供用户搜索。当用户搜索时,可以从索引库中检索到与该关键字相关的网站,并显示给访问者。一个关键词对应多个url,所以存在排序问题,对应的网站和关键词url会排在第一位。在“蜘蛛”爬取网页内容和提炼关键词的过程中,存在一个问题:“蜘蛛”能否理解。如果 网站 的内容是 Flash 和 JS 等,那么即使关键字合适,也是不可理解的。相应地,如果网站的内容能够被搜索引擎识别,搜索引擎会增加网站的权重,增加网站的友好度,进而提高<

百度收录难的原因?大量网站被黑并在明天发布的原因。

通过百度蜘蛛下载的网页放入补充数据区,经过各种程序计算后,放入检索区,形成稳定的排名。所以只要下载的东西可以通过说明找到,补充数据是不稳定的。是的,它可能会在各种计算过程中丢失。检索区的数据排名相对稳定。百度目前是缓存机制和补充数据的结合,正在向补充数据转变。

百度蜘蛛爬取策略

深度优先和权重优先,当百度蜘蛛从起始站点(即*敏*感*词*站点指一些门户站点)爬取一个页面时,百度先爬取更多的URL,深度优先爬取的目的是爬取到获得高质量的网页,这个策略是通过调度来计算和分配的。百度蜘蛛只负责爬取。权重优先是指对反向链接较多的页面优先抓取。这也是一种调度策略。40%的网页抓取是正常范围,60%是好的,100%是不可能的。当然,越爬越好。

不要打破搜索引擎的最大禁忌

百度蜘蛛似乎更注重 网站 页面的层次结构。与谷歌相比,百度蜘蛛更注重网站内部页面结构的层次结构,有点像爬虫。越黑越深,越喜欢往里挖。我不信你做100页。很漂亮,只要链接没有层次结构,你充其量只能成为收录可怜的小东西。

搜索引擎告诉你怎么做SEO?

不管是什么类型的网站站长,他们的网站结构一定要简洁明了,这是站长需要知道的事情之一。一般设计时网站的页面层级不要超过三层。现在,很多存储架的网站层级都超过了三层。页面文件名可以使用字母或数字,但不要使用长的中转英文插件,对收录没有任何好处。并且在建站过程中添加内容的时候,建议大家使用静态或者伪静态技术进行处理,有利于网站在搜索引擎中的友好性。

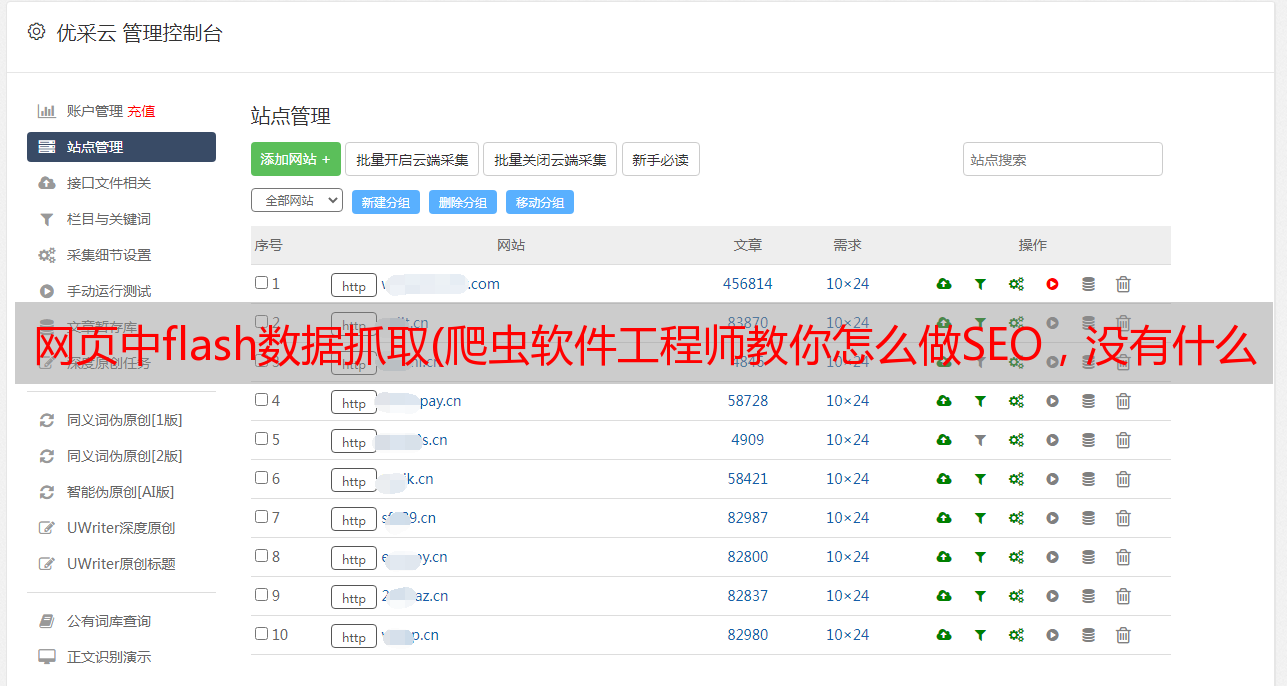

我刚刚用爬虫软件+技术处理创建了一个权重6 网站

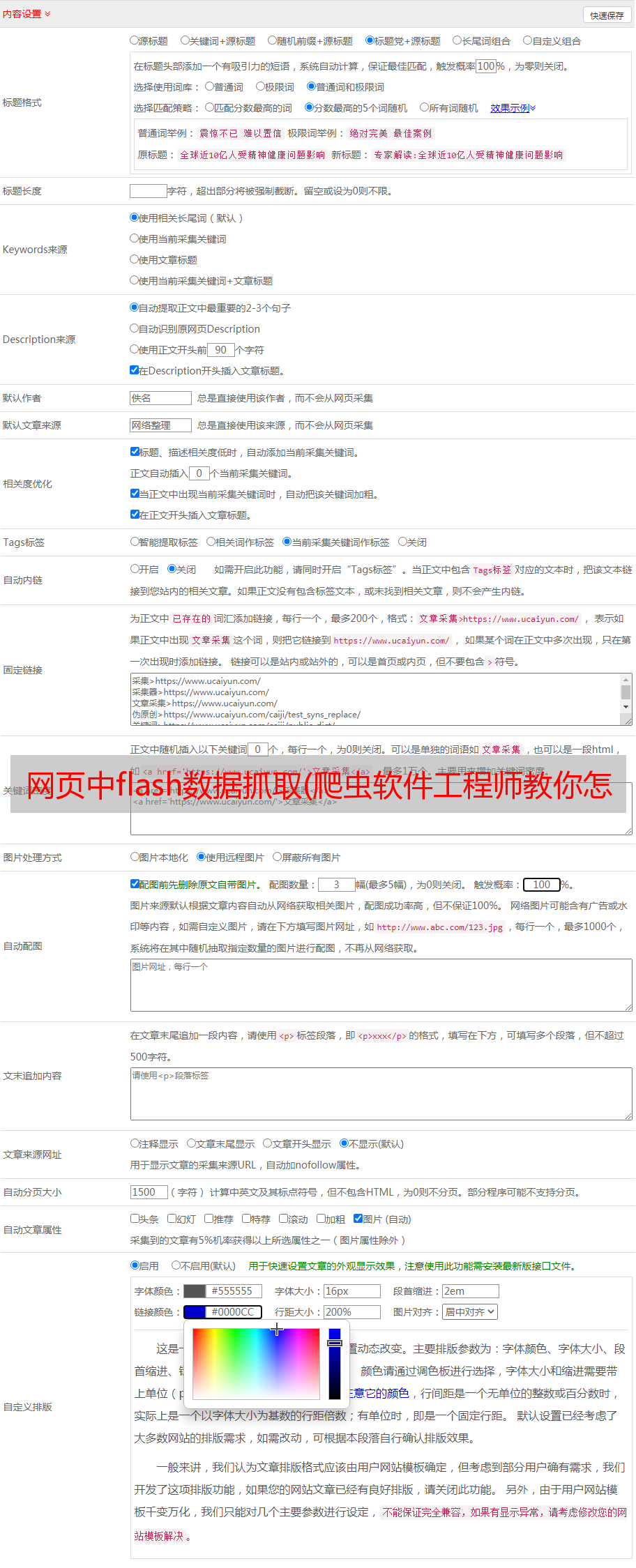

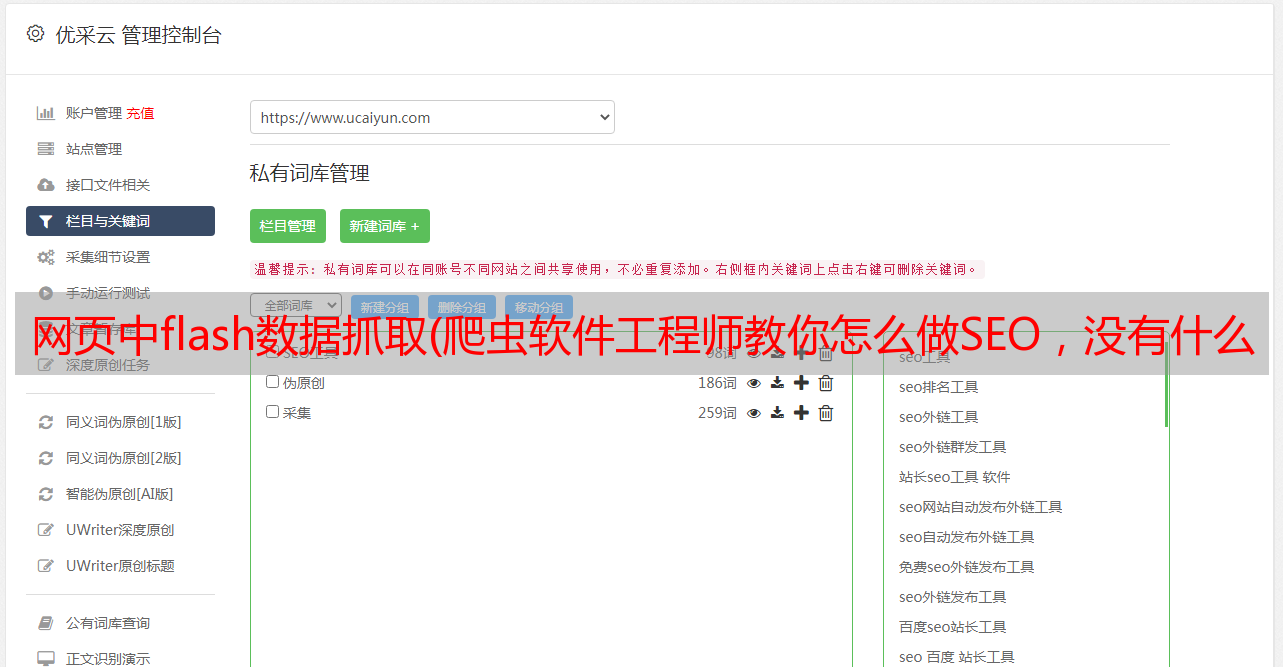

采集伪原创:TensorFlow人工智能引擎/分词算法/DNN算法采用多线程分段精准处理,结合机器学习、人工智能、百度大脑的自然语言分词、词性分析、词法依赖等相关技术,让所有搜索引擎都认为这是一个原创文章

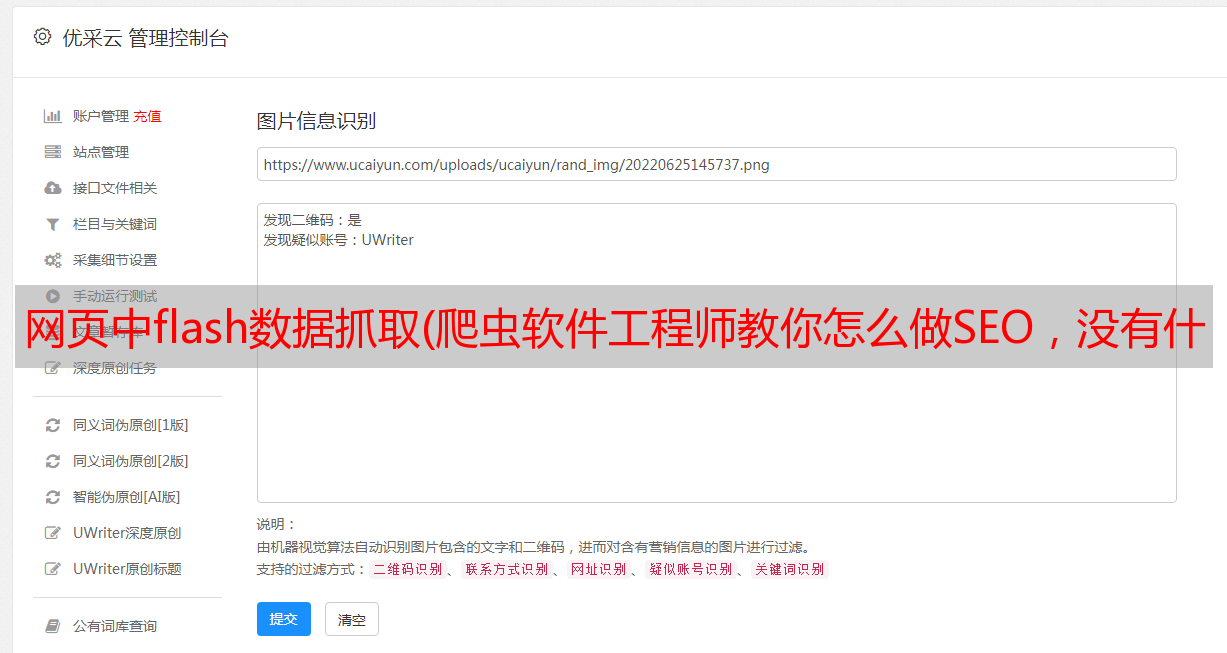

图片伪原创:背景融合算法,可以将1张图片伪原创转化为N张图片原创

模板伪原创:更改图片名,js名,css名,更改图片MD5、更改类样式名

网站发行商:Empire、易友、ZBLOG、织梦、WP、小旋风、站群、PB、Apple、搜外等。

看完这篇文章,如果觉得不错,不妨采集一下,或者发给有需要的朋友和同事!