抓取网页数据( 网页优游国际平台良多人以为Web该当一向开放的精力)

优采云 发布时间: 2022-01-18 19:21抓取网页数据(

网页优游国际平台良多人以为Web该当一向开放的精力)

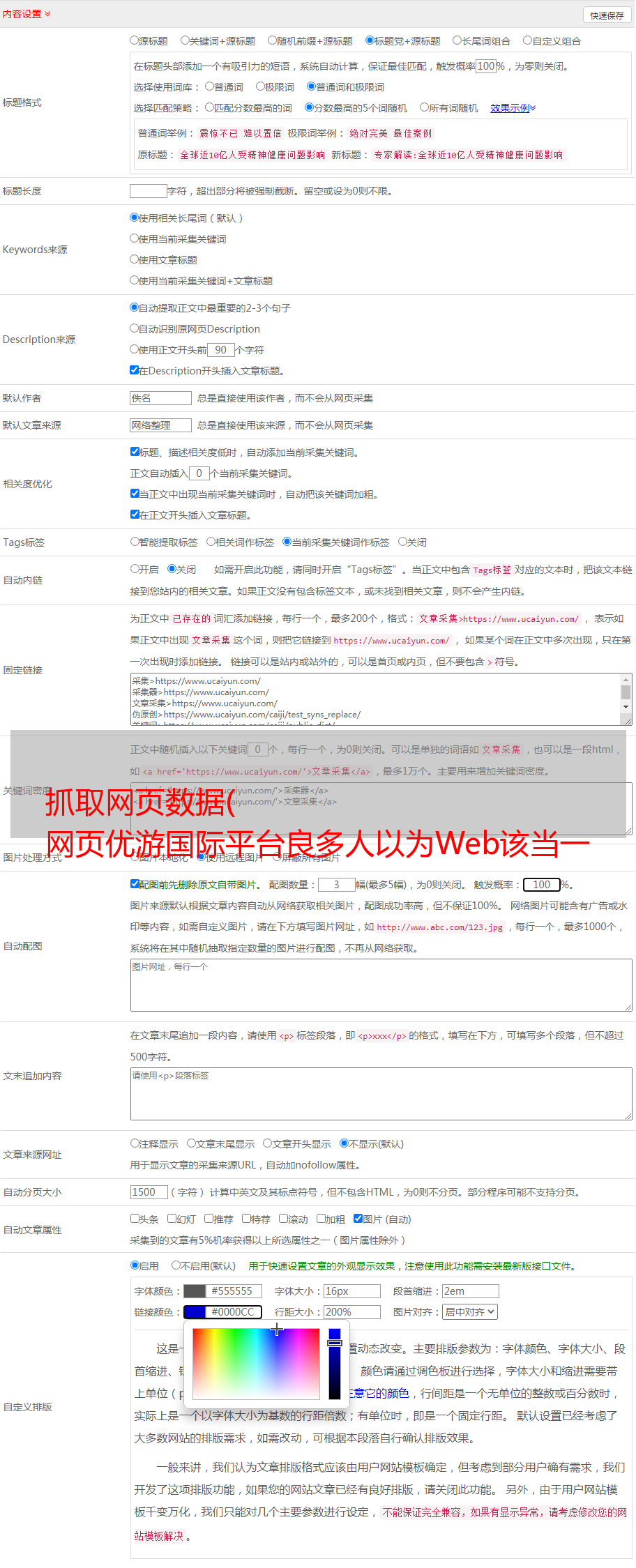

万维网是一个开放的平台,这也为万维网自1990年代初诞生至今的30年奠定了基础。然而,所谓的“优优国际平台”也可以被打败或更少,开放的功能,搜索引擎,以及简单易学的HTML和CSS移动优优国际平台,使Web优优国际平台成为最受欢迎的平台。熟悉互联网领域的信息传播。但是,作为商业软件,Web平台上的内容信息的版权并不能得到保证。与软件客户端相比,您网站的内容可以被移动用户以非常低的成本和低成本使用。国际平台的门槛是通过平台发布的一些爬取程序得到的,这就是本专栏的主题<

很多人认为,Web 应该始终遵循开放的精神,这表明该页面上的信息应该毫无保留地与所有 Internet 共享。但我认为,在 IT 行业走向明天,Web 不再是曾经与 PDF 竞争的所谓“超文本”信息载体,它是一种轻量级的客户端软件意识形态的存在。至于交易软件,Web 也将不得不面对知识产权保护的问题。试想,如果首发的优质内容得不到保护,抄袭盗版将横行全球。这对网络来说真的很糟糕。生态健全的平台不利,难以鼓励和鼓励更多优质原创内容的生产。

爬虫的非授权爬取是危害网络原创内容生态的一大难题。因此,为了保护网站的内容,首先要考虑如何防范爬虫。

从爬行动物的攻防来看

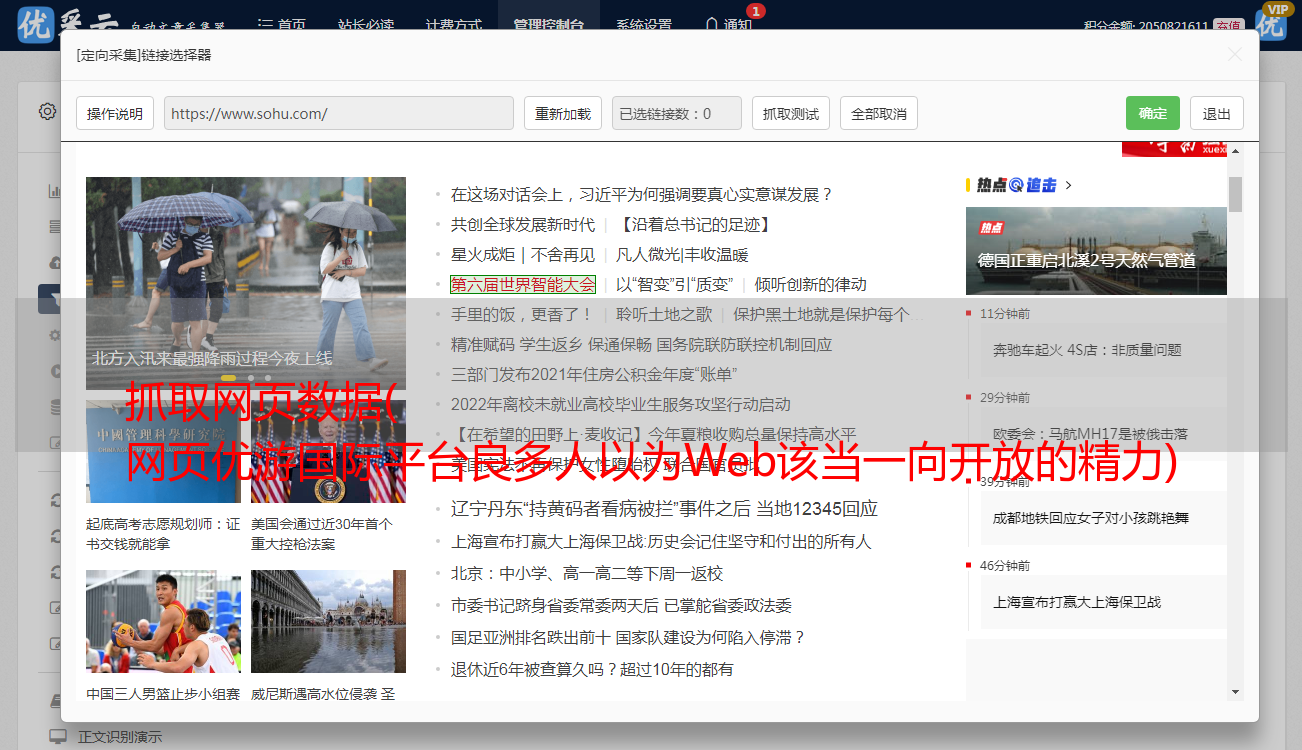

最简单的爬虫是几乎所有服务器和客户端编程语言都支持的http请求。你只需要向目标页面的url提交一个http get请求,浏览器加载页面时就可以得到完整的html。文档,这就是我们所说的“同步页面”。

作为防范,服务器可以根据对互联网平台的User-Agent的HTTP请求,检查客户端是合法的浏览器程序还是脚本编写的fetch程序,从而判断是否是真正的浏览器程序。页面信息的内容将发送给您。

这当然是最小平台的防御。作为防御,爬虫可以完全伪造User-Agent字段,甚至,只要你愿意,在HTTP get方法中,请求头的Referrer、Cookie等字段都是爬虫优优国际平台可以在你的指尖。

此时,服务器可以根据你声明的浏览器厂商和版本(来自User-Agent),使用浏览器的http头指纹来识别你http头的每个字段是否适合浏览器的特性。,如果不合适,将被视为爬虫。这个移动平台的一个典型操作是平台的 PhantomJS1.x 版本。由于它的底层使用了Qt框架的集合库,所以它是Qt在http头显眼的展示。框架网络需求的特征可以直接被服务器识别和阻断。

另外,另一种使平台失败的服务器端爬虫检测机制是在对所有访问的页面的http请求的http响应中植入一个cookie令牌,然后在该页面中的一些ajax接口中异步执行,需要检查访问请求中是否收录有游国际平台的cookie令牌。如果返回token,则说明这是一次合法的读者访问,否则刚刚获得token的用户访问页面html,但没有访问html中执行js后调用的ajax请求,游游国际平台可以是爬虫程序。

如果不关心token直接访问某个接口,也说明你没有请求html页面直接向页面中应该通过ajax访问的接口请求集合请求,这也清楚地证明了你是一个可疑的爬虫。. 著名的电子商务公司网站amazon 采用了这种防御策略。

以上是基于服务器端验证爬虫程序可以玩的一些套路。

基于客户端js运行时检测

现代浏览器是用JavaScript赋能的,所以我们可以把页面的所有主要内容,js异步地要求ajax获取数据,然后渲染到页面上,大大提高了爬虫的爬取能力。内容阈值。依靠这种方式,我们在js运行时将爬虫和反爬虫的竞争战场从服务端转移到了客户端浏览器。抓住移动优优国际平台。

刚才提到的各种服务器端验证,对于常见的python和java语言编写的http爬取程序,对于移动平台都有一定的门槛。它是一个黑盒子,很多东西都需要一点一点的去测试,花费大量的人力物力,为优优国际平台开发了一套爬取程序。作为防御者,网站只需要轻松调整一些策略,而攻击者则需要再次花费相同的时间来修改爬虫的爬取逻辑。

此时,您需要使用无头浏览器。这个手游国际平台是什么?说白了就是让程序用浏览器访问网页,这样写爬虫的人就可以用浏览器把API暴露给程序,完成平台复杂的爬取业务逻辑。

事实上,这在近几年并不是一个新兴的手游平台。过去的游戏平台是基于基于webkit内核的PhantomJS,基于火狐浏览器内核的SlimerJS,甚至基于IE内核的trifleJS。你可以检查一下。这里和这里是两个无头浏览器的集合列表。

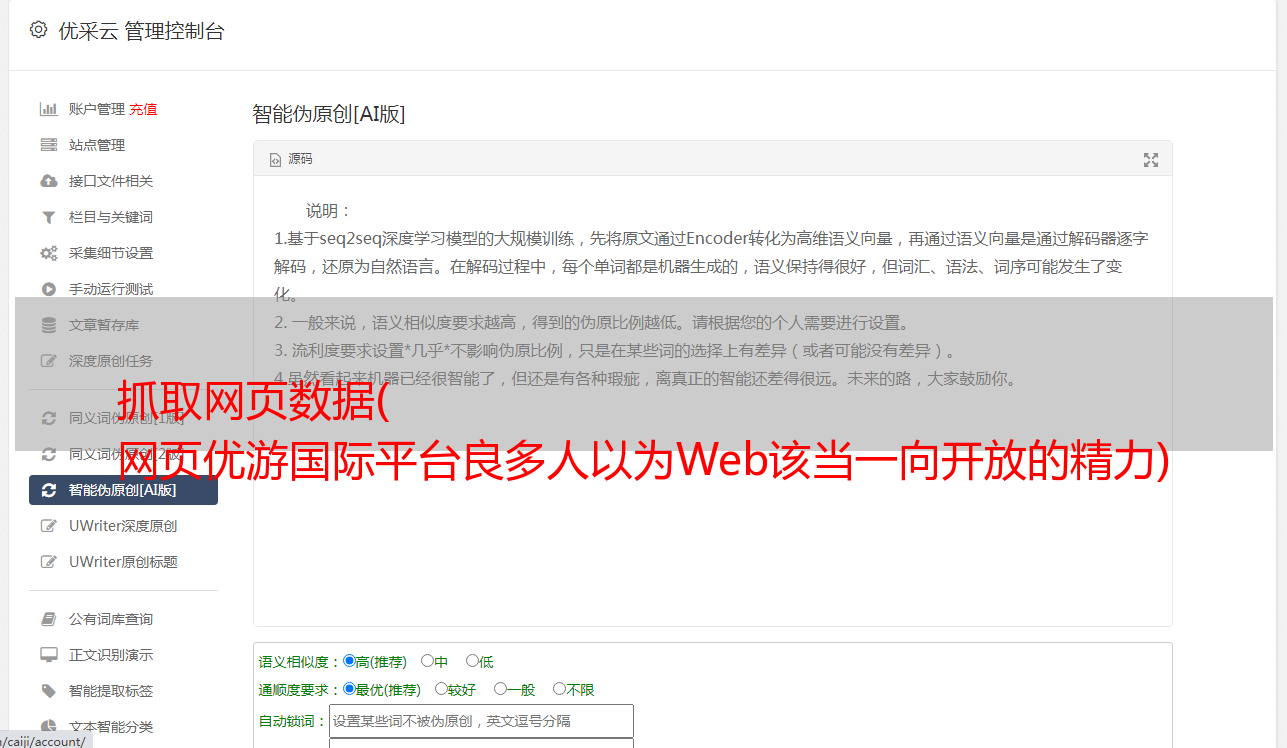

之所以出现这些无头浏览器程序,是为了创新和封印一些开源的浏览器核心C++代码,是一个简单易用的无GUI界面的浏览器程序。但是,这些项目的问题在于,由于它们的代码是基于fork官方webkit的某个版本的主干代码和其他外部核心,所以无法跟上一些最新的css属性和js语法,并且存在一些兼容性问题,不如真正发布的 GUI 阅读器。

这个 PhantonJS 平台是大家最熟悉的,也是操作率最高的。之前写过一篇关于这种爬虫识别的博客,这里不再赘述。PhantomJS 存在很多问题,因为它是单进程模型,不必要的沙盒保护,浏览器内核的安全性较差。

此刻,谷歌Chrome团队已经在chrome 59发布版上开放了headless mode api,并开源了一个基于Node.js误用的headless chromium dirver库。我还为这个库贡献了一个 centos 环境。设置列表。

Headless chrome 堪称无头浏览器平台的标新立异的杀手锏。因为它本身就是一个 chrome 浏览器,所以它支持各种新的 CSS 渲染特性和 js 运行时语法。

基于这样的手段,爬虫可以绕过几乎所有的服务器端验证逻辑作为防御端,但是这些爬虫在客户端的js运行时还是有一些技巧的,比如:

基于插件工具检查

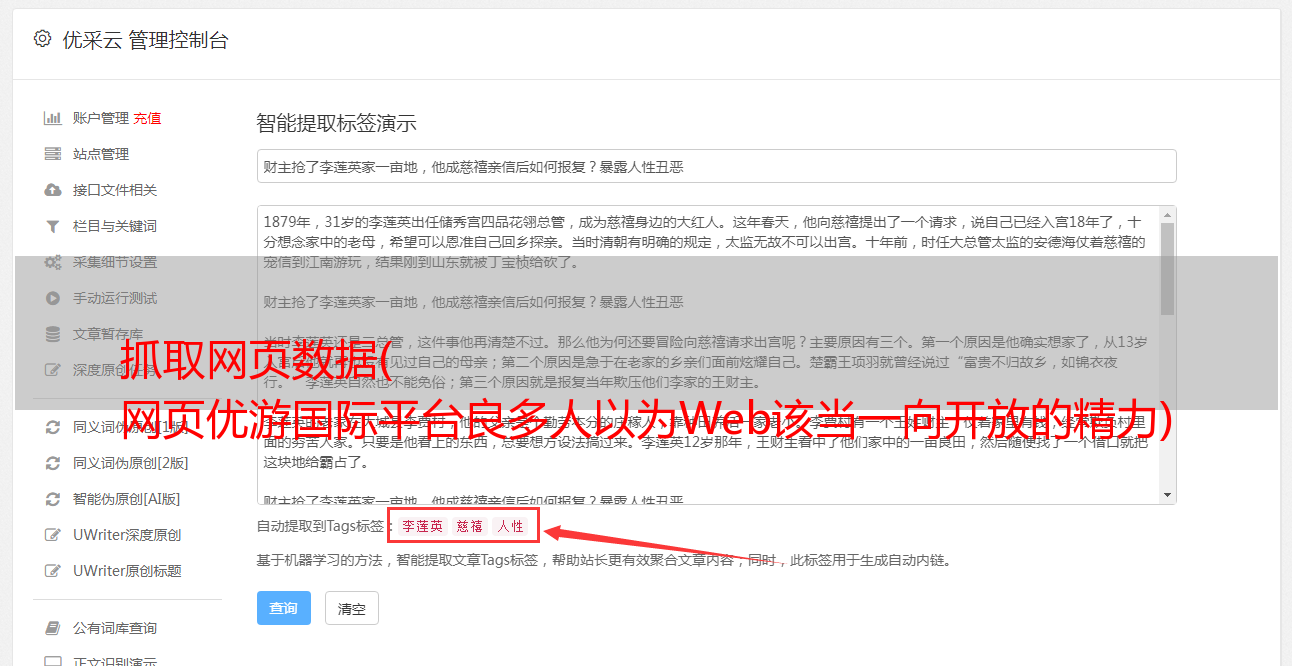

基于语言的搜索

基于 webgl 的检查

根据读者发际线的特点进行检查

检查基于错误img src属性生成的img工具

基于以上对一些浏览器特性的判断,基本可以秒杀市面上的无头浏览器程序。此时,其实就是为了提高网页爬虫的门槛,要求编写爬虫程序的开发者不得不修改浏览器内核的C++代码,从头开始编译一个浏览器。核心提升不小。

此外,我们还可以根据浏览器的UserAgent字段中描述的浏览器品牌、版本和型号信息,检查js运行时、DOM和BOM的各个native工具的属性和方法,看看它的特性是否适合这个版本. 读者应具备优优国际平台的特点。

这类方法称为阅读器指纹检查平台,依赖于大型网站采集各类阅读器的api信息。作为编写爬虫程序的防御方,你可以在无头浏览器运行的时候预先注入一些js逻辑,来制造浏览器的特性。

另外,我们在研究浏览器端使用js api检测robots浏览器的时候,发明了一个有趣的小技术,可以把预先注入的js函数变成native函数,我们看一下上面的代码:

爬虫防御者可能会预先注入一些js方法,在一些native api之上使用一层代理函数作为hook,然后用这个假js api覆盖native api。如果防御者根据检查函数 toString 之后的 [native code] 来检查这一点,它将被绕过。所以需要更严格的检查,因为bind(null)的方法是捏造的,toString后面没有函数名。

对付爬行动物的灵丹妙药

目前,最可靠的手腕防抢和机器人检查仍然是验证码移动平台。但是,验证码并不意味着必须强制用户输出一串连续的字母和数字。有很多基于用户鼠标、触摸屏(移动端)等动作的移动验证平台。这是最好的移动平台。国际平台熟悉度确实是 Google reCAPTCHA。

基于以上对用户和爬虫的识别,网站的防御者需要做的是封锁该IP位置或对该IP的访问用户施加高强度验证码策略。这样防御者就得购买一个ip代理池来捕获网站信息内容,否则单个ip位置很容易被屏蔽,无法捕获。爬取和反爬的门槛已经提升到ip代理池的经济成本水平。

机器人谈话

此外,在履带式移动机器人领域还有一条“白道”,叫做机器人和平。可以访问网站根目录下的/robots.txt,比如我们看一下github的robots chat,Allow和Disallow分别声明了爬取各个UA爬虫的权限。

然而,这只是一个诚实的谈判。虽然它有法律上的好处,但它只能确定那些商业搜索引擎的蜘蛛,你不能对那些“野爬虫”施加限制。.

写在开头

网页内容的爬取与反制一定是魔高一尺,路高十尺的猫捉老鼠游戏。你永远不可能用某个手游平台完全挡住爬虫式的路。你能做什么 只是增加了攻击者的捕获成本,对未经授权的捕获有了更准确的理解。

这次文章游游国际平台提到的验证码攻防对于手游国际平台来说也是一个比较复杂的难点。我会在这里留下一个关注,我可以多关注它,等待后续文章停止。具体讨论。

另外,对爬虫感兴趣的可以关注我的一个开源项目webster,它以Node.js和Chrome headless的形式完成了一个高可用的网络爬虫框架。页面的渲染能力可以捕捉到一个页面上js和ajax渲染的所有异步内容;redis完成一个任务线,让爬虫程序可以轻松实现横向和纵向分布式扩展。