抓取网页新闻(不就是几十次几十次的超时吗?什么问题呢?(图))

优采云 发布时间: 2022-01-18 10:22抓取网页新闻(不就是几十次几十次的超时吗?什么问题呢?(图))

在这些年的SEO诊断中,我发现不少于20%的网站都有严重的爬取问题,但奇怪的是,从来没有被大多数人关注过。而对这个问题进行深入研究和分享的人都没有发现。今天的文章文章,我们来看看这个问题。

有什么问题?

连接超时,或提取超时。如果您的网站遇到过这个问题,没有处理到位,请转载此文章。

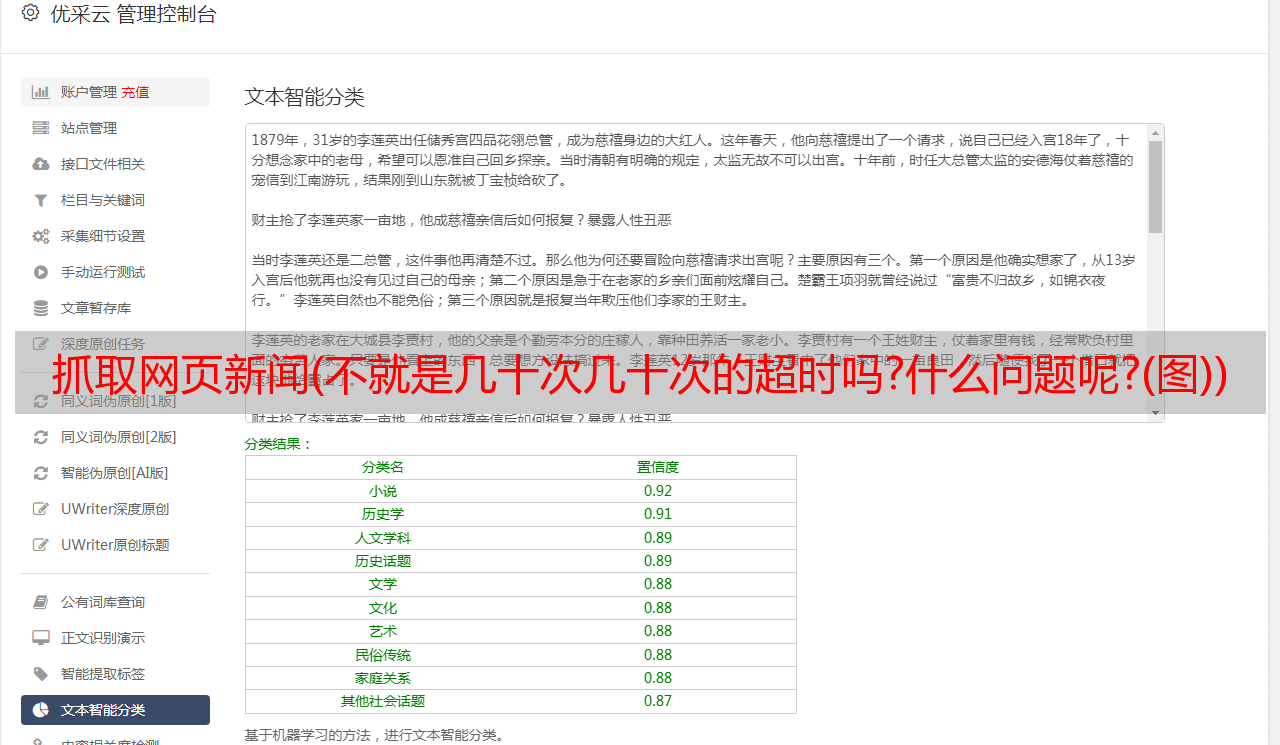

很多人说,不就是几十个超时吗?有什么大不了的?如果你这么认为,那真的值得网站做得不好。一个普通的 网站 是什么样子的?举个例子:

这是一个权重为4的网站,即使爬取了10万次以上,依然没有出现爬取错误!如果你每天爬取错误超过10次(十天半月出现一次错误),或者连续出现很多天),你真的应该认真对待这个问题,因为当前问题的存在早已被限制网站 的发展极限,甚至因为这个问题,导致了 网站 的降级,一点也不奇怪。

为什么会出错?

有人说,别打扰,这是个bug,因为我在网站的LOG日志中没有发现这个问题。百度站长VIP群里,有人解释过。但是我想说的是:百度无法获取网站,你的网站LOG日志里能算出这样的错误吗?因此,上述解释是完全不合理的。

那么,为什么会出现这个错误呢?

A、DNS问题,不管是蜘蛛还是用户访问网站,首先需要正确解析域名的DNS,但是解析解决了,能否确定DNS是真的稳定吗?有很多网站错误,这是因为DNS不稳定。尤其是那些做域名注册,搞“域名抢注”的平台。此类平台更容易出现不稳定的 DNS 解析,尤其是在抢注高峰期。具体品牌将不具名。如果您的域名在这些平台上,何贵江强烈建议您转出。

B. 页面太大。网站 的某些页面已经达到了 45,678,000 兆字节,甚至很少有 网站 见过大小为 10MB 的页面。这样的页面更容易出现链接超时。一般情况下,网站的页面大小不建议超过3MB,建议网站服务器开启GZIP压缩。

C. 带宽不足。这是很常见的情况。许多站点的链接超时是由带宽不足引起的。我们知道1M的峰值下载带宽是128KB。如果 网站 为 1M 访问,则页面大小为 256KB。如果两个人同时打开页面,则需要 4 秒才能完成下载。如果带宽是2MB,页面大小是1024KB,1个人打开网站需要8秒,但是如果10个人同时打开呢?所以这里的带宽必须足够。站长或企业应观察站点的平均带宽和峰值带宽。如果存在频繁的“带宽峰值”类型的访问,则必须升级带宽。

D、第一个字节时间,很多同学可能没有听说过这个问题,它是指从向WEB服务器发送请求的时间+WEB服务器处理请求并生成响应的时间。在一些站点,首字节时间可以达到5MS。这种情况下,网站还正常吗?

1、这里的第一个字节时间要注意:避免网站和其他网站共享同一个服务器网站其他网站会占用自己的网站服务器处理时间。

2、CDN 缩短了内容和访问者之间的“距离” 将静态内容分发到 CDN,CDN 的内容会自动跨位置复制,地理上更接近用户,从而减少 TTFB 时间。请注意,必须为 网站 慢速访问页面或部分设置“缓存时间”。

3、避免网站使用虚拟主机系统。如果网站一段时间没有产生流量,系统会延迟或挂起虚拟服务器。当有新访客进入时,将再次执行服务器备份过程(10s或更长);

4、后端优化软件性能减少从服务器生成响应到浏览器的时间,如:操作码缓存、服务器端缓存、本地缓存、W3总缓存等。

最后,总结一下:

首先是为网站寻找可靠的DNS服务提供商。我们推荐阿里云,其次是稳定的CDN服务商,如阿里巴巴、百度智能云、腾讯云。最后是网站服务器,尽量不要使用虚拟主机,尽量避免多个站点使用同一台服务器。