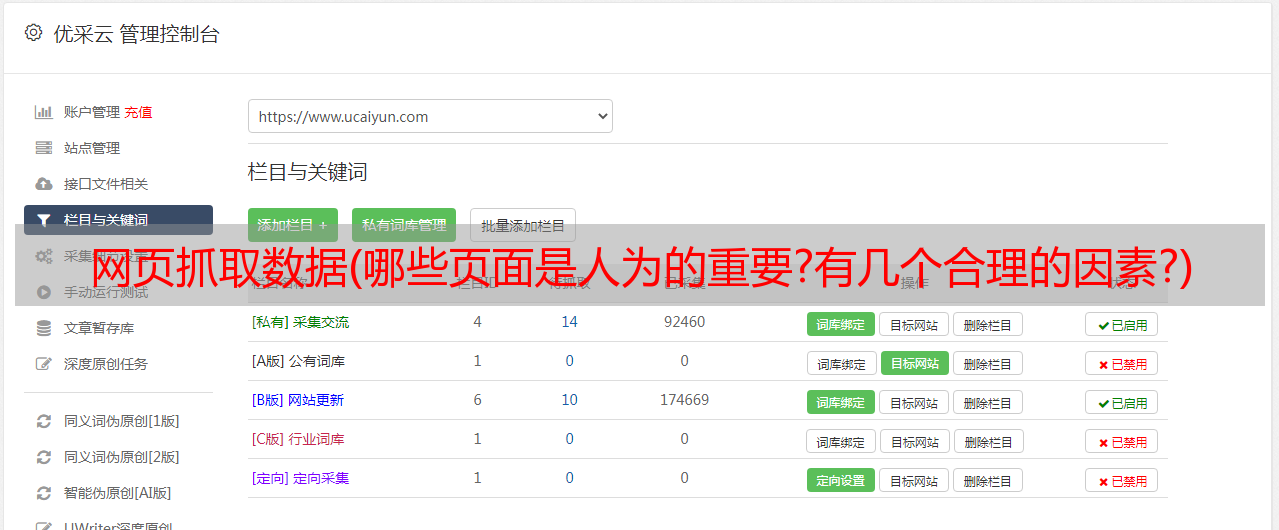

网页抓取数据(哪些页面是人为的重要?有几个合理的因素?)

优采云 发布时间: 2022-01-16 01:08网页抓取数据(哪些页面是人为的重要?有几个合理的因素?)

最常用的链接是锚文本链接、超链接、纯文本链接和图像链接。如何被爬虫爬取是一个自动提取网页的程序,比如百度蜘蛛。要让你的 网站 收录更多的页面,你必须先让爬虫爬取页面。如果你的 网站 页面定期更新,爬虫会更频繁地访问该页面,而优质的内容是爬虫喜欢抓取的内容,尤其是原创内容。蜘蛛很快就会爬上 网站、网站 和页面权重,这肯定更重要。

做SEO优化,我希望我的更多页面是收录,尽量吸引蜘蛛去抓取。如果你不能爬取所有的页面,蜘蛛所要做的就是爬取尽可能多的重要页面。哪些页面是人为重要的?

有几个合理的因素

1、网站页数和权重

网站质量高,资质老,被认为权重高,在这个网站上爬取页面的深度会更高,所以收录的页面会多一些。

2、页面更新

蜘蛛每次抓取时都会存储页面数据。如果不需要掌握第一个页面更新,则不需要第二个蜘蛛页面更新。如果页面内容更新频繁,蜘蛛会更频繁地访问该页面,页面上的新连接自然会被蜘蛛更快地跟踪以抓取新页面。

3、导入链接

无论是外链还是同一个网站的内链,都必须被蜘蛛爬取,并且必须有传入链接才能进入页面,否则蜘蛛将没有机会知道存在的页面。高质量的传入链接通常会增加页面上传出链接的抓取深度。

4、点击“离家距离”

一般来说,大多数主页的权重都很高。因此,点击距离越接近首页,页面的权限越高,被蜘蛛爬取的机会就越大。

5、网址结构

页面权重只有在迭代计算中才知道,所以上面提到的高页面权重有利于爬取。搜索引擎蜘蛛在爬取之前如何知道页面权重?因此,蜘蛛预测,除了链接、与首页的距离、历史数据等因素外,短 URL 和浅 URL 也可能会直观地认为该站点具有较高的权重。

6、如何吸引蜘蛛:

这些链接导致蜘蛛访问网页。只要不遵循这些链接,就会导致蜘蛛访问和转移权重。锚文本链接是一种很好的引导蜘蛛的方式,有利于关键词排名,比如关键词锚文本中的附属链接。