自动抓取网页数据( 这是简易数据分析系列的第4篇文章(图)实操)

优采云 发布时间: 2022-01-08 08:03自动抓取网页数据(

这是简易数据分析系列的第4篇文章(图)实操)

这是简易数据分析系列文章 的第四部分。

原文首发于博客园:简单数据分析04。

今天我们开始数据抓取的第一课,完成我们的第一个爬虫。因为只是开始,所以我会很详细的讲解操作,可能会有点啰嗦。我希望你不要不喜欢它:)

有些人之前可能学过一些爬虫知识,但是总觉得这是个复杂的东西,比如HTTP、HTML、IP池,这里就不考虑这些东西了。一是少量的数据根本不需要考虑,二是这些乱七八糟的东西根本不提爬虫的本质。

爬行动物的本质是什么?其实就是找规律。

而且,爬行动物找规律的难点,多半是小学三年级数学题的水平。

举个例子来说明,下图历史文章的截图,我们可以清楚的看到每条推文都可以分为标题、图片和作者三部分,我们只需要找到这个规律,您可以批量捕获此类数据。

好了,理论讲完了,我们开始实操吧。

只要练习爬取,第一个爬取的网站通常是豆瓣电影TOP 250,URL链接是/top250?start=0&filter=。第一次爬取的内容尽量简单,所以只爬取首页的电影片名。

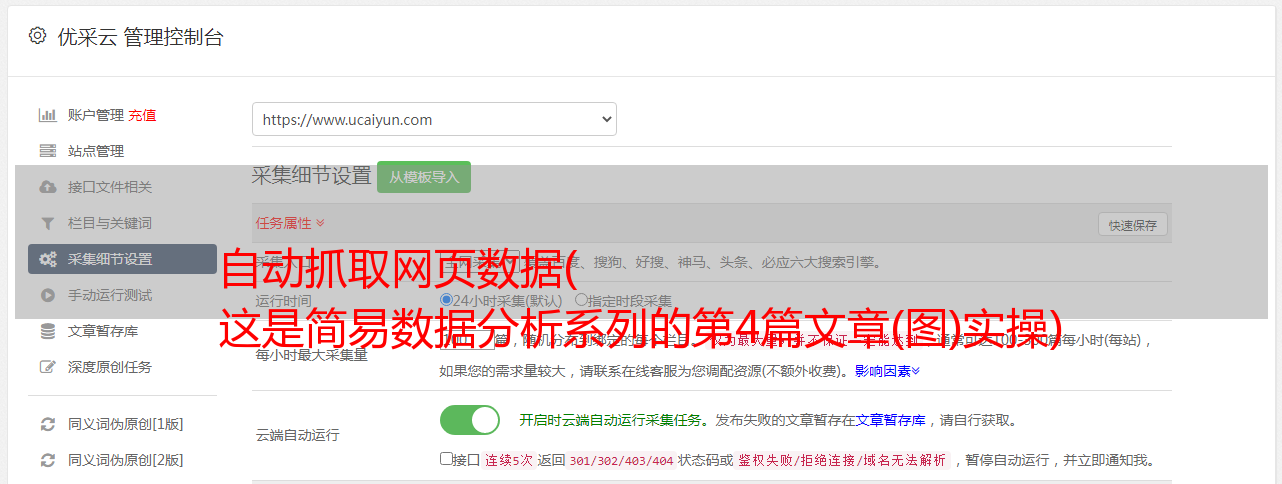

浏览器按F12打开控制台,把控制台放在网页底部(详情见上篇文章),然后找到Web Scraper Tab,点击,就到了Web Scraper 控制页面。

进入Web Scraper的控制页面后,我们按照Create new sitemap -> Create Sitemap的操作路径新建一个爬虫。站点地图的含义并不重要,您只需将其视为爬虫的别名。

我们在接下来出现的输入框中依次输入爬虫名称和要爬取的链接。

爬虫名称可能有字符类型限制,我们只看规则规避,最后点击 Create Sitemap 按钮创建我们的第一个爬虫。

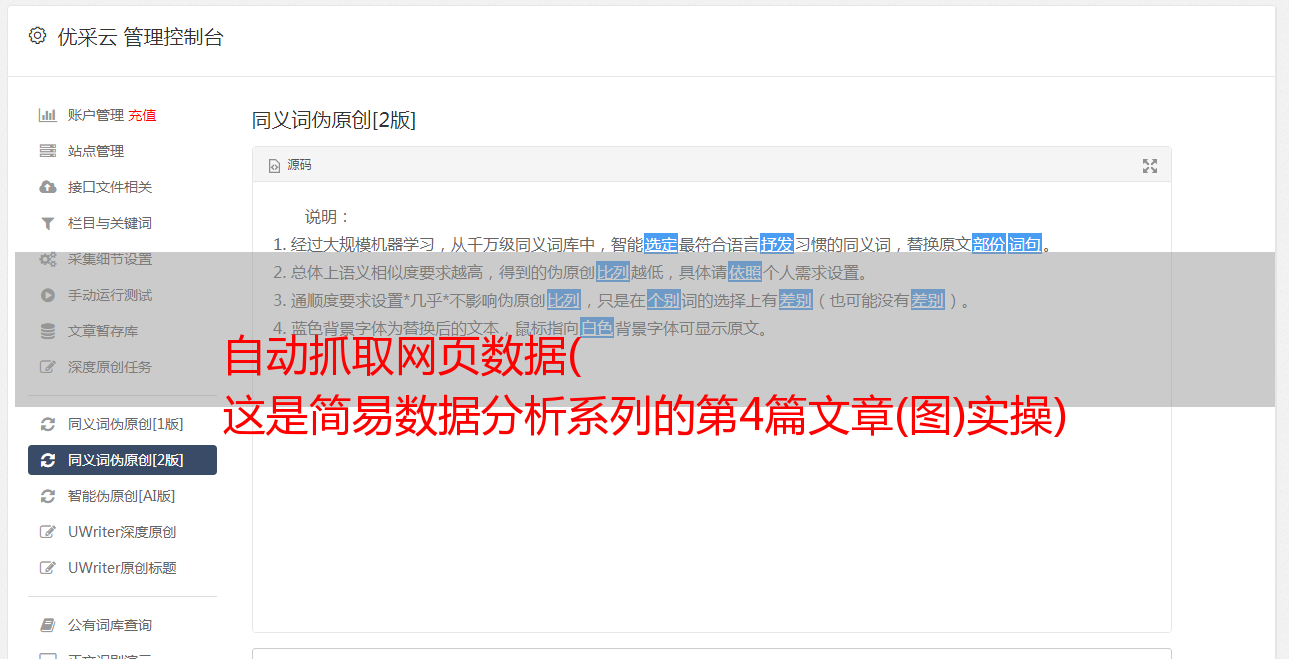

这时候会跳转到一个新的操作面板,别的不用管,我们直接点击蓝底白字的添加新选择器按钮,顾名思义,创建一个选择器来选择我们的元素想抢。

是时候开始正式的数据采集会话了!我们先来看看这个面板有什么:

1.首先有一个Id,这个是给我们要爬取的内容标记一个id,因为我们要爬取电影的名字,为了简单起个名字就行了;

2.电影的名字显然是一段文字,所以Type类型必须是Text。在这个爬虫工具中,默认的Type类型是Text,这个爬取工作不需要改变;

3.我们勾选了多选按钮Multiple,因为我们要抓取的是批量数据,不勾选就只能抓取一个;

4.最后,我们点击黄圈中的选择,开始在网页上查看电影名称;

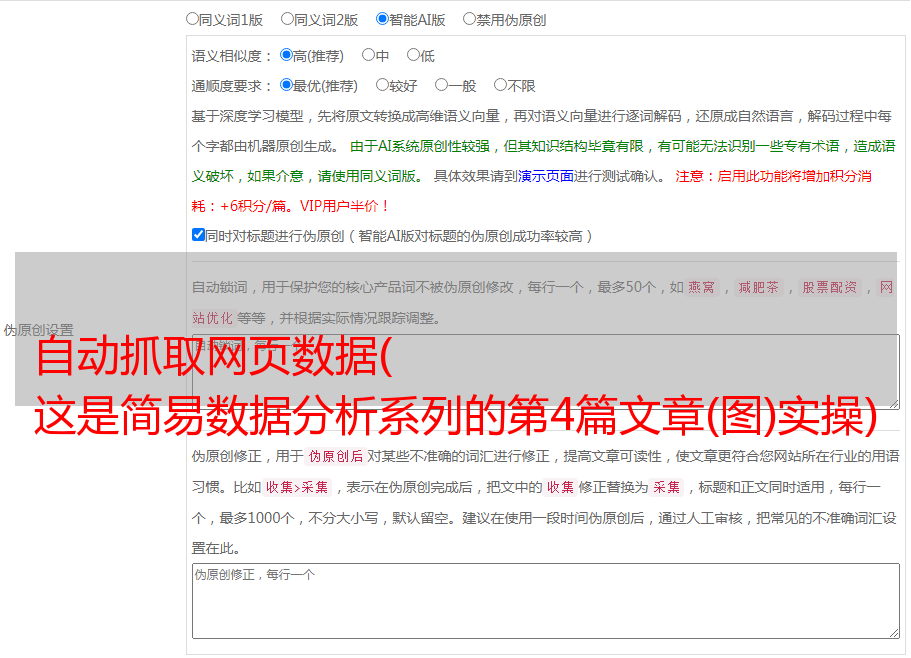

当您将鼠标移动到网页上时,您会发现网页上出现绿色方块。这些方块是网页的组成元素。当我们点击鼠标时,绿色方块会变成红色,表示该元素被选中。:

至此,我们就可以进行爬取工作了。

我们先选择《肖申克的救赎》的标题,再选择《霸王别姬》的标题(注:要达到多选的效果,必须手动选择两个以上的内容)

选择这两个片名后,向下滚动页面,你会发现所有电影片名都被选中:

拉网页再次查看,发现所有电影片名都被选中了,我们可以点击完成选择!按钮,表示选择完成;

点击按钮后,你会发现下图红框中会出现一些字符。一般如果出现这个,就说明选择成功了:

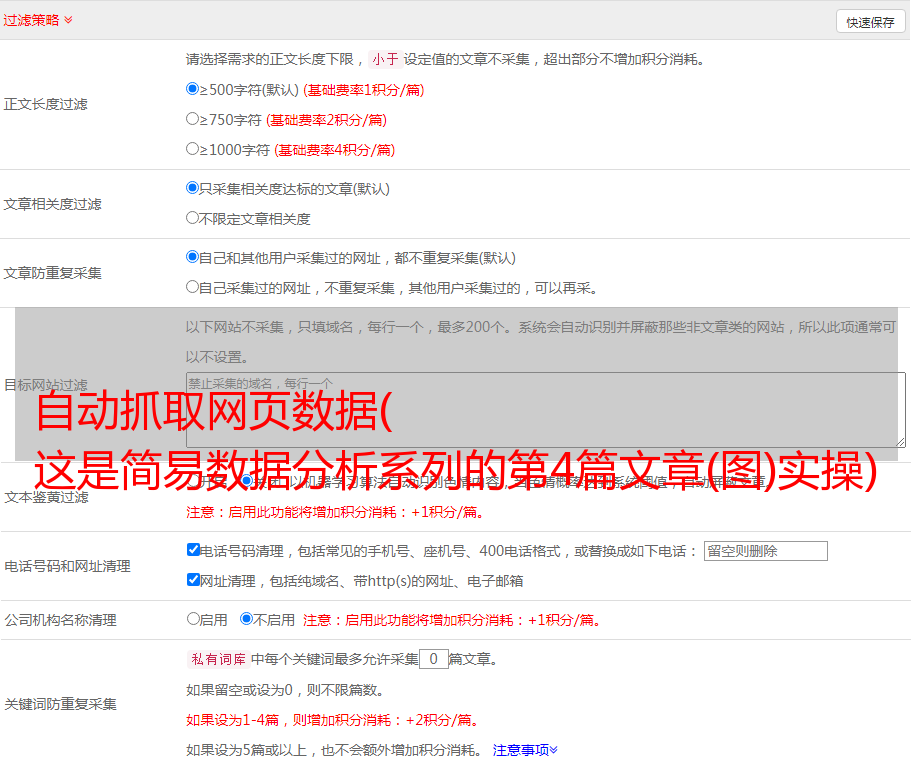

我们点击数据预览按钮来预览我们的抓取效果:

如果没有问题,关闭数据预览弹窗,转到面板底部,有一个蓝色的保存选择器按钮,点击后,我们会回到上一个面板。

这时候你会发现多了一行数据,其实就是我们刚才记录的操作的内容。

在顶部的标签栏中,有一个Sitemap top250 标签,就是我们刚刚创建的爬虫。点击它,然后点击下拉菜单中的 Scrape 按钮,开始我们的数据抓取。

这时候会跳转到另一个面板,有两个输入框,不管是什么,一共输入2000就行了。

点击开始抓取蓝色按钮后,会弹出一个新的网页,Web Scraper插件会在这里抓取数据:

一般情况下,弹出网页的自动关闭意味着数据采集结束。我们点击面板上的刷新蓝色按钮,就可以看到我们抓到的数据了!

在这个预览面板中,第一列是网络爬虫自动添加的数字,没有意义;第二列是爬取的链接,第三列是我们爬取的数据。

这个数据会保存在我们的浏览器中,我们也可以在Sitemap top250下点击Export data as CSV,这样我们就可以导出.csv格式的数据了,这个格式可以用Excel打开,我们可以用Excel做一些数据格式化*敏*感*词*。

今天我们爬取了豆瓣电影TOP250的首页数据(也就是排名前25的电影),下一篇我们会讲如何抓取所有电影名。