网页抓取数据百度百科(从千亿页面上提取数据该如何做呢?(图))

优采云 发布时间: 2022-01-04 06:05网页抓取数据百度百科(从千亿页面上提取数据该如何做呢?(图))

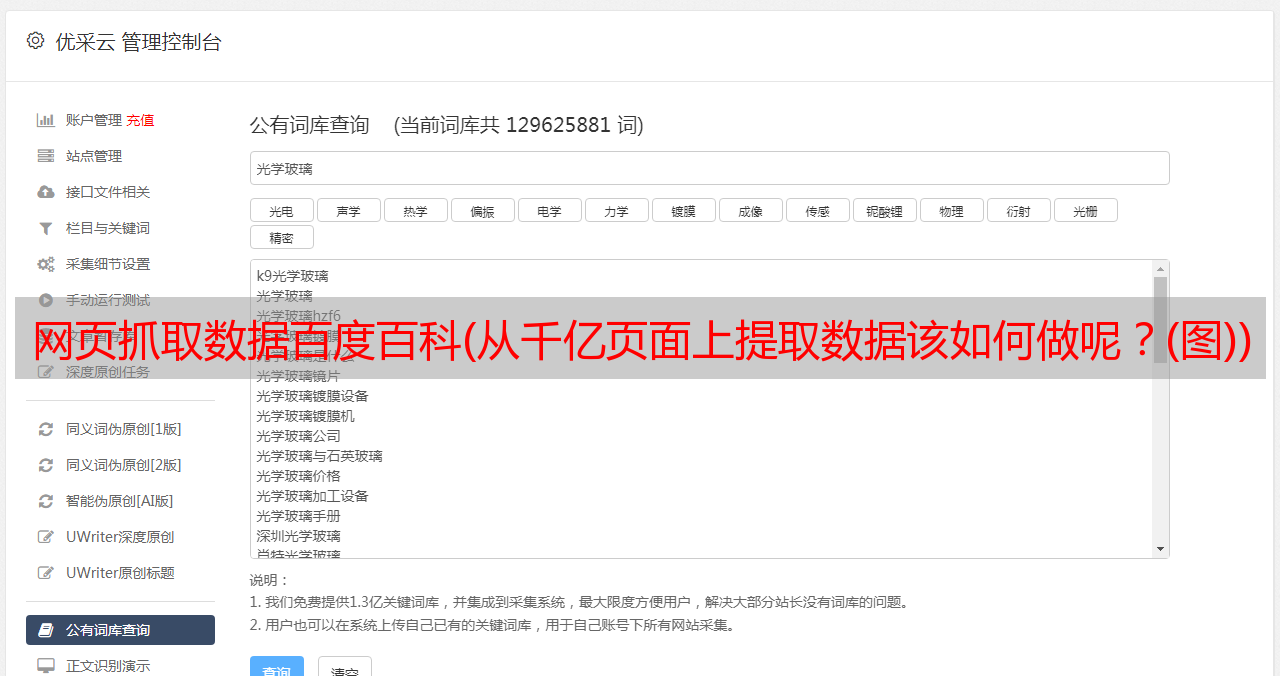

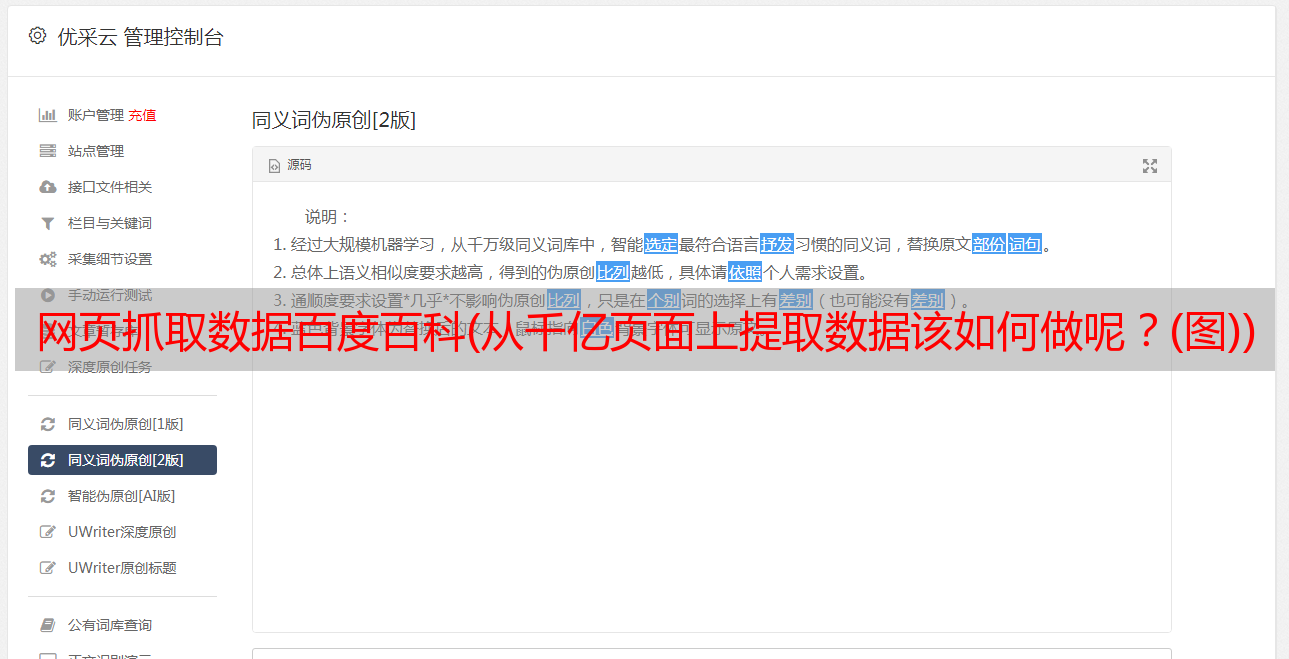

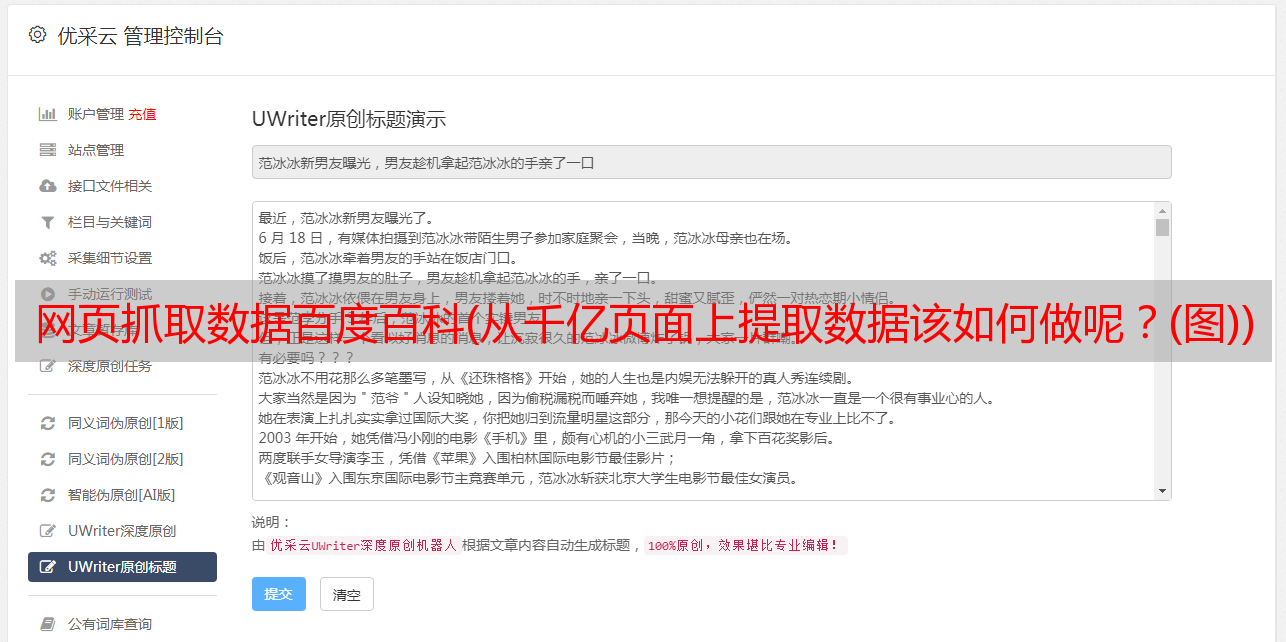

众所周知,要想更好地完成数据分析,除了掌握好方法和方法,还需要做好数据提取。那么如何从千亿页面中提取数据呢?

千亿页数据提取经验总结-让我们开始方块

现在从互联网上获取数据似乎很容易。有很多开源的库和框架,可视化爬虫工具和数据提取工具,可以很方便的从一个网站中抓取数据。然而,当你想*敏*感*词*搜索网站时,很快就变得非常棘手。

*敏*感*词*网络爬虫的要点:

不同于标准的网络爬虫应用,电子商务产品数据的*敏*感*词*爬取将面临一系列独特的挑战,这使得网络爬行变得异常困难。

本质上,这些困难可以归结为两个方面:速度和数据质量。

通常时间是一个限制性的约束,所以*敏*感*词*的抓取需要网络爬虫以非常高的速度抓取页面,并且不会影响数据质量。这种对速度的要求使得捕获大量产品数据变得非常具有挑战性。

挑战 1:乱七八糟的网页格式。凌乱多变的网页格式可能是最常见的挑战,也可能不是最有趣的挑战,但却是迄今为止*敏*感*词*数据提取面临的最大挑战。这一挑战的关键不是复杂性,而是需要大量的时间和资源来应对。

千亿页数据提取经验总结-让我们开始方块

挑战 2:可扩展的架构。您将面临的下一个挑战是构建一个爬虫基础设施,该基础设施可以随着每天请求数量的增加而扩展,而不会降低性能。

在*敏*感*词*提取产品数据时,简单的网络爬虫只能连续爬取数据,不能提取。通常,一次连续的网络爬虫会一个接一个地循环发送请求,每个请求需要 2-3 秒才能完成。

如果爬虫每天请求少于40000个请求(每2秒发送一个请求,这意味着每天可以发送43200个请求),这种方法是可以的。但是,一旦请求数量超过这个数量,就需要切换到每天可以发送数百万个请求而不降低性能的爬虫架构。

如上所述,速度是*敏*感*词*抓取产品数据的关键。您需要确保在特定时间段内(通常为一天)找到并抓取所有需要的产品页面。为此,您需要执行以下操作:

将产品搜索与产品提取分开。为了*敏*感*词*提取商品数据,您需要将商品搜索爬虫与商品提取爬虫分开。

为产品提取分配更多资源。由于每个产品类别“货架”可以收录 10 到 100 个产品,并且与提取产品 URL 相比,提取产品数据需要更多资源,因此搜索爬虫通常比产品提取爬虫更快。

千亿页数据提取经验总结-让我们开始方块

挑战 3:保持吞吐量性能。在提取大量数据时,我们必须在现有硬件资源的基础上,尽可能地找到一种可以最小化循环时间并最大化爬虫性能的方法。所有这些都必须减少每个请求的时间,甚至几毫秒。

为此,您的团队需要深入了解网络抓取框架、代理管理和正在使用的硬件,以便更好地调整它们以获得最佳性能。

在*敏*感*词*抓取时,我们应该始终努力以最少的请求次数提取出我们需要的确切数据。任何额外的请求或数据提取都会降低抓取速度网站。

在设计爬虫时,请记住以下几点:

1、 用无头的浏览器,比如Splash或者Puppeteer,把JavaScript渲染放在最后。抓取网页时,使用无头浏览器渲染JavaScript会非常占用资源,严重影响抓取速度;

2、如果不需要向每个产品页面发送请求,但也可以从货架页面获取数据(如产品名称、价格、口碑等),不要请求产品页面;

3、除非必要,否则不要请求或检索图像。

挑战 4:反机器人策略。在*敏*感*词*爬取电商网站时,你肯定会遇到使用反机器人策略的网站。

对于大多数小型网站来说,他们的反僵尸策略是非常基础的(IP禁止过度请求)。但是对于像亚马逊网站这样的大型电商,他们会使用非常成熟的反机器人策略,比如Distil Networks、Incapsula或者Akamai,这会让数据提取变得更加困难。

挑战 5:数据质量。从数据科学家的角度来看,网络抓取项目最重要的考虑因素是提取数据的质量。*敏*感*词*爬取更注重数据质量。

如果您每天需要提取数百万个数据点,则无法手动验证所有数据是否干净完整。小*敏*感*词*数据或不完整的数据会进入数据源,破坏数据分析工作。

当一个商店有多个版本(不同的语言、地区等)或从不同的商店抓取数据时,数据质量尤为重要。

除了仔细的 QA 流程,在创建爬虫的设计阶段,通过相互审查和测试爬虫的代码,可以确保以最可靠的方式提取所需的数据。确保高数据质量的最佳方法是开发自动化 QA 监控系统。