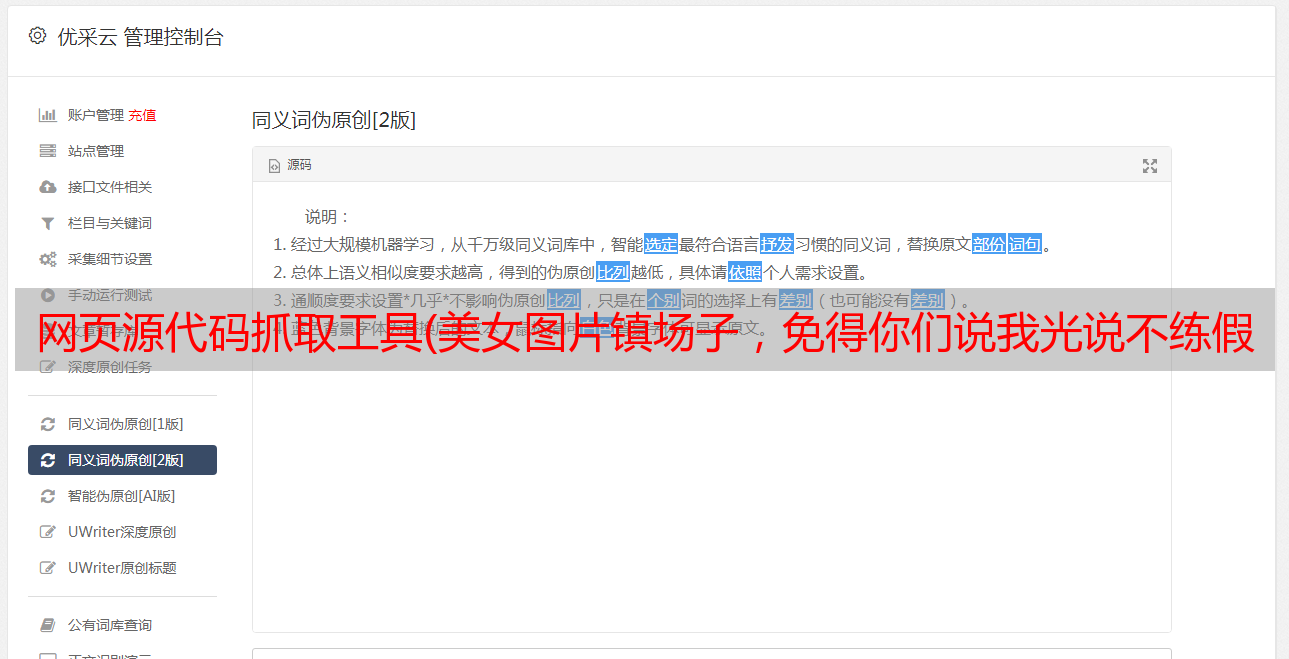

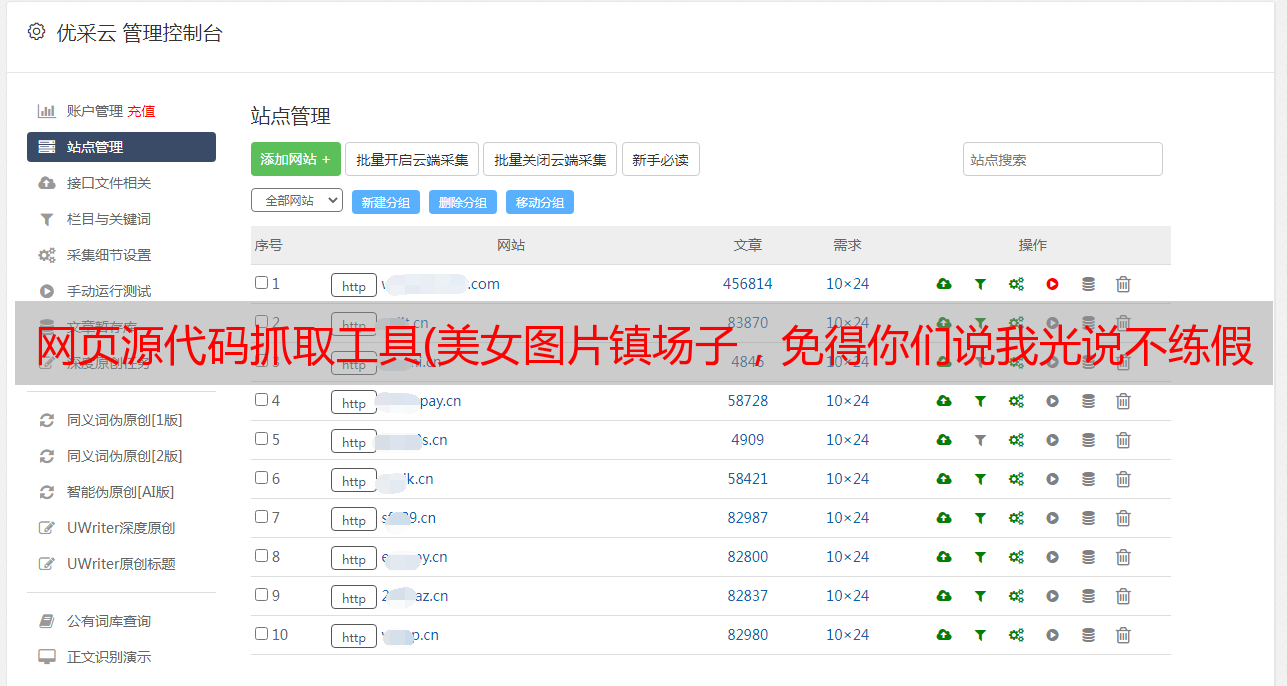

网页源代码抓取工具(美女图片镇场子,免得你们说我光说不练假把式!)

优采云 发布时间: 2021-12-29 13:41网页源代码抓取工具(美女图片镇场子,免得你们说我光说不练假把式!)

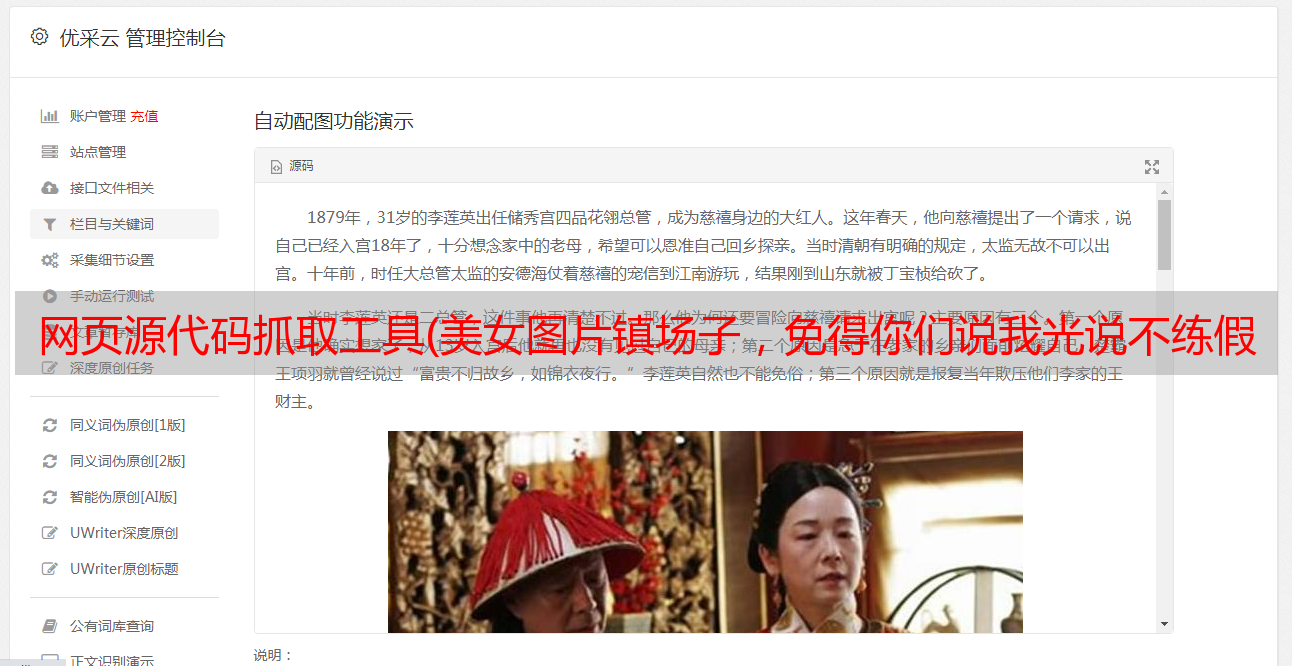

首先,爬取镇上美女的图片,免得你说我刚才讲了!

话不多说,开始吧!首先了解需要额外安装的第三方库

由于淘女郎网站收录

AJAX技术,因此只需与后台交换少量数据即可实时更新,这意味着直接抓取网页源代码并分析信息的方法行不通。

对于这类网站,一般有两种抓取方式:

使用selenium库模拟浏览器的用户行为,使服务器认为真实用户在浏览网页,从而获得完整的网页源代码

使用Chrome等浏览器自带的分析工具对网页的网络进行监控,分析数据交换API,利用API捕获数据交换的JSON数据,然后进行捕获。

从效率上看,第一种方法比较慢,也占用系统资源,所以我们用第二种方法来实现。

先写请求,然后从淘女孩网站获取JSON文件。

将请求发送到服务器。然后获取服务端的JSON数据,对返回的数据进行处理,再转换成Python字典类型返回。具体代码如下:

def getInfo(paeNum):

tao_datas ('vievFiag':"A", "currentPage": pageNum)

try:

r=requests. post ("http://nn. taobao. com/tatar/seateh/tatar_nodel. do?_input_charset=utf-8*, data = tao. data)

except:

return None

rav_datas = json. loads(r.text)

datas rav_datas['data']['searchDoList']

returh dat as

返回后,我们连接MongoDB,保存返回的信息。

def main():

client = MongoClient ()

db =client. TaoBao

col = db. TaoLady

for pageNun in range(I,411): 淘女郎一共有410页,所以我们抓取从1到第411页的内容。

print (pageNun)

datas=getInfo(pageNun)

if datas;

col.insert_nany(datas)

if__nane__='__main__';

main()

分析返回的信息,然后提取消息中的图片URL信息,将过度使用的图片保存到PIC文件夹中:

def downPic():

client=HongoClient()

db = client.TaoBao

col=db.TaoLady

for data in col, find():

nane = data['realName']

url =“http:" + data[" avatarUr1']

pie=urlopen(url)

vith, open("pic/" + name +",jpa,vb”) as file:

print(name)

file.vrite(pic. read())

if __nane__='__main__':

downPic()

OK,大功告成,原图全部超清晰,不过由于图片数量多,我的16G U盘几乎装不下,这里就不一一展示了,只截了一部分大家来看看。如果觉得文章还行,不妨点个赞。任何意见或意见,欢迎评论!

我是python开发工程师,整理了一套python学习资料。如果你想提升自己,对编程感兴趣,请关注我,私信后台编辑:《08》可免费领取素材!希望能帮到你!