搜索引擎优化(seo)的基本工作模块(网站建设中搜索引擎相关的原理,你知道吗?-网慧天下科技)

优采云 发布时间: 2021-12-29 11:12搜索引擎优化(seo)的基本工作模块(网站建设中搜索引擎相关的原理,你知道吗?-网慧天下科技)

网汇天下科技今天就为您讲解网站建设中搜索引擎的相关原理,帮助您更好的建设和优化您的网站。

SEOER首先要了解的不是网站怎么优化,更不是怎么发链接,因为这些东西大家都知道,最重要的是了解搜索引擎的结构和原理。当然,如果你足够聪明,你可以认真研究搜索引擎排名。算法原理,了解了这些,就再也不用担心搜索引擎排名优化了。规则是人定的。搜索引擎的蜘蛛和爬虫虽然是由程序自己完成的,但是既然程序是人开发的,那么这些程序的运行规则就必然有规律可循。

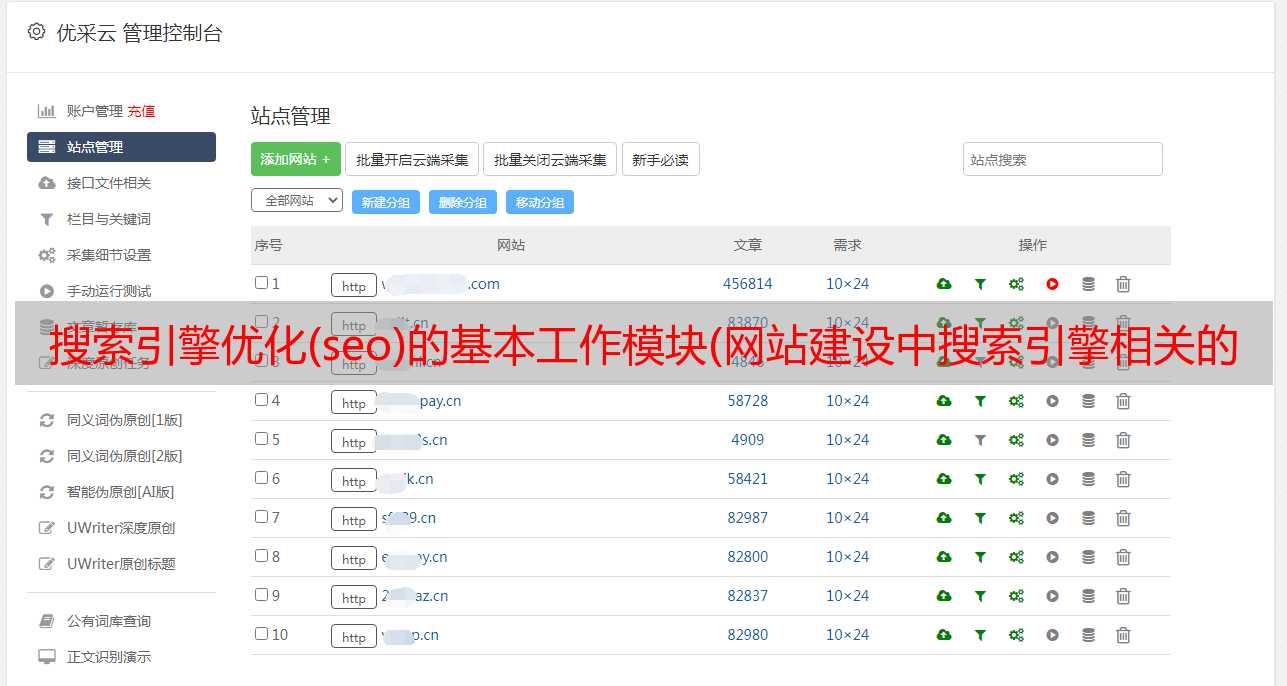

现在随着互联网的飞速发展,相关行业也越来越火爆。SEO就是其中之一。许多年轻人开始投身于这个行业。在百度进入SEO,我们不难发现很多关于SEO外链和更新的经验分享,但是我们很多SEOer并没有真正了解SEO。当然外部链接和更新很重要,但是学习和了解搜索引擎的基本结构和原理也是非常有必要的。一个通用的搜索引擎一般收录

以下功能模块:

1、Spider,即Spider,一种类似浏览器的程序,旨在下载网页

2、 Crawler,Crawler,用于自动跟踪所有页面的链接

2、 Index,即Indexer,用于分析蜘蛛和爬虫下载的网页

4、结果引擎,从数据库中提取搜索结果

5、数据库,存储下载的页面信息和处理过的页面信息

6、Web服务器,用于处理用户搜索交互请求的Web服务器

不同的搜索引擎的实现在某些地方可能会有一定的差异。比如蜘蛛+爬行+索引的组合功能是通过一个程序实现的。它在分析结果的同时下载页面,并使用现有链接来发现新资源。当然,这些功能是所有搜索引擎所固有的,所体现的SEO原理也大同小异。

下面简单介绍一下搜索引擎的功能模块。

Spider:该功能模块专门用于下载页面,类似于浏览器的功能。它们之间的区别在于浏览器向用户显示各种形式的信息,包括文本信息、图像信息、视频信息等;对于蜘蛛,没有视觉组件。它是直接处理基本的html源代码。众所周知,标准的网络浏览器具有查看html源文件的功能。

爬虫:这个功能模块专门让用户发现每个页面的所有链接。它的任务是通过评估找到的链接或定义的地址来确定蜘蛛去哪里。爬虫跟踪已找到的链接,并尝试找到一些搜索引擎不知道的文档。

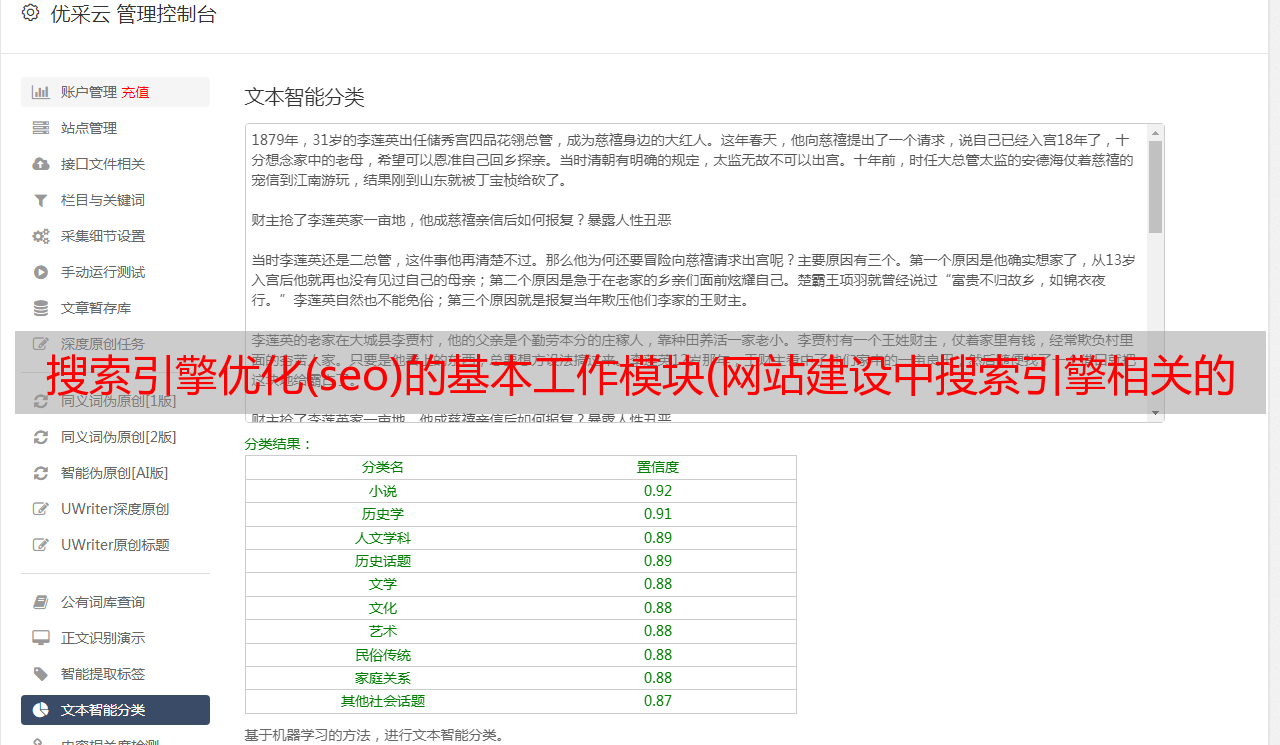

索引:这个功能组件负责解析每个页面,然后分析各种页面元素,如文本内容、页眉内容、结构化或自定义特征、特殊的html标签等。

结果引擎:结果引擎用于对页面进行排名。它确定哪些页面最符合用户的搜索请求,并以有效且合理的顺序显示这些结果。这是根据搜索引擎的排名算法确定的。它追求页面排名有价值并受用户兴趣驱动的想法,因此这对SEO工作者来说是最有趣的。SEOER 的目标是有效地改进他们关心的网站的页面。排行。