搜索引擎如何抓取网页(蝙蝠侠IT将通过如下内容阐述内容的情况阐述!)

优采云 发布时间: 2021-12-27 12:07搜索引擎如何抓取网页(蝙蝠侠IT将通过如下内容阐述内容的情况阐述!)

如果您是从事 SEO 项目的 SEO 从业者,我们经常做的一件事就是检查网站日志。偶尔我们会遇到这样的情况:

搜索引擎的抓取工具每天只抓取一个页面,而不会抓取网站上的任何其他页面。这让SEO从业者头疼,难以维持长期运营。

那么,为什么搜索引擎只抓取一个固定的页面呢?

根据之前对百度蜘蛛的研究,蝙蝠侠IT将详细阐述以下内容:

1、页面内容更新

一般来说,如果你是一个新网站,在网站建设的初期,首页通常是一个长时间反复爬取的页面。在这个过程中,你几乎每天都会看到蜘蛛只抓取主页,甚至你的主页。指数只是一条直线。

一般来说,如果您刚刚推出了一个新网站,我们认为这种情况是可以理解的。您可能需要在整个站点中不断输出内容,并经常将其显示在主页上。

搜索蜘蛛可能有更高的概率爬取相关内容。

2、页面可访问性

这是司空见惯的情况。我们认为应该从两个角度来讨论页面可访问性:

①页面加载速度

②页面上的机器人协议

如果您的页面不是经常被抓取的页面的打开率非常高,我们认为与访问速度快的页面相比,其他页面很难获得搜索友好性。如果您的网站没有权重,则很容易被抓取。

当然,如果你错误地配置了robots协议,在一定程度上,其他相关页面也难以抓取,比如首页以外的页面被错误屏蔽。

3、较少的内部链接

这是一种比较特殊的情况。有时我们总会在企业网站内部构建一些高质量的页面,类似于专题单页。在一定程度上,我们希望该页面能够获得更高的搜索排名。

不是将权重转移到网站上的任何页面,而是采用 nofollow 策略来阻止页面上的所有链接。

基于这种策略,在一定程度上也会导致其他页面无法爬取的情况。

4、页面质量低

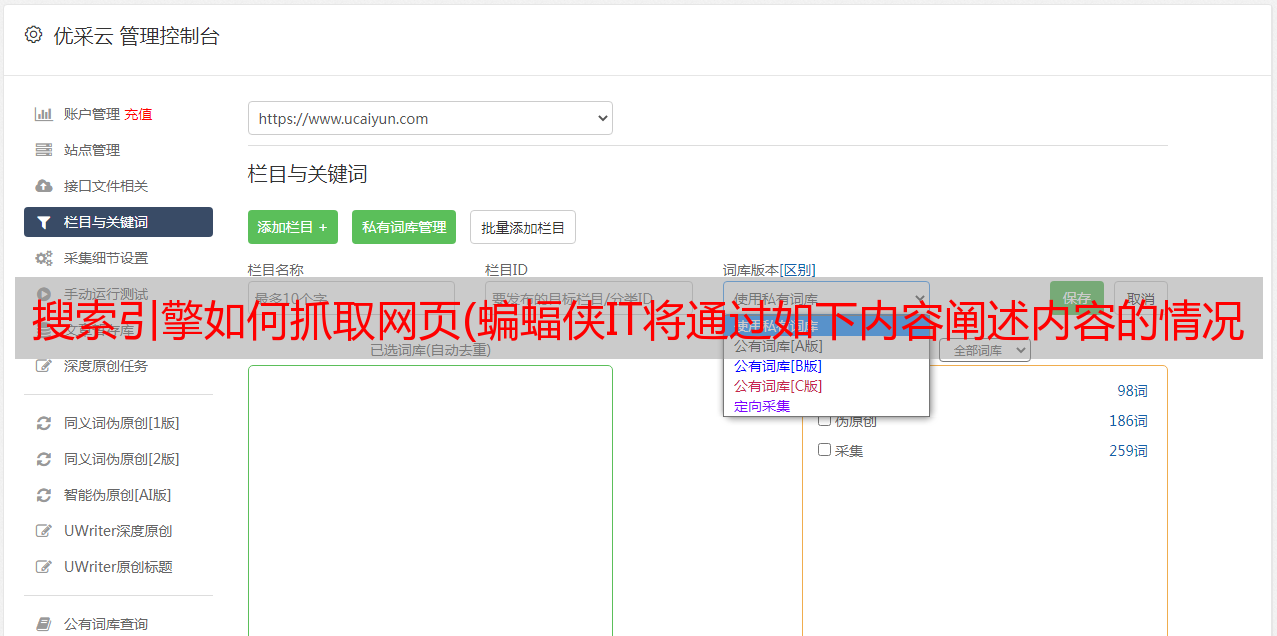

有时,我们在做网站内容更新的时候,为了快速让网站看起来更加丰富,我们偶尔会采集

、组合一些低质量的内容进行页面填充。

这导致搜索引擎在对目录的早期爬取时,基于大量低质量的内容评价策略,认定某个目录下的内容没有搜索价值,导致基本不爬取该目录下的任何内容。目录。

有时,即使您重新调整目录中内容的质量,也可能无济于事。

5、网站未备案

从目前来看,国内非备案网站和国内各大搜索引擎的表现都不是特别理想。搜索引擎长时间只抓取一个页面是很常见的。

此外,采集

此类网站极其困难。一般来说,如果你的内容不够优质,外链资源不够优质,很难获得有效信任。

所以,长时间只爬一个页面是正常的。

6、页面目录级别

在SEO诊断的工作中,我们经常会遇到这样的情况。网站好像没有什么问题,公司已经备案了,页面加载速度也不错。在长期运营的过程中,网站页面总是难以被爬取。抓。

在这种情况下,我们通常会检查站点中的某些目录级别。如果你的优质内容页面的目录层级很深,比如达到了4-5级,新的网站就很难被搜索引擎发现。这会导致蜘蛛长时间抓取一个页面。

7、页面提交通道

在早期的SEO工作中,我们知道如果你的页面质量好,并且保持较高的输出频率,通常搜索引擎会主动访问它,但随着信息内容的快速发展而增加。

搜索引擎在抓取页面的时候,往往会设置一定的级别,比如先抓取哪些频道,先查看哪些频道。

其中,页面提交的渠道尤为重要,尤其是API百度网址提交。

总结:搜索引擎长期只抓取固定页面,还有很多细节需要讨论,以上内容仅供参考!

蝙蝠侠IT转载需要授权!