网站内容采集(一个小网站数据采集,并写到excel里面(图))

优采云 发布时间: 2021-12-25 20:09 网站内容

" rel="nofollow" target="_blank">采集

今天给大家分享一个小网站的数据采集,用excel写出来!

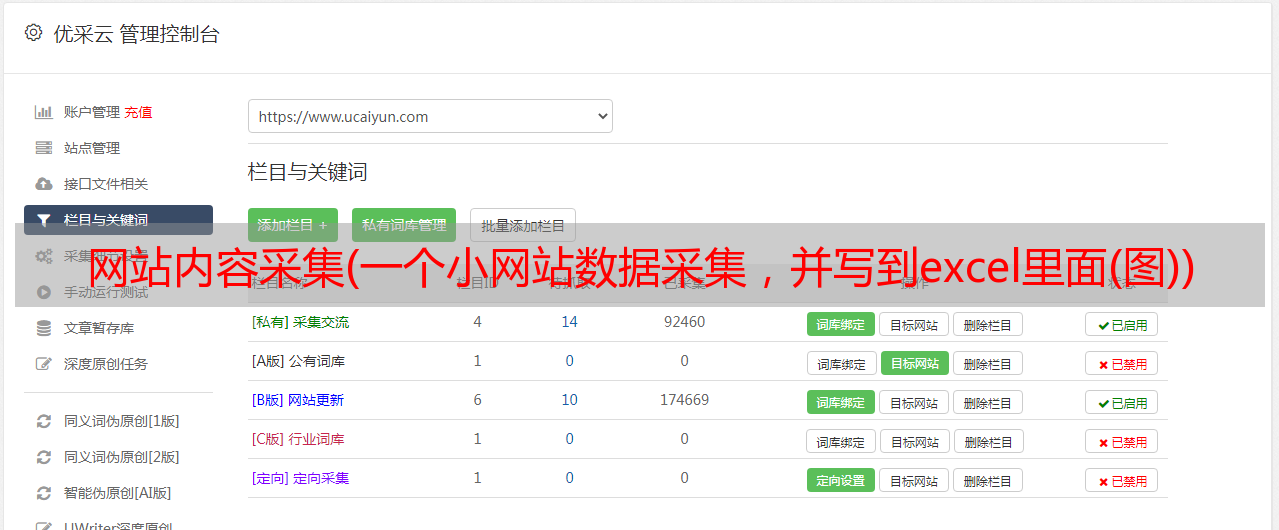

分析网站

目标网站是“小米购”,这里是天猫上所有收录

购物券的商品信息。让我们今天抓住它!

随便找一段文字,然后右击查看网页源码,看文字是否存在。如果存在,则该网页是静态网站!幸运的是,这个网站实际上是静态的。

就这么简单,不需要分析ajax加载数据或者找json包,直接获取网页源码==>>匹配相关内容==>>保存数据即可!

工具和库

Windows+python3.6

随机导入

导入时间

*敏*感*词*请求

从 lxml 导入 etree

*敏*感*词*xlwt

只需使用这些库!注意 xlwt 和 xlrd 这两个库是在 excel 上操作的。一种是保存数据,一种是读取数据。不要混淆它。

开始写代码

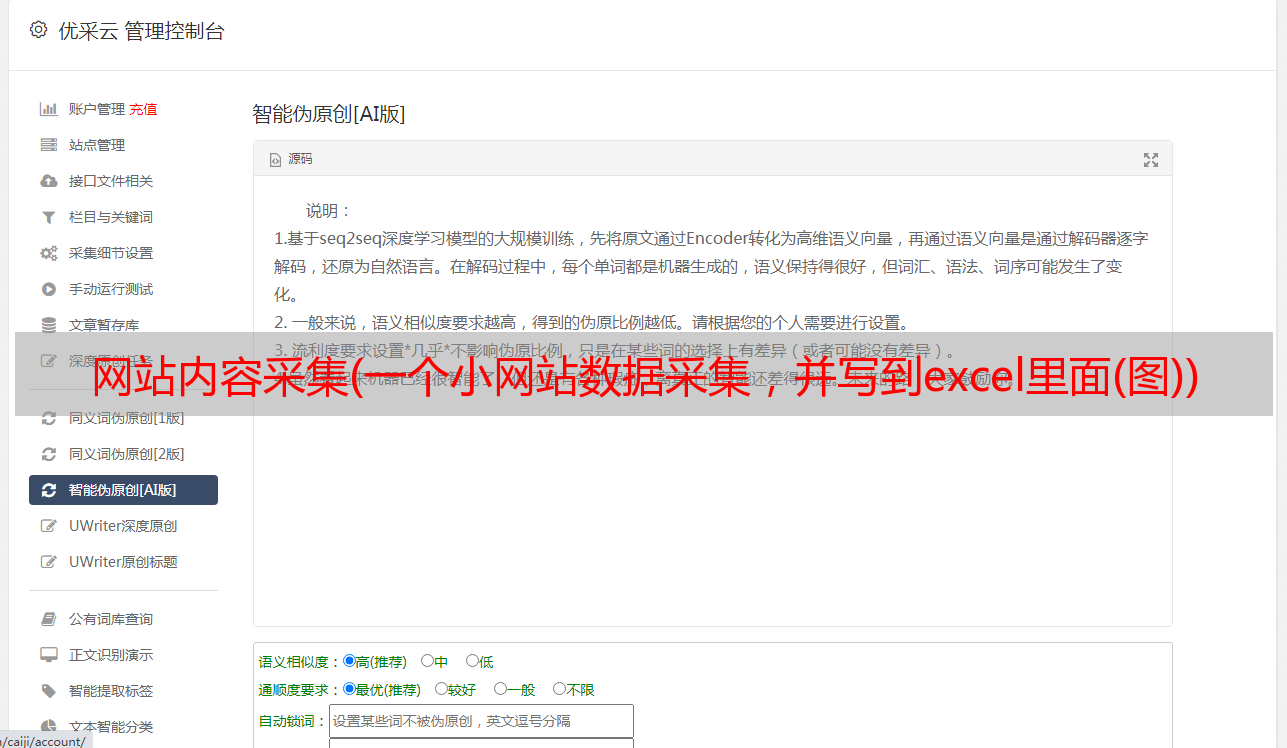

先写一个函数,将爬虫的所有工作写入函数中,如下图

这个网站需要写标题。如果你不写它,你将无法捕获数据!新建一个列表,将你爬到的相关数据写入列表。它的形式大致是这样的:[[Product Information A1, 2, 3...], [Product Information B1, 2, 3...]...],这样写列表的原因是我们将最后把它们写成excel表格,这样列表(或列表形式)中的每个元素都是一行数据,好写!

注意第33行,当列表形成时,使用+将列表中的所有元素连接成一个列表,例如:[1, 2, 3] + [4, 5] = [1, 2, 3, 4, 5],并使用append()函数将以下内容作为元素添加到列表中,例如:[1,2,3].append([4,5])=[1,2,3 ,[4 ,5]]

下一步是写入excel。首先新建一个excel表格,写入第一行数据

下面的数据依次按照格式写入,最后以wb.save(路径)的方式保存!完整代码及效果如下

因为网站更新非常快(官方是10分钟……),所以没有那么多爬虫。所有页面大约有 600 页,每页有 100 个信息,这意味着总共有 60,000 多个产品。信息,不使用多线程会慢!

代码将在上传过程中被压缩。如果看不清楚,可以私信我获取源码!