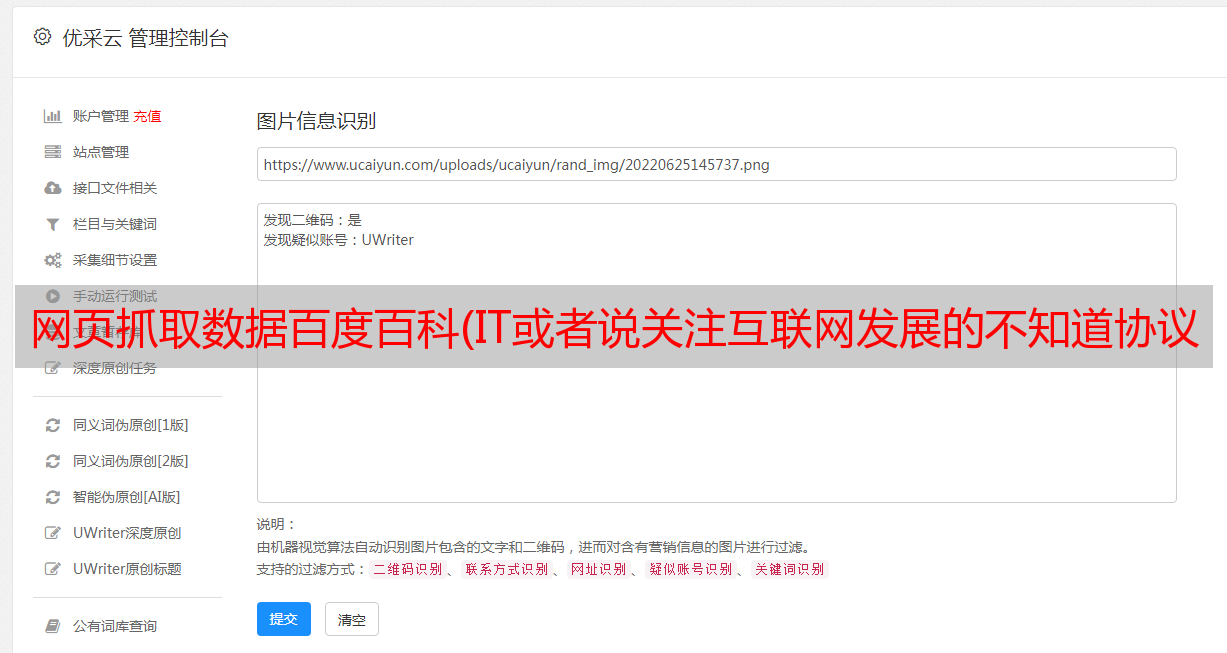

网页抓取数据百度百科(IT或者说关注互联网发展的不知道协议的应该很少)

优采云 发布时间: 2021-12-18 08:14网页抓取数据百度百科(IT或者说关注互联网发展的不知道协议的应该很少)

机器人协议防君子容易,防坏人难。

robots.txt(统一小写)是一种存储在

网站

在根目录

ASCII码

编码

文本文件

,它通常告诉网络

搜索引擎

机器人(也称为

网络蜘蛛

),这个网站中哪些内容不应该被搜索引擎的bot获取,哪些内容可以被bot获取。由于某些系统中的URL 区分大小写,因此robots.txt 的文件名应统一小写。robots.txt应该放在网站的根目录下。如果想单独定义搜索引擎robots访问子目录时的行为,可以将自定义设置合并到根目录下的robots.txt中,或者使用robots

元数据

(元数据,也称为元数据)。____ 摘自维基百科

这个协议不是一个规范,而只是一个约定。一些搜索引擎会遵守这个规范,而另一些则不会。通常搜索引擎会识别这个元数据,不会索引这个页面,以及这个页面的链接页面。注意这个加粗的句子。机器人协议不是强制性的。搜索引擎可以遵守,也可以不遵守。(当然不合规是有代价的。)我觉得是关注IT或者互联网的发展。不知道机器人协议的人应该很少。2012年,百度与360打响了一场封杀与反封杀之战,将原本为程序员所熟知的Robots协议变成了媒体热词。北京市第一中级*敏*感*词*'

大家都知道,互联网上有很多协议,比如我们经常使用的ipv4、ipv6、WiFi协议。这些协议的目的是让大家在访问端口时有一个统一的规范。应该是遵守了,就彻底乱了。这就好比国家制定的国家标准,或者行业指定的行业标准。只有统一的规范才能保证兼容性。然而,百度的行为完全无视行业标准,随意抓取他人的网页内容,犹如窃取。比如微信做个公章后,积累了大量的优质作者和文章,培养了大量用户的阅读习惯。腾讯投资搜狗,开放微信数据供搜狗搜索独家使用。这部分数据可以极大地帮助用户满足他们的浏览和阅读需求。来到“差异化”的体验点。因此,搜索依托腾讯的资源,将微信公众号文章嵌入到搜狗搜索中,同时还开发了基于公众号的微信头条推荐应用。

当然,这种高质量、专属的数据是需要专属保护的。搜狗还使用搜索引擎常用的robots协议来限制相应的目录,不允许其他搜索引擎对其进行抓取。但是百度在搜索相关关键词的时候抓取了这部分内容,放到了自己的搜索页面上。知道百度今天还在做这个,随便搜索一个微信公众号,你就会看到下面的结果。

如果不违法,那么大家自己判断是否存在道德问题。

在WiFi早年成为共识之前,WAPI协议是由中国工业和信息化部推动的。自2003年以来,我国先后颁布了一系列采用WAPI安全协议的无线局域网基本国家标准。