嘉兴网站搜索引擎优化(百度曾在站长贴吧里做过这样的一个回复)

优采云 发布时间: 2021-12-17 04:05嘉兴网站搜索引擎优化(百度曾在站长贴吧里做过这样的一个回复)

百度曾经在站长贴吧中做出这样的回复:从用户体验的角度来说,“有些转载可能不会比原创差”。比如一篇关于科技的博文原创被知名门户网站网站的技术频道转载。这种转载如果保留原创的名字和出处链接,其实对原创有利,因为传播效果更好。只是国内的翻版,很多都被砍到最后,让原创更受伤了。

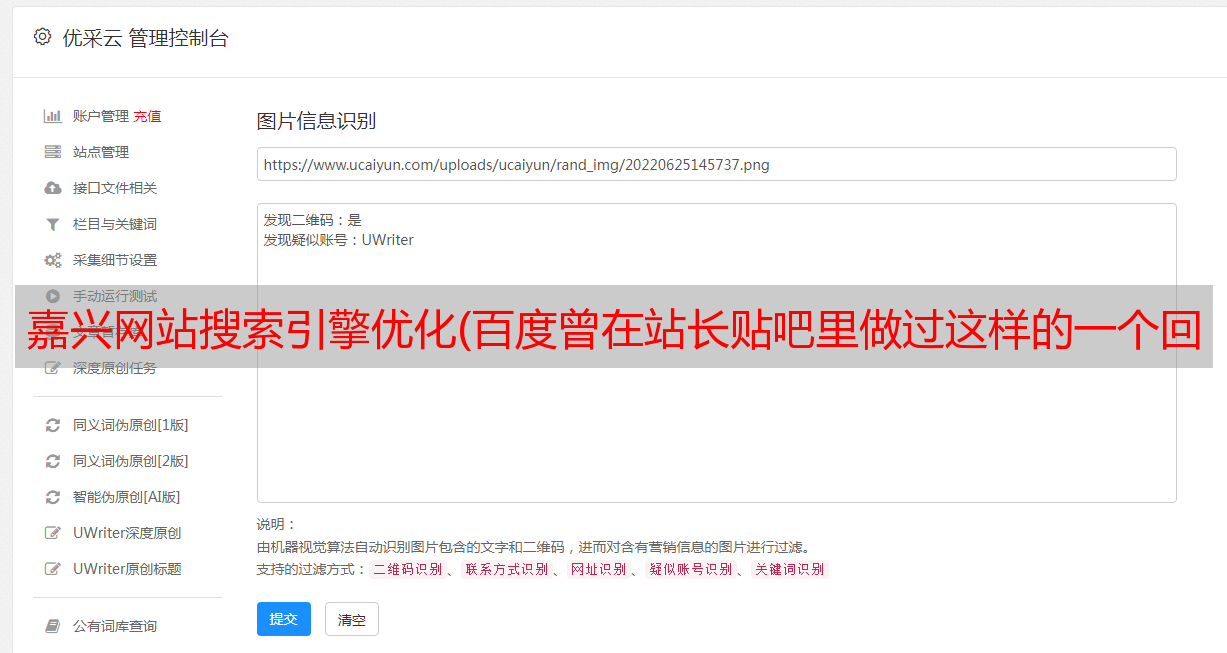

据数据显示,近似重复网页的数量占网页总数的29%,相同网页约占所有网页的22%。很多站长都会抱怨自己写的文章被转载后要么从排名中消失,要么被转载站排在最前面,如下图:

在解决这个问题之前,我觉得有必要了解一下搜索引擎的“去重算法框架”,换个角度看看搜索引擎是如何去重网页的。

您的网页什么时候会被删除?

因为网上大约有22%的内容是一样的,你的文章一旦在网上发表,就有可能被转载。一般来说,如果你的网页被判断为被转载,那么搜索引擎一般会从三个时间段中选择删除你的网页:

(1)在抓取页面时删除,可以减少搜索引擎的带宽,减少存储量;

(2)收录 之后删除重复页面;

(3)用户搜索时再次删除;增加准确度和耗时;

4种类型的内容重复:

1.如果两篇文章的内容和格式没有区别文章,这种重复就叫做“页面完全重复”

2.如果两篇文章文章内容相同但格式不同,则称为“内容重复页”

3.如果两篇文章文章某些重要内容相同,格式相同,则称为“布局重复页面”

4.如果两篇文章文章某些重要内容相同,但格式不同,则称为“部分重复页面”

删除重复页面对搜索引擎有很多好处:

1. 如果将这些重复的页面从搜索引擎数据库中删除,可以节省一些存储空间,提高检索质量。

2.为了提高网页采集的速度,搜索引擎会对以往采集的信息进行分析,提前发现重复的网页。这些网页可以在以后的网页采集过程中避免。这也是为什么总转载网站排名低的原因。

3. 对于镜像度高的网页,搜索引擎会给它更高的优先级,当用户搜索时,它会给它更高的权重。

4. 及时发现相似镜像网页有助于提高搜索引擎系统的服务质量,这意味着如果用户点击死链接,可以将用户定向到同一个页面,可以有效增加用户的搜索体验。

通用重复数据删除算法框架

对于网页去重任务,具体可以采用的技术方法是多种多样的,各有创新和特点,但仔细研究,其实大同小异。

上图是通用算法框架的流程图。对于给定的文档,必须通过某种特殊的提取方法从文档中提取出一系列能够表征文档主题内容的特征集。这一步往往有其内在的要求,即尽可能保留文档中的重要信息,删除不相关的信息。删除部分信息的原因主要是从计算速度的角度考虑。一般来说,删除的信息越多,计算速度就会越快。

这就是你想做的关键词没有排名,而你不想做的关键词却能排名高的原因之一。搜索引擎删除它认为不重要的词。