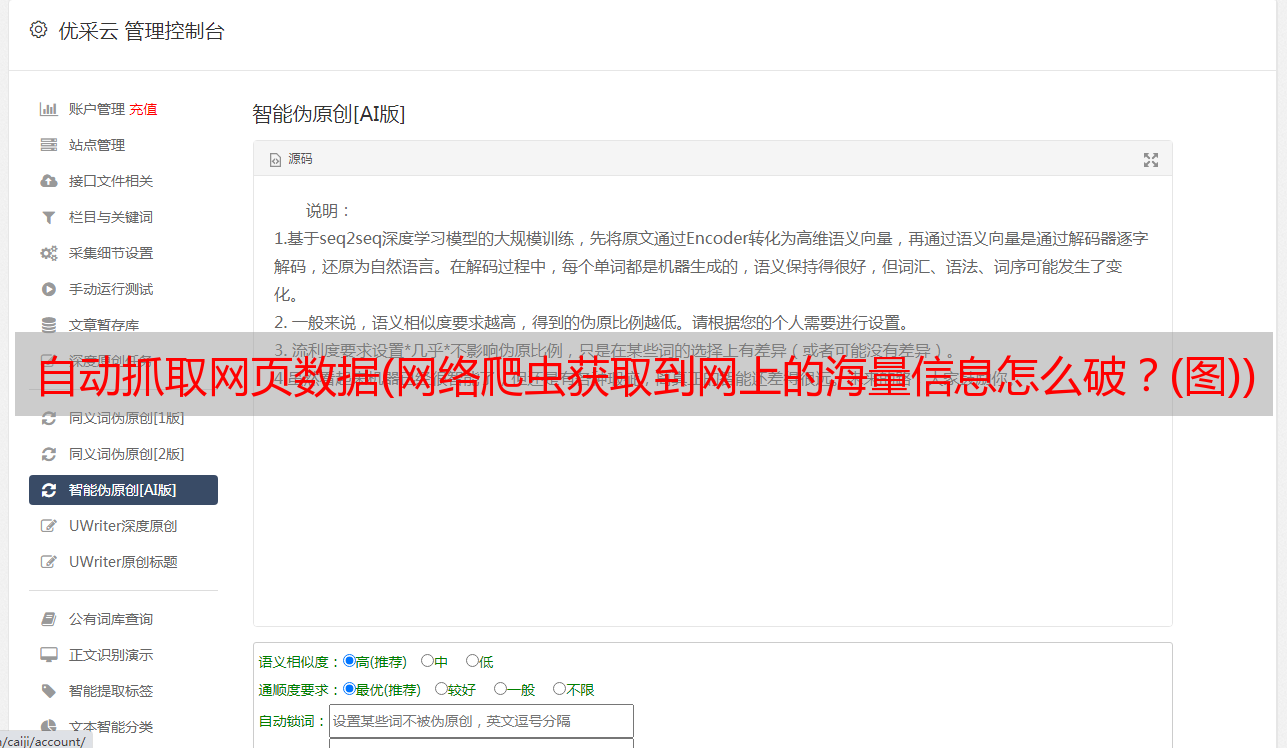

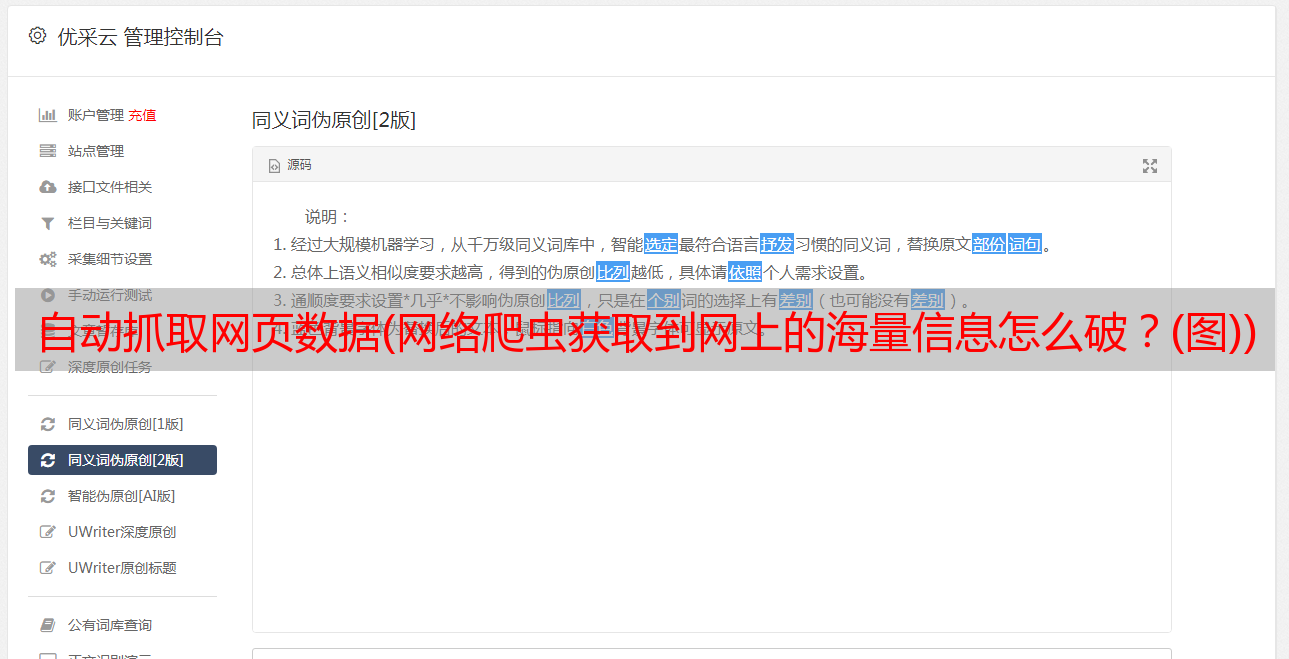

自动抓取网页数据(网络爬虫获取到网上的海量信息怎么破?(图))

优采云 发布时间: 2021-12-15 20:07自动抓取网页数据(网络爬虫获取到网上的海量信息怎么破?(图))

搜索引擎如果要获取互联网上的大量信息,就需要发布一个程序(按照一定的规则自动抓取万维网上信息的程序或脚本)来抓取互联网上的信息。这个程序叫做 Internet。爬虫。在百度、360、搜搜等搜索引擎中,网络爬虫也被称为搜索引擎蜘蛛,如百度蜘蛛、360Spider、Sosospider等;而在谷歌搜索引擎中,网络爬虫被称为谷歌机器人(googlebot)。下面我们将详细分析网络爬虫的工作原理和爬取网站的过程。

网络爬虫的工作是不断从互联网上检索信息,然后将索引数据存储在搜索引擎的服务器上。这个过程称为网络爬行。

网络爬虫工作的一般流程

由于搜索引擎并未公布其网络爬虫的工作原理,所以只能粗略估计网络爬虫的大致流程。

第一步,从精心挑选的*敏*感*词*网址中选取一部分,将这些网址放入待抓取的网址队列中;

第二步,服务器发送Request请求,获取对应的内容(Response),如果HTTP状态码为200,则发送网络爬虫对url页面进行爬取;如果是其他状态码(例如:404、50 0),网络爬虫会停止爬取url页面并记录状态。

第三步,网络爬虫查看网站的robots.txt文件,如果robots协议允许,就会抓取url的页面内容并发回服务器。如果robots协议不允许,网页数据将不会被抓取。, 直接返回,在数据库中标记。

第四步,下载该URL对应的网页,存储到下载的网页库中,并将这些URL放入爬取的URL队列中。

第五步,对爬取的URL队列中的页面进行分析,如果发现新的URL,则将新的URL放入待爬取的URL队列中,从而进入下一个循环。

网络爬虫只负责发现信息、爬取信息、去除网页重复、划分网页质量等级。这些任务是网络爬虫抓取数据后算法程序的工作。网络爬虫不参与。

有的朋友可能认为,网络爬虫只要进入网站,就会往下爬,然后爬取网站的所有页面内容。事实上,情况并非如此。网络爬虫不是贪吃蛇,它只是抓取当前网页信息并返回。对服务器后台数据进行分析后,如果发现新的网址,则将其添加到未抓取的网址列表中,搜索引擎会将其发送出去。新的网络爬虫用新的 URL 抓取网页。

事实上,网络爬虫更像是寻找食物的蚂蚁。网站 就像一大块食物。当一只小蚂蚁发现食物时,它会回去通知其他朋友,然后一批又一批的小蚂蚁就会离开。将食物带回并存放在仓库中。一只小蚂蚁找到一大块食物拼命把它带回去是不现实的。所以,领导自己觉得网络爬虫更像是蚂蚁,而不是蜘蛛。将其与蚂蚁进行比较会更合适。