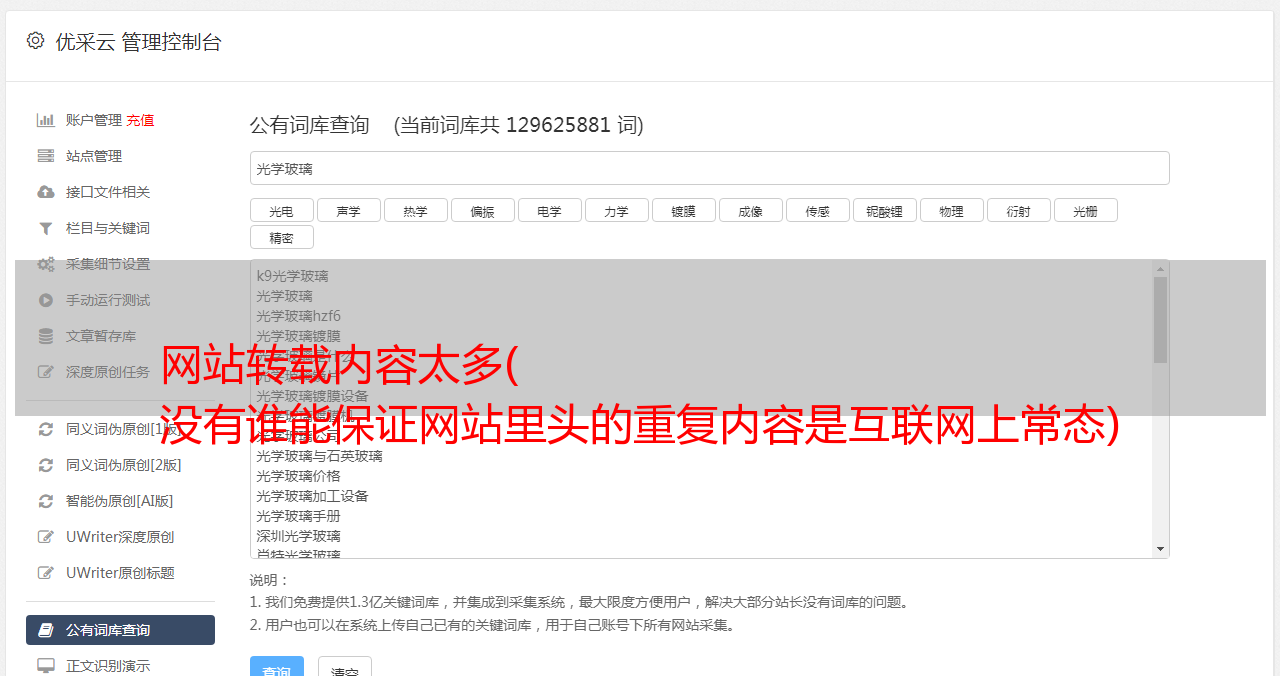

网站转载内容太多( 没有谁能保证网站里头的重复内容是互联网上常态)

优采云 发布时间: 2021-12-15 16:15网站转载内容太多(

没有谁能保证网站里头的重复内容是互联网上常态)

搜索引擎喜欢原创的内容,谷歌也喜欢,但没有人能保证网站中的信息都是原创文章,不可能与他人重复,很多人开始担心网站会被谷歌降级处罚。

重复的内容是互联网上的常态

首先,互联网世界充满了重复的内容。一些关于重复内容的研究表明大约 20%-30%。例如:

·当一个网页引用其他网站的内容时,难免会重复对方网页上的一些内容。

·另一个例子:当唐纳德特朗普赢得成为美国总统时,许多媒体可能直接剽窃和引用官方传记。

· 在线商店中经常会出现重复的内容。例如:产品页面和产品类别下的产品页面出现相同的产品描述。只要网址与搜索引擎不同,就可能被视为不同的页面。

·更常见的例子是同一个网站支持加密连接HTTPS和非加密连接HTTP。由于HTTP和HTTPS被搜索引擎视为不同的URL,也可以视为重复内容。

什么是搜索引擎惩罚

搜索引擎不会简单地惩罚具有重复内容的网页。

所谓惩罚,是指搜索引擎从索引数据库中取出网站页面,使搜索用户无法在搜索查询结果中找到该页面。

此外,搜索引擎可能会从索引数据库中提取网站的所有页面,导致用户无法找到网站的任何页面。

搜索引擎发现网页或网站涉及对搜索排名的不当操纵,因某些原因降低网页排名,一般被视为搜索引擎的惩罚。

如果内容重复但没有受到惩罚可以吗?

谷歌没有惩罚并不意味着他们喜欢重复的内容。搜索引擎的作用是为用户提供多样化的搜索结果。重复的内容对 Google 向搜索用户提出的查询给出了相同的答案,但 URL 不同,但内容几乎相似。

因此,搜索引擎只会从同一个答案中选择最好的综合网址放到搜索排名结果页面,其他相同答案会被筛选掉,这个筛选结果可能会被误解为搜索引擎惩罚。

一般只有当网站的内容是其他网站的大量简单处理,对用户没有价值,目的是操纵SEO排名时,搜索引擎才会引入惩罚。

重复内容,可出现在网络内外网站

网站中的重复内容更有可能影响搜索排名的质量得分。搜索引擎还会根据质量过滤搜索排名结果。这是之前熊猫搜索算法所做的工作。由于熊猫4.2 已经被集成到搜索引擎算法中。它可以看作是一个搜索引擎:Query Deserves Quality。因此,如果同一条内容在同一个网页上重复多次,质量得分和用户体验自然会下降,这对搜索排名不利。

网站中重复内容的最大危害是:如果网站中网页的内容是重复的,你想用A页对目标关键词进行排名,搜索引擎可能会认为重复内容页面 B 更适合并在 SERP 结果中使用页面 B。这就是蚕食的问题。

检查重复的内容

网站 太多重复的内容对搜索排名不利。搜索引擎会觉得网站的质量不好。一些工具(例如 siteliner)可以帮助检查重复的内容。

其他网站抄袭内容

重复内容最大的伤害更多是其他网站抄袭你的内容,导致搜索引擎因为QDD而不是抄袭的内容来筛选你的原创内容。

当然,你可以通过DMAC要求谷歌采取行动,比如从索引数据库中删除抄袭者的网页,或者大幅度减少抄袭者的网页资源。

了解搜索引擎使用什么标准从收录相同内容但 URL 不同的篮子中过滤最佳页面可能会帮助您跳过冗长的 DMAC 上诉过程并击败抄袭。

条件之一当然是网站权限。原创性不是搜索引擎的主要考虑因素,所以发布日期较早的可能不会被筛选出来。可能是因为搜索引擎认为后期发布者可能会改进内容,应该被屏蔽。返回搜狐查看更多