搜索引擎爬虫怎么知道往哪发送请求?(图)

优采云 发布时间: 2021-04-04 18:28搜索引擎爬虫怎么知道往哪发送请求?(图)

什么是搜索引擎

搜索引擎是一种计算机程序,可以帮助用户搜索所需的内容。换句话说,搜索引擎将计算机中存储的信息与用户的信息需求进行匹配,并显示匹配结果。

了解搜索引擎的工作原理后,可以解决很多优化问题,例如网站 网站有蜘蛛来了网站,网站为什么不收录,网站为什么网站 k19],没有排名。

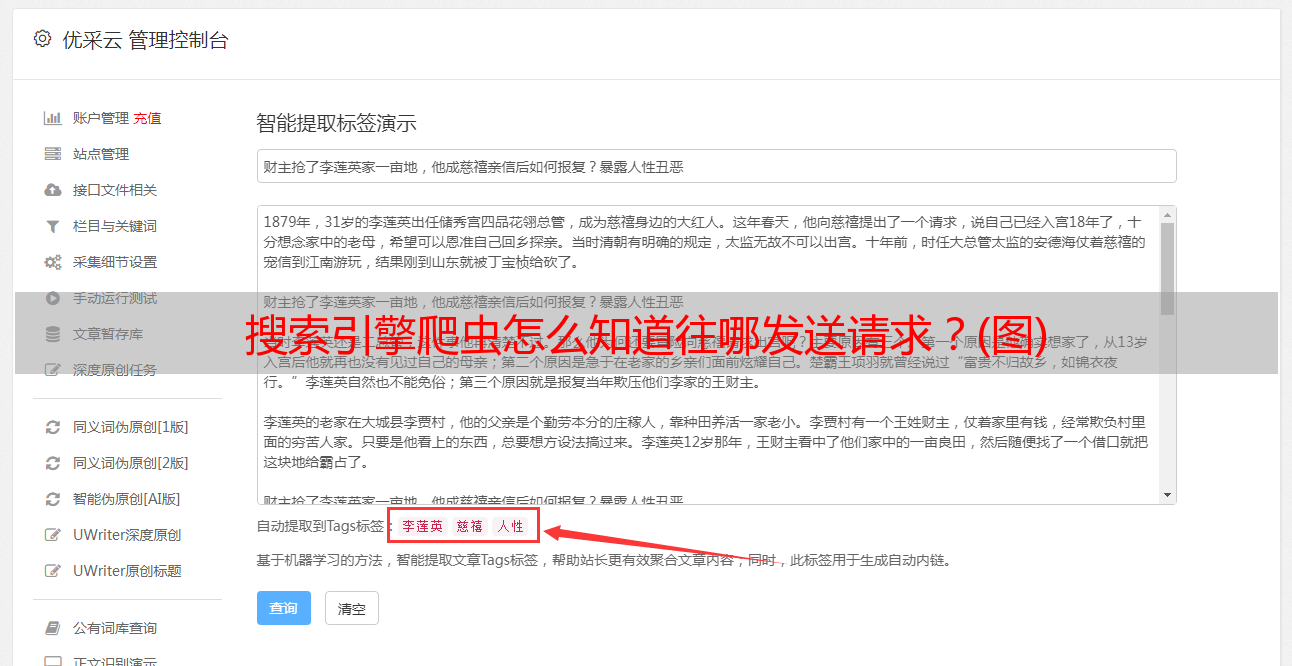

搜索引擎想要抓取Internet 网站页面,因此无法手动完成,因此百度,Google和他们的工程师编写了一个程序,他们给该自动抓取程序起了一个名称,即“ crawler”(也可以是被称为“蜘蛛”)。

Internet上的信息存储在无数服务器上。如果任何搜索引擎想要回答用户的搜索,则必须首先将网页存储在其自己的本地服务器上,该本地服务器依赖于Web采集器。它不断向各种网站发送请求以存储获取的网页。那么它如何知道将请求发送到哪里呢?通常的方法是使用网页之间的链接从网页开始,提取到其他页面的链接,将其视为下一次要请求的对象,然后连续重复此过程。有许多细节需要考虑。例如,避免使用带有循环链接的网页;解析Web文档(通常为html格式,但还有许多其他格式)以提取内部链接;无法打开链接等时处理错误。

出于安全性和其他原因,许多Web服务器都具有反恶意爬网程序。尽管他们的策略不同,但共同点是他们的目标是仅尽可能多地响应用户请求。但是搜索引擎爬虫通常无需担心,因为大多数网站都希望提高其搜索排名,并且欢迎访问搜索引擎爬虫。

搜索引擎的工作分为4个步骤:

1、爬行

图像可以像蜘蛛一样在Internet上爬行。它通过特定的代码模式跟踪网页的链接。这是从一个链接到另一个链接按顺序完成的,因为它是由机器执行的,因此也称为“机器人”。

从大量信息中,按照某些规则采集网站内容,最后提交,然后将结果反馈给采集器。可以理解为信息采集器。

2、抓取

以改善用户的搜索体验为目的的爬行程序是对“爬行者”接收到的信息进行初步检测和分类,并在用户中对有效信息进行分类以关注强信息。法律信息是稀缺信息等。获取并存储在数据库容器中,以通过下一步收录程序进行进一步严格的检查。可以理解,是由信息采购人员对信息人员采集的信息进行初步筛选。

3、 收录

将收录之类的一系列规则与1、的步骤2中的信息进行比较,并一一判断。符合规则的内容将存储在专用的索引数据库中以建立索引,这非常大。提高了用户的搜索效率,因此页面的内容也可以在索引数据库中成功收录。

4、排名

排名的计算方法是:处理搜索词,与数据库匹配,初始数据选择,相关性计算,过滤和调整以最终排名。根据用户搜索进行排序的规则机制关键词,如何在海量索引数据库中获得良好的优先级排序已成为SEO研究的主要方向。随着搜索引擎的发展和演进,智能化程度越来越高,规则算法也变得越来越复杂。

总的来说,搜索引擎的核心是满足用户需求,并在用户面前展示用户所需的知识,而一切都从满足用户需求开始。