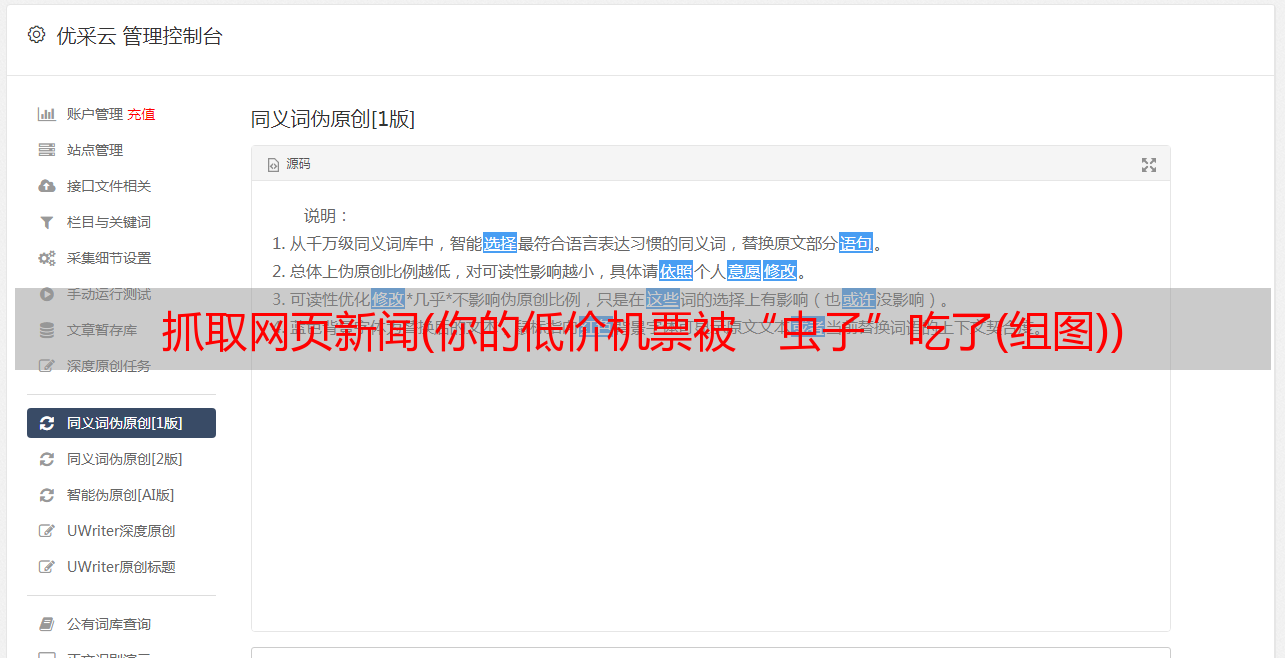

抓取网页新闻(你的低价机票被“虫子”吃了(组图))

优采云 发布时间: 2021-12-13 14:01抓取网页新闻(你的低价机票被“虫子”吃了(组图))

你的低价票被“虫子”吃掉了

资料图:北京某公交车站出现抢票浏览器广告。中新社发 刘关官摄

还有不到两个月,2018年的春节就要到了。

“今年我得早点动身,抢到一张低价回家的机票。” 在北京工作的小王告诉科技日报记者。由于老家在云南,春节的机票太贵了,所以他选择坐了两天两夜。优采云 回去,路漫漫其修远兮。

然而,正当小王急于利用自己的“早熟力”抢到便宜机票时,却在网上看到一则新闻,航空公司开出的低价机票中,80%以上都是机票“爬虫”。公司。抢了它,普通用户很少用。

小王傻眼了,什么是“爬虫”?它是怎么抢到票的?没有办法管理吗?

使用超链接信息抓取网页

“‘爬虫’技术是实现网络信息采集的关键技术之一。通俗地说,‘爬虫’就是一个用来批量和自动化采集网站数据的程序,几乎没有需要人工干预。” 北京理工大学网络科学与技术研究所副教授闫怀志告诉科技日报记者。

据闫怀志介绍,“爬虫”也被称为网页“蜘蛛”或网络机器人。它们是根据一定的规则自动抓取网页信息的程序或脚本,通常驻留在服务器上。网页不仅收录用户可以阅读的文字、图片等信息,还收录一些超链接信息。网络“爬虫”使用这些超链接不断地爬取互联网上的其他网页。

“这种信息采集的处理过程很像一个爬虫或蜘蛛在互联网上漫游,因此网络‘爬虫’或网页‘蜘蛛’得名。” 闫怀志说,“爬虫”最早应用在搜索引擎领域,比如百度、百度、搜狗等搜索引擎工具每天需要抓取互联网上百亿个网页,需要依靠在庞大的“爬虫”集群上实现搜索功能。

目前,“爬虫”已经广泛应用于电子商务、互联网金融等诸多领域。例如,“爬虫”可以抓取航空公司官网的机票价格。“爬虫”发现低价或卖空机票后,可以利用虚假客户的真实身份信息进行抢先预订。此外,许多网络浏览器都推出了自己的抢票插件,以推广订票成功率高的浏览器。

根据抓取任务和目标的不同,网络“爬虫”大致可以分为批处理型、增量型和垂直型。批量式“爬虫”的爬取范围和目标比较明确,可以是设置的网页数量,也可以是耗时设置。增量“爬虫”主要用于不断抓取更新的网页,以适应网页的不断变化。垂直“爬虫”主要用于具有特定主题内容或特定行业的网页。

“爬虫”是如何抢票的

此前,携程“反爬虫”专家在技术分享中透露,某个网站的页面每分钟有1.20000次页面浏览,而真实用户只有500人,“爬虫”流量占比为 95.8%。

采访中,多位业内人士也表示,即使在“爬虫”活动淡季,虚假流量也占到预订总流量的50%网站,期间更是高达90%以上。高峰期。

那么,“爬虫”是如何实现抢票的呢?对此,闫怀志解释说,主要原因是机票代理机构利用“爬虫”技术,不断抓取机票官网信息。如果发现航空公司有低价机票,“爬虫”会立即使用虚假旅客身份进行批量预订。但并不是实际付费,以达到抢低价票来源的目的。因为“爬虫”的效率远远超过正常的人工操作,通过正常的操作抢票几乎是不可能的。

随后,机票代理公司将通过自己的销售渠道(包括公司网站、在线旅行社、客户电话订购等),在航空公司允许的计费周期内找到真正的客户来源, 使用虚假来源退订,然后使用真实身份信息订购该身份预留的低价票,最后以加价转售该低价票。

如果在航空公司规定的计费周期内没有找到真正的客源,票务代理会在订单到期前添加虚假身份订单,继续“占用”低价票,以此类推,直到真正找到并出售客源。

“上述操作流程构成了一个完整的机票销售链条。在这个流程中,航空公司的售票系统允许在计费周期内重复订票和退票,这为票务机构利用“爬虫”抢票、提价提供了便利。这种的抢票方法被称为技术'黄牛'。” 严怀之强调。

的确,有业内人士表示,这些“爬虫”流量消耗了大量机器资源,但并没有产生任何消耗。这是每个公司最讨厌的。不过,由于担心误伤真实用户,各家公司的“反爬虫”策略一直非常谨慎。

“爬虫”可以通过一定的手段进行预防和控制

一切都有两个方面,“爬虫”技术也不例外。

在闫怀志看来,“爬虫”不仅可以为正常的数据批量获取提供有效的技术手段,还可以被恶意利用,获取不正当利益。如果“爬虫”技术使用不当,会带来一定的危害。

一是威胁数据安全。机票销售网站数据被恶意抓取,数据可能被机票代理公司恶意利用,也存在被同行业竞争对手收购的风险。

其次,导致系统性能下降,影响用户体验。大量“爬虫”的爬取请求会导致航空公司售票网站服务器资源负载增加、性能下降、网站响应缓慢甚至无法提供服务,会对机票产生负面影响用户搜索和交易体验。然而,由于利益的巨大灰色空间和“反爬虫”技术在对抗“爬虫”中的作用有限,这种明显不公平的“作弊”方式已经成为一种扰乱门票秩序的技术“病”。市场。

“从技术角度来说,拦截‘爬虫’可以使用网站流量统计系统和服务器访问日志分析系统。” 闫怀志表示,通过流量统计和日志分析,如果单个IP访问、单个会话访问、User-Agent信息超过设定的正常频率阈值,则判定该访问为恶意“爬虫”,“爬虫” IP被列入黑名单,拒绝后续访问。

然后设置各种访问验证链接。例如,访问可疑IP时,返回验证页面,要求访问者填写验证码、选择验证图片或字符等方式完成验证。如果是恶意的“爬虫”爬取,显然很难完成上述的验证操作,这时就可以阻断“爬虫”的访问,防止其恶意爬取信息。

互联网空间不能有“灰色地带”

当前,以云计算、大数据为代表的新一代信息技术正处于快速发展阶段。

“上述新技术如果被非法或不当应用,将造成严重危害。互联网空间的安全需要建立健全完善的保护体系,绝不能“裸奔”。颜怀之说道。

2017年6月1日,我国《网络安全法》正式实施,明确了各方在网络安全保护中的权利和责任。这是我国网络空间治理和法制建设由量变到质变的重要里程碑。该法作为*敏*感*词*治理互联网、化解网络风险的法律工具,已成为我国互联网在法治轨道上健康运行的重要保障。

但是,目前对于高科技“黄牛”的剥头皮行为,尚无明确规定,将恶意爬取信息的行为置于法律法规的“灰色地带”,不当获利行为。

闫怀志介绍,Robots协议(即“爬虫”协议、网络机器人协议等)是国际上专门针对“爬虫”应用制定的。该协议的全称是“Web Crawler Exclusion Standard”。网站 可以告诉“爬虫”通过这个协议可以爬取哪些页面和信息,不能爬取哪些页面和信息。本协议作为网站与“爬虫”之间的一种沟通方式,规范“爬虫”的行为,限制不正当竞争。

作为国际互联网界共同的道德规范,协议的原则是:“爬虫”和搜索技术应该为人类服务,同时尊重信息提供者的意愿,维护他们的隐私权;网站 有义务保护其使用人的个人信息和隐私不受侵犯。这规定了爬虫和被爬虫双方的权利和义务。

一位不愿透露姓名的法律专家也表示,“反爬虫”不仅要靠技术防范和行业自律,还要完善管理和法律法规来约束这种行为,尤其是法律手段可以证明惩罚和威慑。. 航空公司也必须加强对账期的管理,不给“爬虫”提供抢票机会。