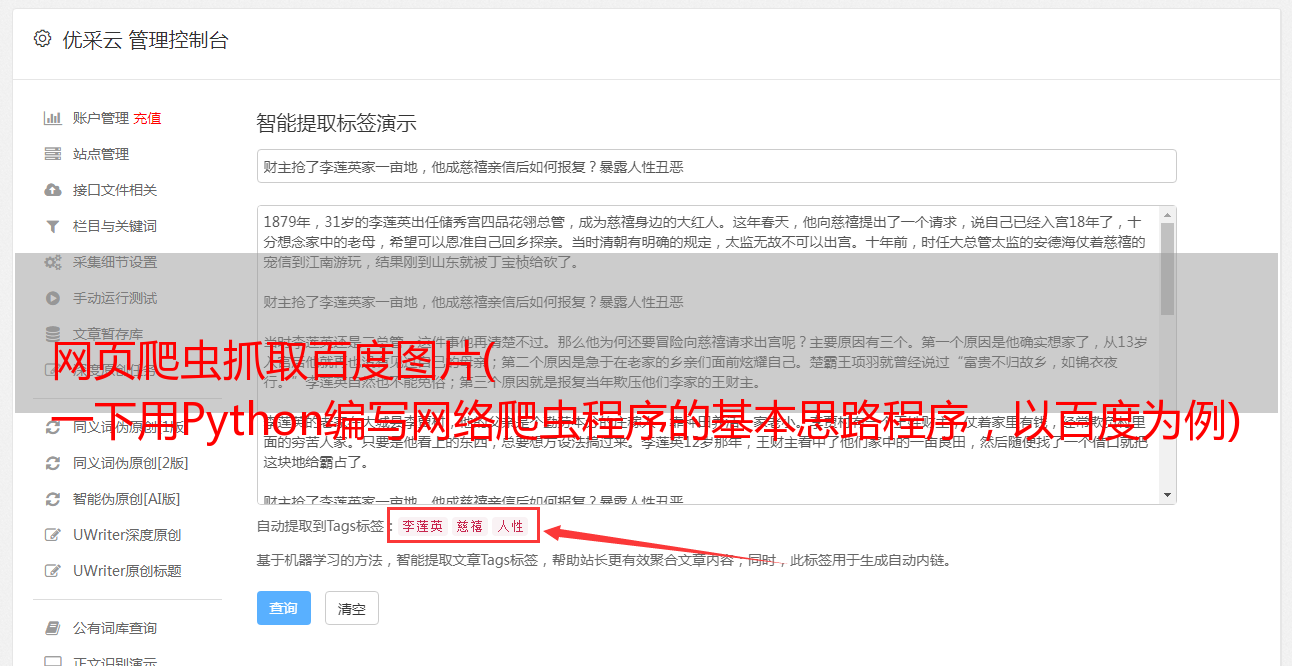

网页爬虫抓取百度图片( 一下用Python编写网络爬虫程序的基本思路程序,以百度为例)

优采云 发布时间: 2021-12-09 11:12网页爬虫抓取百度图片(

一下用Python编写网络爬虫程序的基本思路程序,以百度为例)

Python编写简单的网络爬虫

根据网上给出的例子,简单总结一下用Python编写网络爬虫程序的基本思路。以百度为例,主要策略如下: Python 提供了很多模块,通过这些模块,你可以做一些非常简单的事情

工作。比如在百度搜索结果页面中获取NBA这个词的每个搜索结果对应的URL,这是一个非常简单的爬虫需求。

1、 通过 urllib2 模块获取相应的 HTML 源代码。

# -*- encoding: utf-8 -*-

import urllib2

url=\'http://www.baidu.com/s?wd=NBA\'

content=urllib2.urlopen(url).read()

print content

通过以上三句,可以将URL的源代码存储在content变量中,其类型为字符类型。

2、下一步就是从这堆HTML源代码中提取我们需要的内容。使用Chrome查看对应的内容代码(也可以使用Firefox的Firebug)。

可以看到标签中存储了URL,可以使用正则表达式获取信息。

Pile 是将一个字符串编译成 Python 正则表达式中使用的模式。字符前的 r 表示它是纯字符,因此不需要对元字符进行两次转义。re.findall 返回的是字符串中的正则表达式列表。站点依次输出我们想要获取的网络地址。这里需要强调的是,我们需要编写正确的正则表达式才能得到我们想要的结果。这里的代码可能不够准确。

import re

urls_pat=re.compile(r\'(.*?)\')

siteUrls=re.findall(r\'href="(.*?)" target="_blank">\',content)

for site in siteUrls:

print site

3、对得到的结果进行处理:例如进一步获取有用的信息或存储信息;例如,使用相关数据结构进行*敏*感*词*网络爬虫,或分布式网络爬虫设计。

当然,网络爬虫的原理很简单,但是当你需要对网络资源进行*敏*感*词*的处理时,就会遇到各种各样的问题,需要做各种各样的优化处理任务。这里是一个简单的介绍。“理解。