SEO怎么做?搜索引擎的具体优化规则是什么?

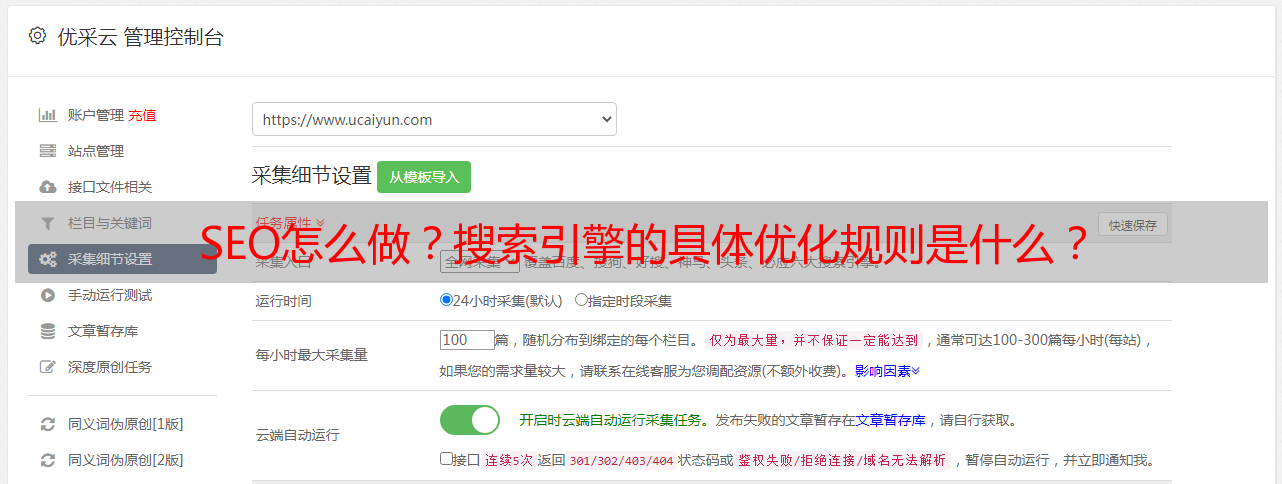

优采云 发布时间: 2021-03-31 04:24SEO怎么做?搜索引擎的具体优化规则是什么?

1、搜索引擎的具体优化规则是什么?

搜索引擎的优化规则是什么

这种问题实际上非常广泛,相当于问“ SEO怎么做?”。这是一张解释爬网规则的图片。

从用户搜索到最终搜索结果显示的搜索引擎步骤如下(以百度为例):

正在获取,百度不知道您的网站,您如何排名?因此,要让百度了解您,您必须先执行抓取步骤;

过滤,过滤掉低质量的页面内容;

索引,将仅存储合格的页面;

处理,处理搜索字词,例如中文分词,删除停用词,判断是否开始集成搜索,判断是否存在拼写错误或错字。

排名,向用户显示高质量页面;

搜索引擎的优化规则是什么

蜘蛛():

搜索引擎发送的用于在上查找新网页并对其进行爬网的程序称为蜘蛛。它从一个已知的数据库开始,像普通用户的浏览器一样访问这些网页,并跟踪网页中的链接,并访问更多的网页,此过程称为“抓取”;

蜘蛛对站点的遍历和爬行策略分为深度优先和宽度优先。

搜索引擎的优化规则是什么

爬行的基本过程:

根据抓取目标和范围,它可以分为批抓取工具:清除抓取目标和范围,并在到达目标时停止;增量爬虫:响应连续的网页更新状态,爬虫需要及时响应,通用商业引擎通用。垂直采集器:仅针对特定字段中的目标采集器,并根据主题进行过滤;

百度在爬网过程中的官方策略

1、抓取友好性,同一站点的抓取频率和一段时间内的抓取流量有所不同,也就是说,错开常规用户访问量峰值的不断调整以避免被捕获到过多的影响网站正常的用户访问行为。

2、常用的抓取返回码,例如503,404,403,301等;

3、多个URL重定向的标识,例如http 30x,元重定向和js重定向,标记也可以视作伪装的重定向;

4、抢夺优先级分配,例如深度优先遍历策略,广度优先遍历策略,公关优先级策略,反链策略,大站点优先级策略等;

5、重复的URL过滤,包括URL规范化标识,例如,URL收录大量无效参数,但实际上是同一页面;

6、采集暗网数据,暂时无法被搜索引擎捕获的数据(例如网络数据库中存在的数据或由于网络环境而导致的数据),网站本身不符合规范,孤岛等问题。抓取,例如百度的“阿拉丁”项目;

7、进行爬网的反作弊,在爬网过程中经常会遇到所谓的爬网黑洞或大量低质量页面的麻烦,这要求爬网系统还必须设计一套完整的爬行防作弊系统。例如分析网址特征,分析页面大小和内容,分析与爬网规模相对应的网站规模等;

有3种感兴趣的页面类型:

1.从未进行过爬网的新页面。

2.对内容经过修改的网页进行了爬网。

页面已被3.抓取,但现在已删除。

搜索引擎的优化规则是什么

蜘蛛不能/不喜欢爬网的内容:

1.被阻止的页面;

2.图片,视频和内部内容;

3. Js,框架,嵌套;

4. 被服务器阻止;

5.“岛屿”页面(没有任何导入链接);

6.登录后可获得的内容;

四种类型的近似重复页面:

1.完全复制页面:内容和布局格式没有区别;

2.内容页面重复:内容相同,但布局格式不同;

3.版式重复页面:一些重要内容相同,版式格式相同;

4.一些重复的页*敏*感*词*有相同的重要内容,但是布局格式不同;

典型的网页重复数据删除算法:特征提取,文档指纹生成,相似度计算

低质量的内容页面:

1.多个URL地址指向相同的网页和镜像站点,例如同时带有www和不带有www的网址解析为一个网站;

2.网页的内容重复或几乎重复,例如采集的内容,文本不正确或垃圾邮件;

没有丰富的内容,例如纯图像页面或页面内容搜索引擎无法识别;

过滤器如何处理重复的文档:

1.低质量内容将被删除

2.高质量的重复文档首先被分组并显示(高度重复意味着欢迎)