从网页抓取数据(从当当网上采集数据的过程为例,你了解多少?)

优采云 发布时间: 2021-11-19 19:10从网页抓取数据(从当当网上采集数据的过程为例,你了解多少?)

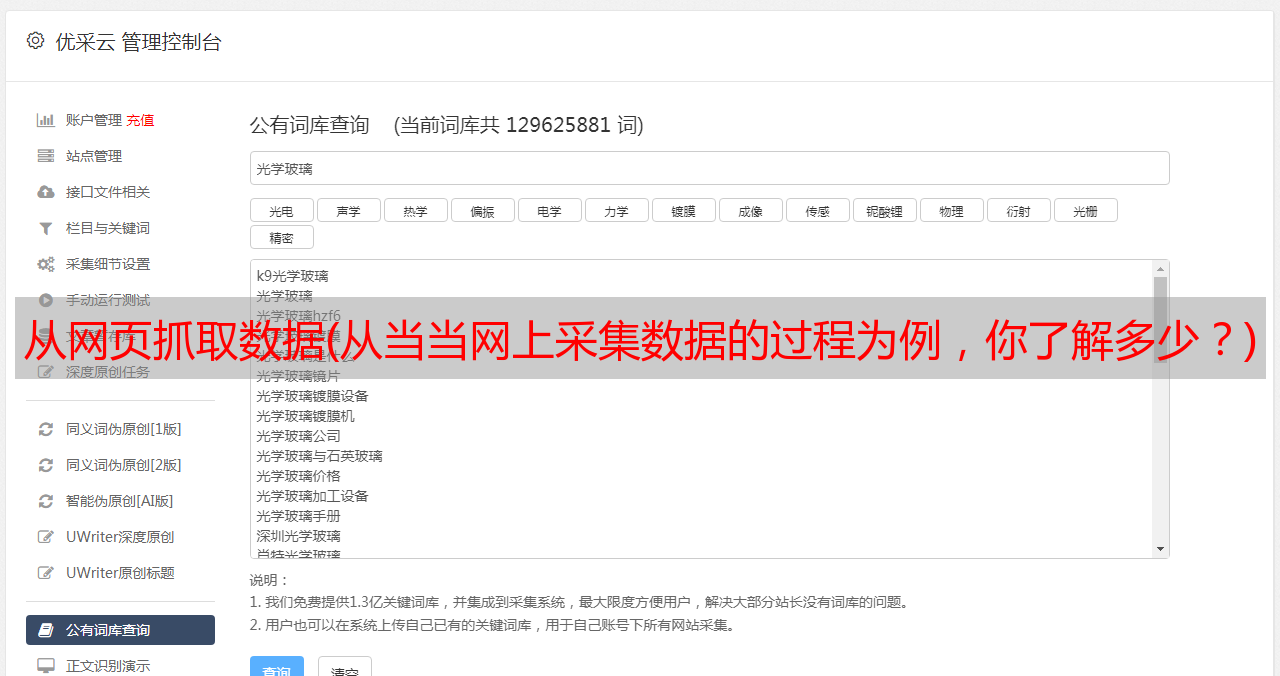

所谓“网页数据抓取”,也就是网页数据采集、网页数据采集等,就是从我们平时通过浏览器查看的网页中提取需要的数据信息,然后将结构以CSV、JSON、XML、ACCESS、MSSQL、MYSQL等格式存储在文件或数据库中的过程。当然,这里的数据提取过程是通过计算机软件技术实现的,而不是通过人工复制粘贴的方式。也正因为如此,才有可能从*敏*感*词*的网站中采集。

下面以作者从当当网获取采集数据的过程为例,详细解释一下web数据抓取的基本过程。

首先,我们需要分析目标网站的网页结构,判断网站上的数据是否可以采集以及如何采集。

当当网是一个综合性的网站,这里以图书数据为例。检查后,我们找到了图书信息的目录页。图书信息以多级目录结构组织。如下图所示,图片左侧为图书信息一级目录:

因为很多网站出于数据保护的原因会限制数据显示的数量,比如数据最多可以显示100页,超过100页的数据就不显示了。这样,如果您选择进入更高级别的目录,您可以获得的数据就越少。因此,为了获得尽可能多的数据,我们需要进入下级目录,也就是更小的分类级别,才能获得更多的数据。

点击一级目录,进入二级图书目录,如下图:

同理,依次点击每一级目录,最后可以进入最底层的目录,这里显示的是该目录下可以显示的所有数据项的列表,我们可以称之为底层列表页,如图:

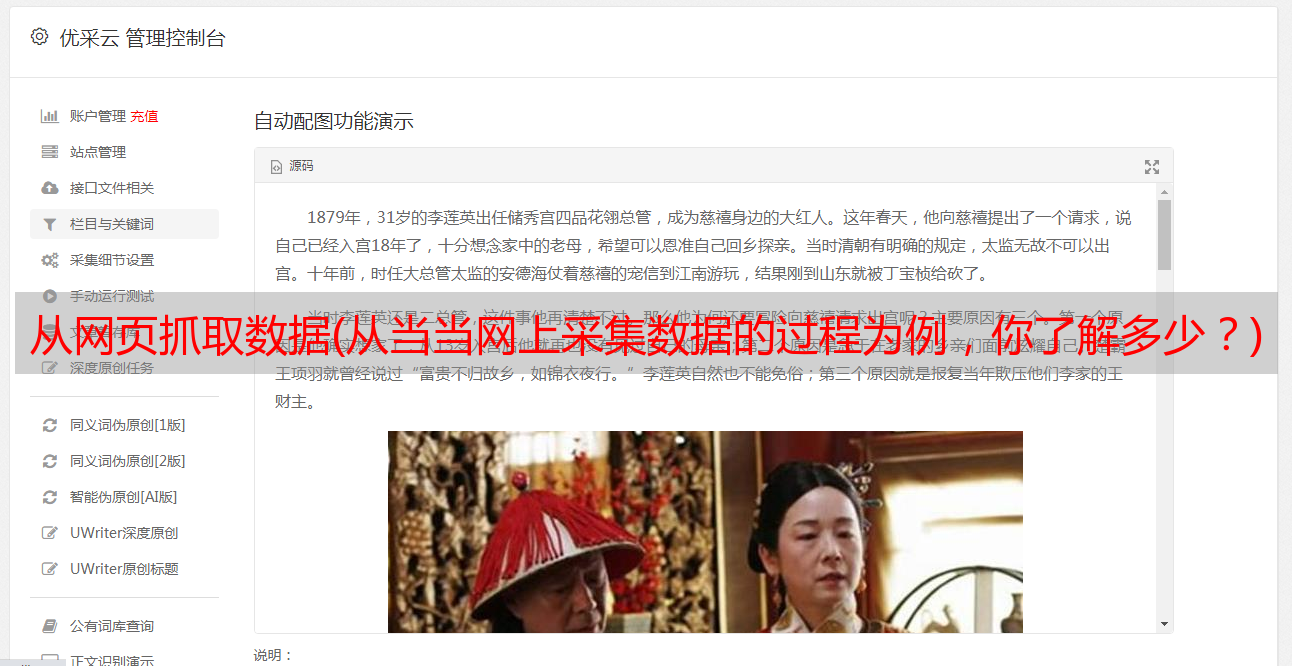

当然,这个列表页面很可能会被分成多个页面。我们在做数据采集的时候,需要遍历每一页的数据项。通过每个数据项上的链接,您可以输入最终数据。该页面,我们称之为详细信息页面。如下所示:

至此,获取详细数据的路径已经明确。接下来我们要分析详细页面上有用的数据项,然后有针对性地编写数据采集程序,然后我们就可以抓取到我们感兴趣的数据了。

以下是作者编写的当当网图书数据的网页数据爬取程序的部分代码:

以下是作者采集得到的部分图书信息样本数据:

至此,一个完整的网页数据抓取过程就完成了。