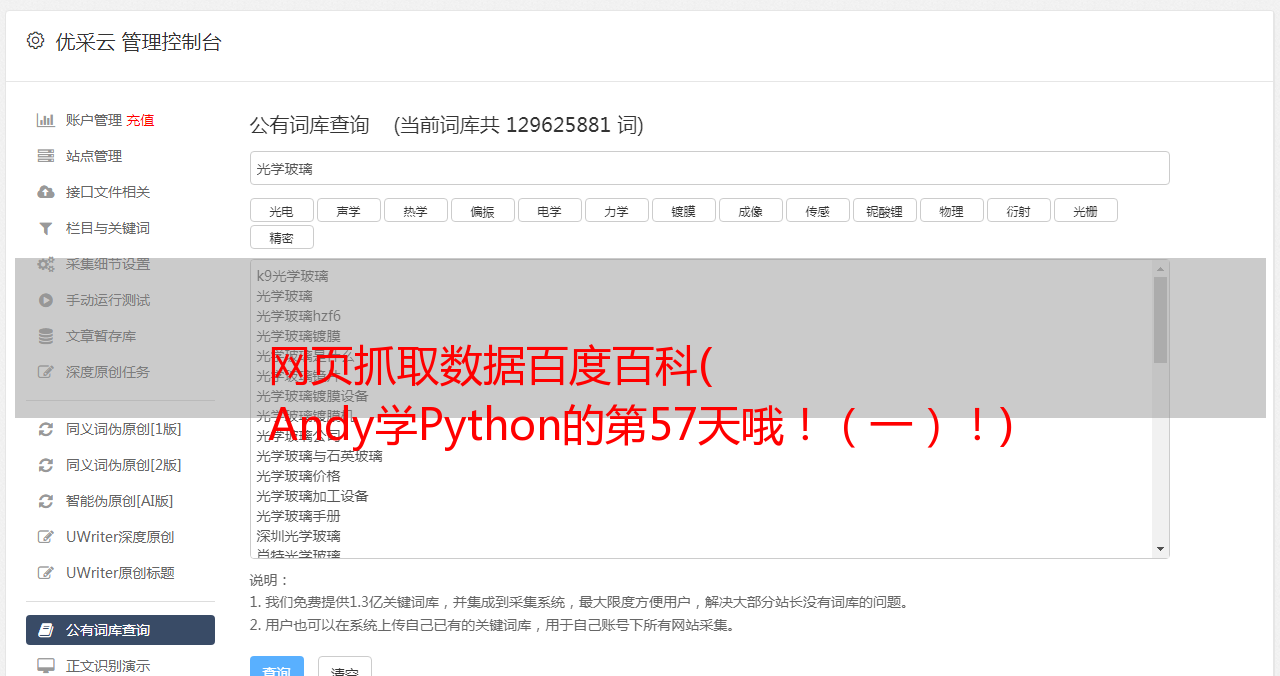

网页抓取数据百度百科( Andy学Python的第57天哦!(一)!)

优采云 发布时间: 2021-11-11 16:16网页抓取数据百度百科(

Andy学Python的第57天哦!(一)!)

今天是安迪学习Python的第57天!

大家好,我叫安迪。

这几天有朋友问,“听说你最近在学Python网络爬虫,有没有兴趣开始一个项目?” 我朋友目前有一个很麻烦很无聊的任务,就是从网上查抄1W+的企业。并将数据一一保存到excel。我试图查询一家公司的 1 条记录。按照安迪目前的技术水平,我用Python是做不到的。采取前三个最简单的步骤,从excel中复制公司名称,在浏览器的指定网页中打开搜索框,粘贴公司名称。我无法实现。我的朋友听了,看起来很困惑。他说,网上有很多示例项目。代码是现成的。只需要改代码,创建爬虫,自动抓取数据,粘贴到excel中即可。

我无语了,突然发现,在我学爬虫之前,我好像也是这么想的。其实很多人还没有搞清楚“网络爬虫”和“网络爬虫”的区别,一直以为两者是一回事。其实并不是。

01.

网络爬虫

百度百科定义:

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常见的是网络追逐者)是按照一定的规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称是蚂蚁、自动索引、模拟器或蠕虫。

搜狗百科定义:

网络爬虫也称为网络蜘蛛,网络机器人,是一种用于自动浏览万维网的程序或脚本。爬虫可以验证网页抓取的超链接和 HTML 代码。网络搜索引擎和其他网站通过爬虫软件更新自己的网站内容(网页内容)或索引到其他网站。

维基百科定义:

网络爬虫(英文:web crawler),又称网络蜘蛛(spider),是一种用于自动浏览万维网的网络机器人。它的目的一般是编译一个网络索引。网络搜索引擎和其他网站通过爬虫软件将自己的网站内容或索引更新到其他网站。网络爬虫可以保存他们访问的页面,以便搜索引擎可以生成索引供用户以后搜索。

结合这三个定义,网络爬虫的目的是获取万维网上的信息,并根据需要编制网络索引,主要用于搜索引擎。

所以问题是,我们不是搜索引擎。有没有学习网络爬虫的P?

02.

网页抓取

百度百科和搜狗百科都没有对网络爬虫的定义,只有基本的介绍(内容完全一样,如下)

网络爬虫主要有以下三个方面:

1. 采集新网页;

2. 采集自上次采集以来发生变化的网页;

3. 找到自上次采集后不再保存的网页,并将其从库中删除。

维基百科对个人感觉的定义比较靠谱:

网络爬虫是一种从网页中获取页面内容的计算机软件技术。通常通过软件使用低级超文本传输协议来模仿正常的人类访问。

网络爬虫与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网页抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。网页抓取的目的包括在线比价、联系人抓取、天气数据监测、网页变化检测、科学研究、混搭和网络数据集成。

技术层面:网页抓取用于自动获取万维网信息

1. 手动复制粘贴:最好的网络爬虫技术还不如人工手动复制粘贴,尤其是当网站采用技术手段禁止自动网络爬行时。手动复制和粘贴是唯一的解决方案。

2. 文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。可以在基于UNIX的系统上使用grep,其他平台或其他编程语言(如Perl、Python)中也有相应的命令或语法。