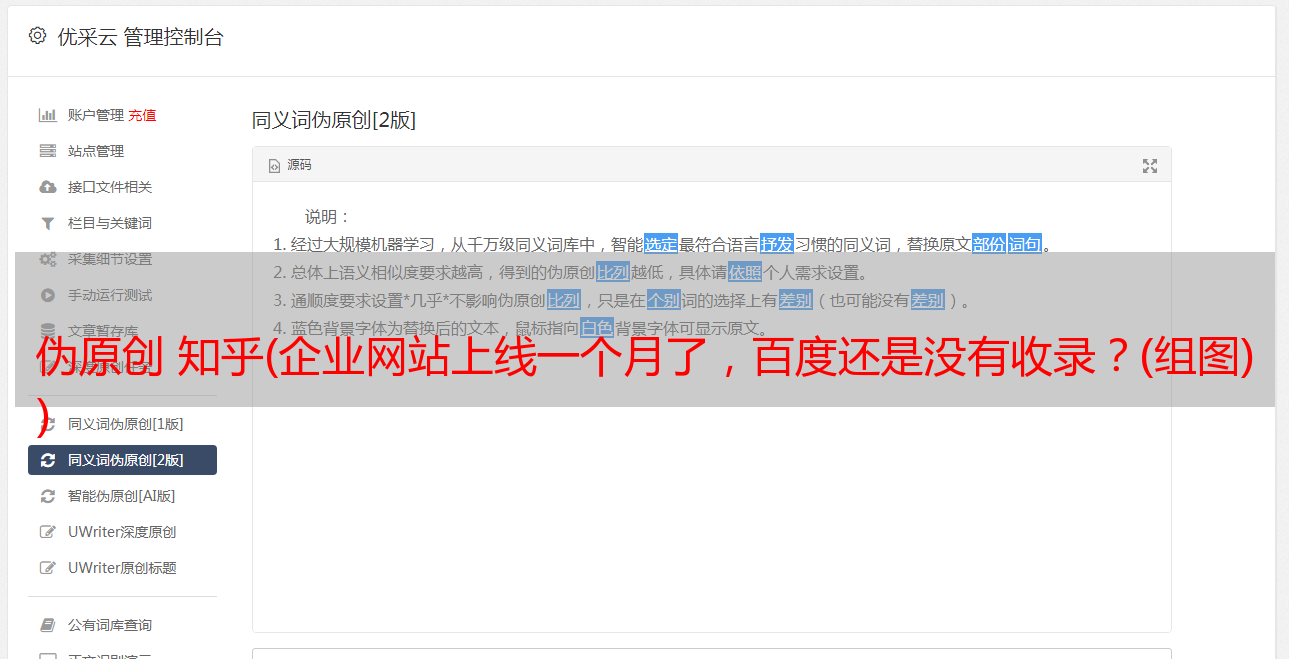

伪原创 知乎(企业网站上线一个月了,百度还是没有收录?(组图) )

优采云 发布时间: 2021-11-08 04:11伪原创 知乎(企业网站上线一个月了,百度还是没有收录?(组图)

)

有朋友说他的网站上线一个月了,每天坚持一个原创文章,却一直没有收录。功夫不负有心人,于是我诊断网站,并在更改博客域名后写了第一个网站诊断文章。也可以看作是过去每天 2 小时阅读 SEO 书籍的总结。【我公司网站上线一个月了,坚持每天至少一篇原创文章,百度还没有收录。我不知道该怎么办?】 看完网站,可以参考以下解决方案进行操作。最好解决网站不是收录的问题。【ZAC在《SEO实用密码》中提到网站收录的比率

有朋友说他的网站上线一个月了,每天坚持一个原创文章,却没有被百度上过收录。努力不赚钱,所以分析了网站,写了博科改域名注册后的第一个网站分析稿。也算作最后一天 2 小时 SEO 借书的总结。

【我公司网站上线一个月,坚持每天至少一篇原创文章。百度没有被百度收录。我不知道该怎么办?】

看完网站,实际操作可以参考以下处理方法。会更好的处理不被收录转为网站的问题。

【ZAC在《SEO实战演练登录密码》中提到收录率低,SEOER人员必须调整URL结构知乎蜘蛛seo超级外链工具,增加外链基础设施。URL结构是指爬虫输入URL后,可以更顺畅的抓取网页各页面的内容。网站的外链功能是向爬虫展示网站被爬取的渠道]。

1.robot.txt 很难设置。该网址没有robot.txt文件,可以立即清除,因为robot.txt设置不正确。建议是设置URL的robot.txt。百科全书看不懂。

2.网站 构造问题:看了网站的结构,做了一个表格布局合理的网页。代号是沈玉。没有对爬虫友好的div+css合理布局,但不代表网址爬虫就不能爬取网址。但是网站的URL并没有被伪静态解析,进一步增加了URL爬取的难度(伪静态除外:URL设置首选域、301、404网页、站点地图等设置,建议改进)。在 URL 结构层面存在一定的困难。但这并不代表搜索引擎网站的产品质量有问题:这是爬虫不抓取网址的关键原因。

(1)所有网页布局和客户体验都很差,网页质量不高

(2)虽然手稿是原创(不查,我坚信是原创),但是篇幅很小。

建议:稿件长度不要超过500字,以文图融合的形式展示。

(3) SEO不成功:除了缺少稿件和升级空间外,百度搜索引擎无法信任此类稿件。关键词和网址都存储在每章的稿件中,一目了然,属于过度推广的稿件 如果内链连接的权重值不能有效传输,一切都是无效的。即使过了一段时间,百度收录URL,如果你要保证关键词在首页的排名。

3. 外链问题:我们必须改进爬虫抓取网址的方式,做更多优质的外链。

我已经阅读了 网站 的外部链接。除了签论坛,我还在家电维修论坛发了2~3篇稿子。大多数服务平台都有外部链接。除了存在对爬虫开放的渠道之外,过多的论坛签名很容易被百度搜索引擎惩罚,尽管百度没有明确声明不能作为论坛的外部链接。不过Zac内部权威的制造业SEO专家经常提到,论坛外链是一种垃圾外链,做的比较随意。建议:使用百度站长平台拒绝外链,拒绝低质量外链。

4.网络服务器稳定性问题:网站频繁宕机可能会伤害爬虫,无法爬取网站。

之所以做出这样的网站,是因为我坚信室内空间的成本是非常便宜的。应用的低成本模拟空间通常称为废弃的室内空间。

建议:使用网络监控报告网络监控下服务器空间的稳定性,检查网络服务器是否突然无法访问。

5.友联问题:新的网站导出连接不适合太多。

新的网站原来的权重值偏低,导出的链接太多,权重值变得更加分散。不建议在网站百度收录之前交流。由于 SEO 的意图,印记很重要。加入后不建议交换太多友情链接。新的网站的权重值天生就低,连接的网点太多,对方网站的名字权重值不高。并不是你自己的网址没有权重值。核心领域的具体指导方针太多了。