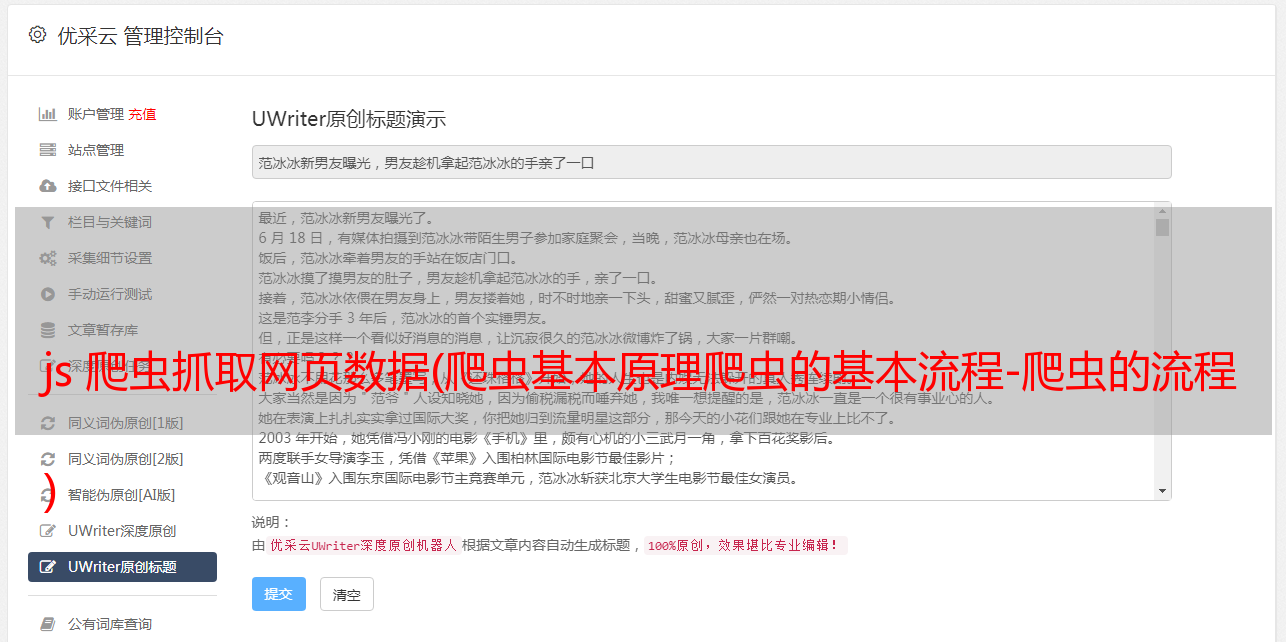

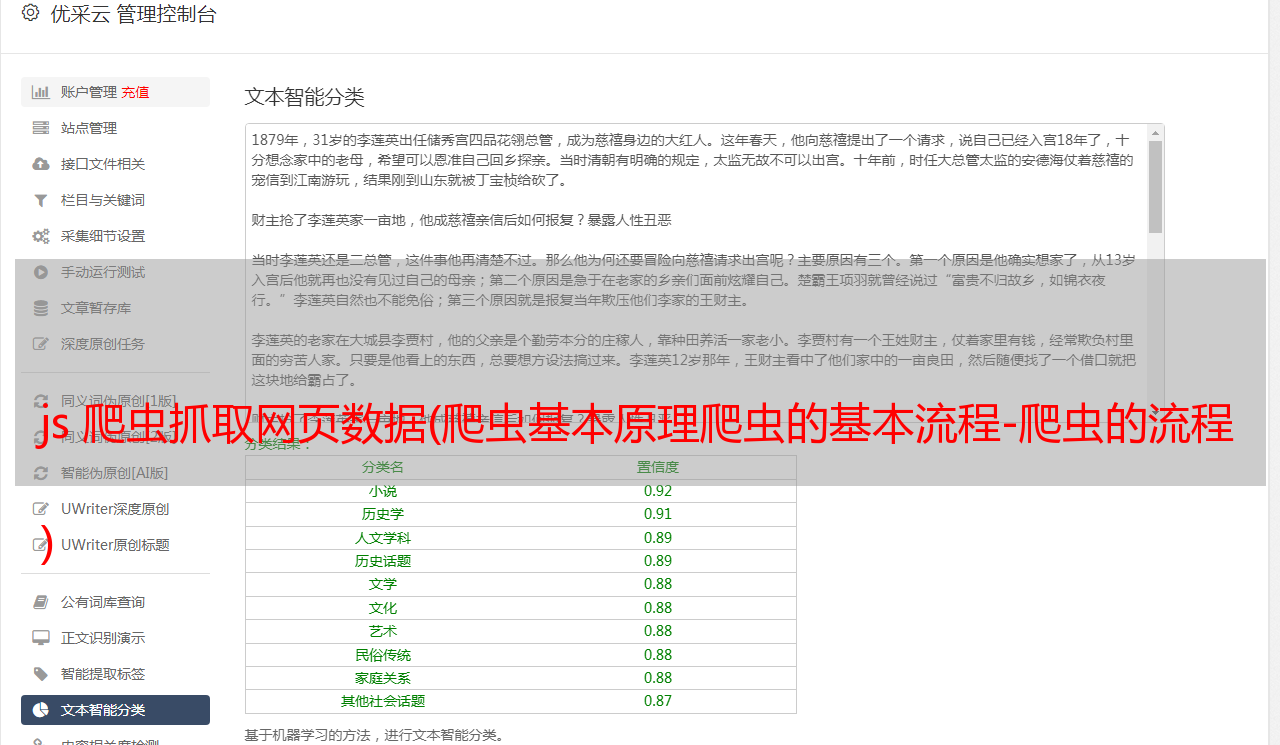

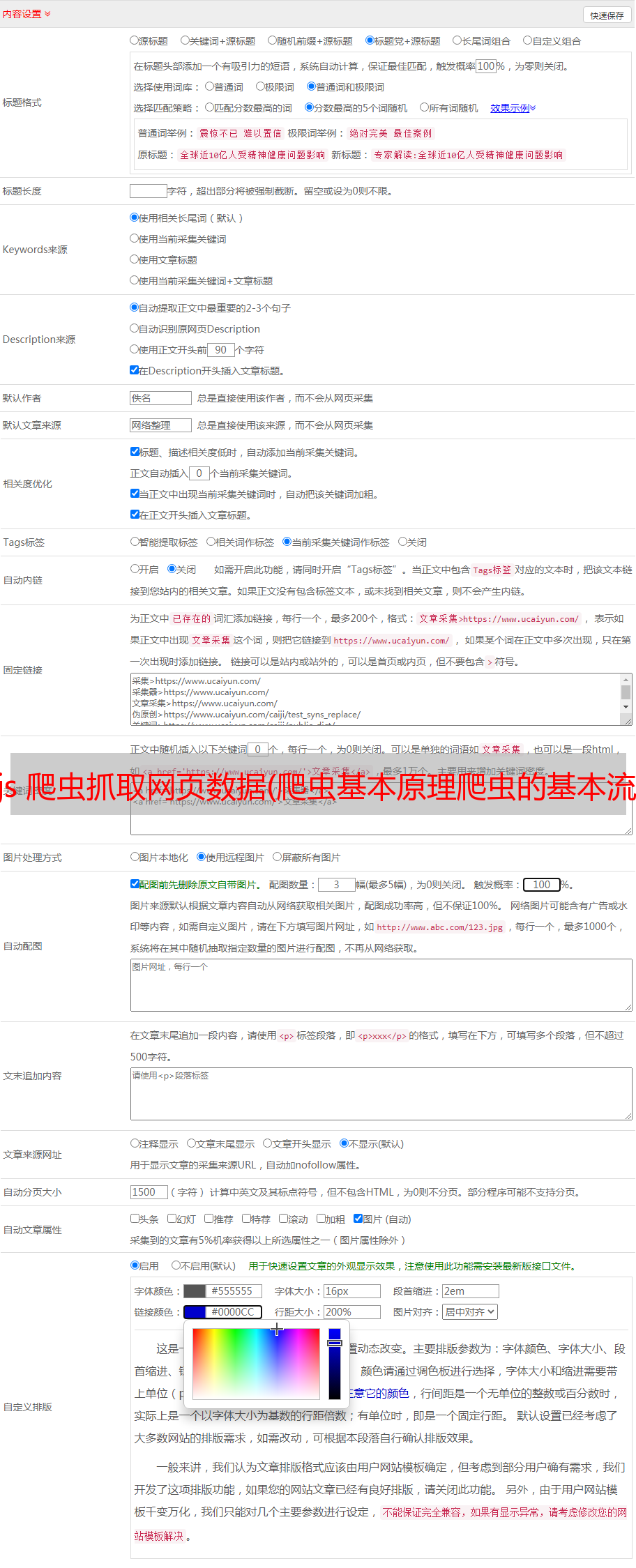

js 爬虫抓取网页数据(爬虫基本原理爬虫的基本流程-爬虫的流程 )

优采云 发布时间: 2021-11-07 00:13js 爬虫抓取网页数据(爬虫基本原理爬虫的基本流程-爬虫的流程

)

爬虫的基本原理

爬行的基本过程

1、获取网页源码:通过request库、urllib、requests等实现HTTP请求;

2、 提取信息:分析网页源代码,提取数据,如正则表达式、美汤、pyquery、Ixml等;

3、保存数据:保存到txt、json或数据库;

要捕获哪些数据

Javascript 渲染页面

使用 urllib 或 requests 获取网页时,获取的源代码与您在浏览器中看到的不同。

越来越多的网页使用ajax和前端模块化工具构建,整个网页都由Javascript渲染。需要分析ajax接口,或者使用selenium等库来模拟Javascript渲染。

【页面渲染】

页面渲染是浏览器的渲染引擎根据CSS定义的规则在浏览器窗口中显示HTML代码的过程。

一般工作原理如下:

饼干

Cookie 位于浏览器端。访问动态网页时,浏览器会自动附加并发送到服务器。服务器识别cookie并识别它是哪个用户,确定它是否登录,然后返回相应的响应。

爬虫代理

代理网络用户获取网络信息;

代理的作用:突破自身IP访问限制,访问群内资源,提高访问速度,隐藏真实IP;

爬虫代理可以获得更好的爬虫效果(防止被屏蔽或输入验证码登录);

检查robots.txt

Robots协议(也叫爬虫协议、机器人协议等)的全称是“机器人排除协议”(Robots Exclusion Protocol),网站告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取机器人协议选择。

搜索蜘蛛访问站点时,首先会检查站点根目录下是否存在robots.txt。如果存在,搜索机器人会根据文件内容确定访问范围;如果该文件不存在,所有 'S 搜索蜘蛛将能够访问 网站 上没有密码保护的所有页面。

爬行动物的攻击与防御