搜索引擎禁止的方式优化网站(一个网站不是所有的页面可以被搜索引擎收录吗?(图))

优采云 发布时间: 2021-11-04 04:19搜索引擎禁止的方式优化网站(一个网站不是所有的页面可以被搜索引擎收录吗?(图))

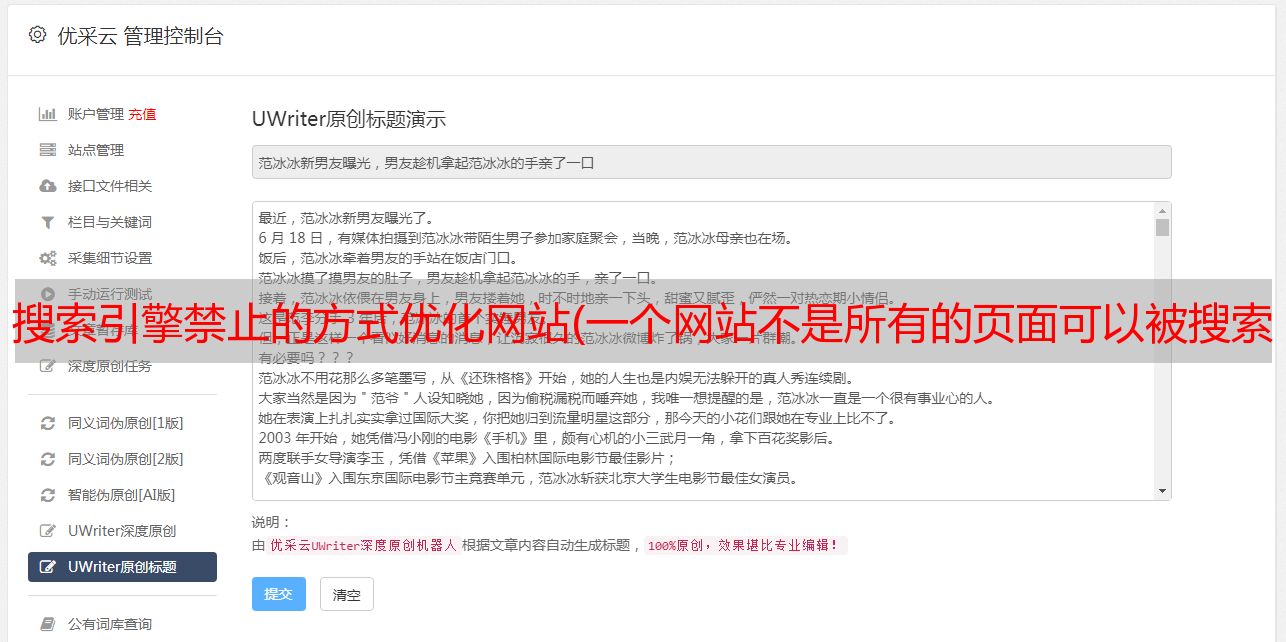

我们都知道,并不是网站的所有页面都可以被搜索引擎抓取。对于一些页面,怎么可能不被搜索引擎抓取,比如管理员后台的所有页面。不想要搜索引擎收录如何设置单页?

我们可以在 robots.txt 文件中这样写:

用户代理:*

不允许:/

禁止:/abc/dfgdw.html

复制代码

上面Disallow:/abc/dfgdw.html的意思是禁止所有搜索引擎抓取dfgdw.html页面,这样就可以直接在robots.txt文件中进行拦截。这种方法适用于无法修改的页面源代码,如果可以修改网页源代码,可以按照下面的方法进行屏蔽。

这是通常的写作方式。被禁止的是所有页面都不允许是收录,这显然是不好的,因为还有很多页面我们还想成为收录,搜索引擎是禁止抓取某个页面的也就是说单个页面要在meta标签中填写禁止语法,在网页的标签后添加一个标签,禁止该页面不允许搜索引擎收录,

使用元机器人标签

1. 用于指示搜索引擎禁止索引该页面的内容。

2. 语法说明:表示禁止所有搜索引擎索引本页,禁止访问本页链接。

noindex:告诉蜘蛛不要索引这个页面。

nofollow:告诉蜘蛛不要访问此页面上的链接。

nosnippet:告诉蜘蛛愤怒在搜索结果中显示说明文字。

noarchive:告诉搜索引擎不要显示快照。

noodp:告诉搜索引擎不要在打开的目录中使用标题和描述。

除了以上两种方法,还可以在服务器上进行屏蔽,但是对于普通新手朋友来说难度较大,因为服务器本身的操作和使用并不容易,方法是分析一段时间< @网站 日志,找到需要屏蔽的蜘蛛及其ip。然后通过服务器的配置文件进行拦截,从而阻止某个蜘蛛爬取网站。当然,这种方法使用起来并不灵活,例如不能单独阻止蜘蛛对某个文件夹(或网页)的抓取。

视服务器及其系统而定,具体请参考相关设置方法。