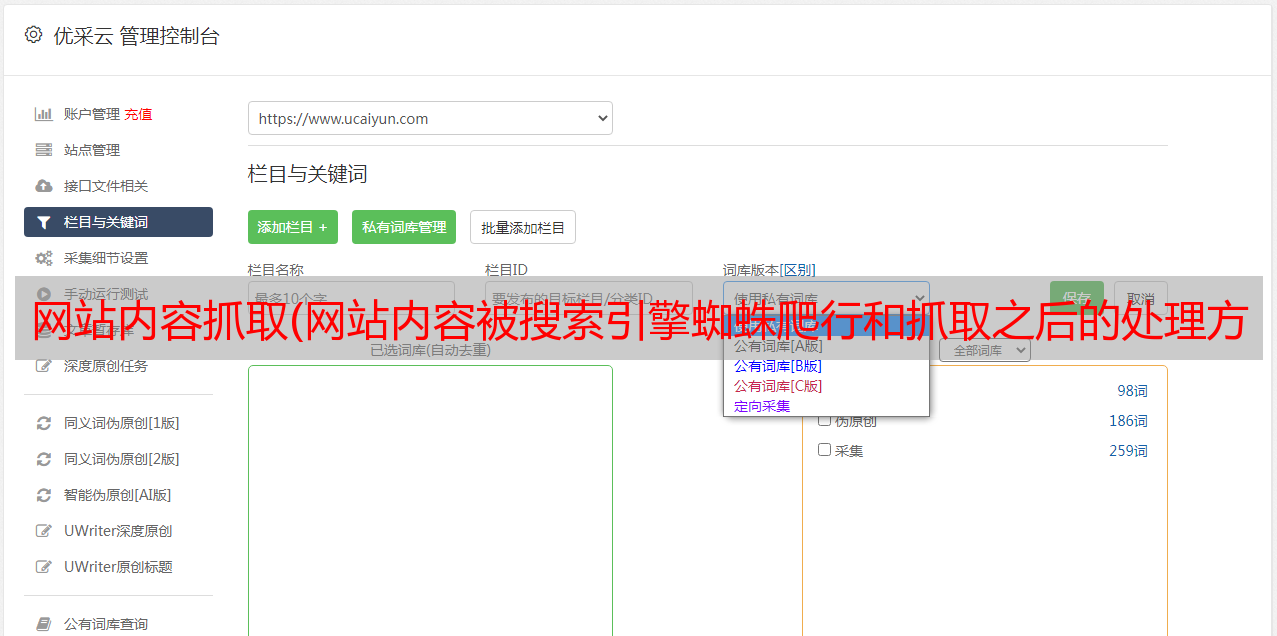

网站内容抓取(网站内容被搜索引擎蜘蛛爬行和抓取之后的处理方法有哪些)

优采云 发布时间: 2021-11-03 22:02网站内容抓取(网站内容被搜索引擎蜘蛛爬行和抓取之后的处理方法有哪些)

当网站的内容被搜索引擎蜘蛛抓取爬取时,网站抓取到的内容会被特殊过滤,称为索引。主要处理方法有文本提取和中文分词、停用词去除、去重、正向索引、倒排索引、链接关系计算等。

一、搜索引擎构建索引库的原理

一般来说,搜索引擎抓取的原创页面不直接参与排名和处理,因为搜索引擎数据库中有数千个内容。我们的用户输入一个关键词后,需要搜索引擎对相关页面进行排序,一一分析相关页面,不可能在几秒内回复,所以搜索引擎一般都会对抓取到的页面进行检查,建立对应的索引库,并为用户查询结果做前期工作。.

二、使用提取文本的方法,一一查看文本内容

目前,搜索引擎主要以文本内容为主。当蜘蛛爬取网站页面中的html代码时,用户不仅可以在浏览器上看到文字,还收录大量的html标签,java没有办法参与排名相关的内容如程式。因此,搜索引擎需要进行预处理,去除html文件中的标签和程序,提取出可以参与页面排名的文本内容。

三、使用中文分词处理文章段落问题

我们中文搜索引擎的特殊处理步骤是中文分词。由于中文单词之间没有分隔符,所以每个句子中的所有单词都连接在一起。我们的搜索引擎首先需要认识到这一点。几个字符组成一个词,这些词本身就是一个词或一个句子。其中,中文分词有两种方法,一种是词典匹配法,一种是统计法。

词典匹配法是指将一段待分析的文本与一段词典库中的现成词条进行匹配,然后在待分析的汉字中扫描词典中的词条,匹配成功.

相比较而言,统计方法的优势在于对新词的响应速度更快,便于消除每个词之间的歧义。事实上,搜索引擎的切分方法主要取决于词库的规模,而不管切分算法的好坏。作为seo从业者,你能做的就是提醒搜索引擎在页面上以特殊的方式做某条指令。例如,当某个词与某个词相关联或生成公司时,我们可以手动提示搜索引擎。

三、去除停用词,减少无关词的计算量

在网站页面上,总会有一些与内容无关但频繁出现的词。例如:感叹词如ah、、ha、副词如but、and,以及英语中常见的a、to等。这些词实际上对页面没有影响,是可选的。搜索引擎在建立索引数据库时需要去除这些停用词,以突出索引数据内容的主旨,减少对无关词的调查。

四、 消除杂音,清理页面主题

所谓网页杂音,并不是我们常见的杂音,而是网页上对网站没有任何使用价值的内容。比如版权热度、导航栏、广告等等,这些内容不仅会分割主题,还会影响网站的主题。因此,搜索引擎需要有意识地剔除不适当的噪音内容,以保证内容的清洁度。

五、使用前向索引组织网站权重信息

通过文本提取、中文分词、去噪等方式,此时一起搜索的你已经是一个特里个体,可以准确反映页面的主题,根据划分出来的分词,页面会转换成完成关键词组合,记录每个关键词出现在整个页面的频率,然后记录这些重要的识别信息。

六、使用倒排索引进行排名网站

网站的排名只能使用前向索引。实际上,搜索引擎会将正向索引数据库重置为倒排索引。这时候就认为整个索引数据库已经建立了。

简单来说,搜索引擎就是一个需要内容处理和索引的过程。只有多了解搜索引擎的爬取和爬取规则,做更多对用户有参考价值的内容,才能用好网站优化。