网页抓取数据百度百科(简单网络爬虫的工作流程简单的网络爬虫原理(组图))

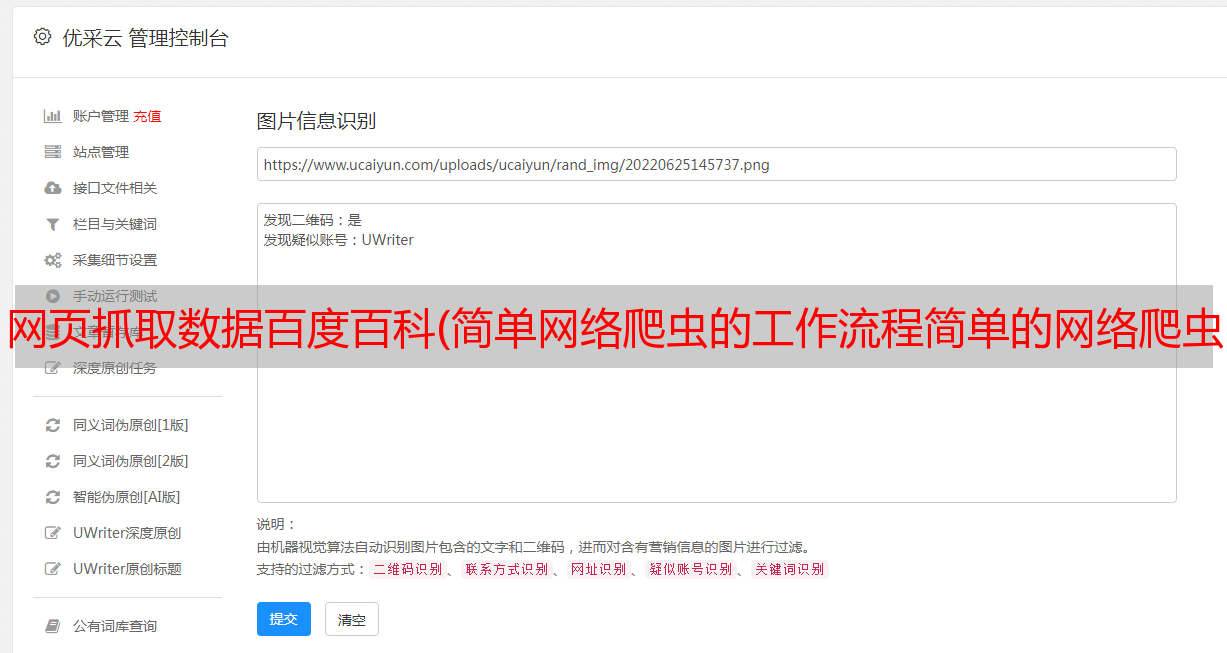

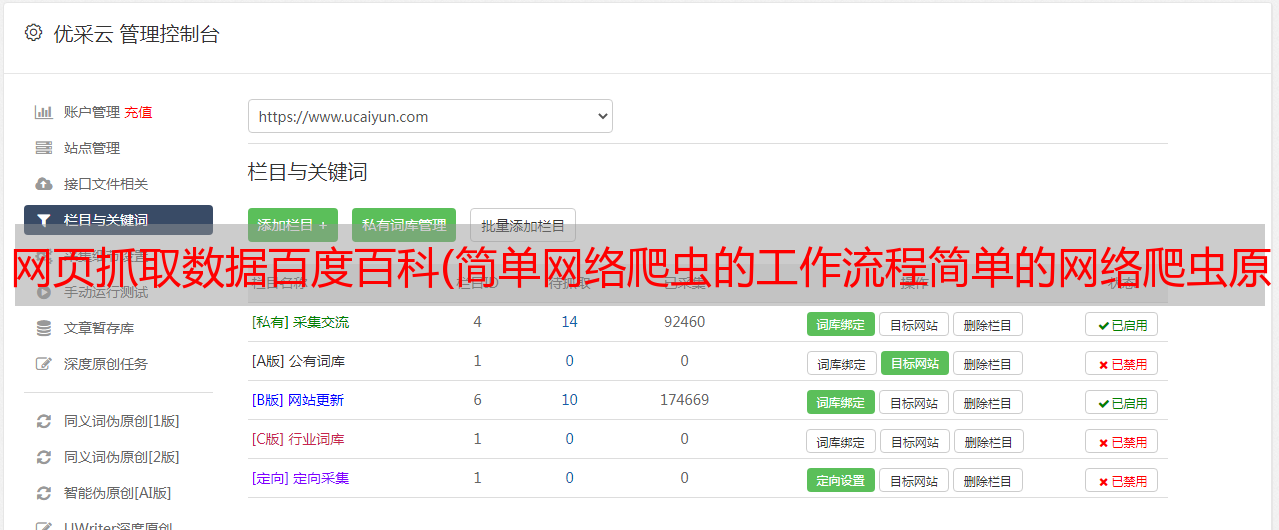

优采云 发布时间: 2021-11-03 02:06网页抓取数据百度百科(简单网络爬虫的工作流程简单的网络爬虫原理(组图))

什么是网络爬虫

简单的说,网络爬虫就是一个自动抓取互联网资源的程序。

简单的网络爬虫

网络爬虫的简单原理就是以特定的网址为*敏*感*词*,通过一定的规则获取网页上需要的信息和新的网址,并对新的网址进行爬取。

简单的网络爬虫架构

下图展示了一个简单的网络爬虫的主要架构。主要分为三个部分:url解析器、网页下载器、网页解析器。

pp1-简单爬虫架构.PNG

URL解析器:负责管理待爬取的URL集合和待爬取的URL集合。其中包括:防止重复爬行、防止循环爬行等。

网页下载器:下载已爬取到的url对应的网页,提供给网页解析器。

网页解析器:主要作用是获取下载的网页中的目标数据,然后生成新的url设置给url管理器。

一个简单的网络爬虫的工作流程

一个简单爬虫的运行过程.PNG

编写一个简单的网络爬虫

以百度百科python入口页面的超链接为例,代码使用python语言。

网址管理器

url manager 主要管理 url 集合。这里使用了python set()集合,因为set()中不存在相同的元素。

网页下载器

这里使用python的基本库urllib2.urlopen()方法下载网页url。

import urllib2

class HtmlDownloader(object):

def download(self,url):

if url is None:

return None

#直接请求

response = urllib2.urlopen(url)

#获取状态码,返回200代表下载成功

if response.getcode()!= 200:

return None;

return response.read()

网页解析器

这里使用的是 Python 库-BeautifulSoup。它的主要功能是从网页中获取数据,然后从获取的数据中找到目标数据并给url管理器一组新的新url。代码显示如下:

from bs4 import BeautifulSoup

import re

import urlparse

class HtmlParse(object):

#使用BeautifulSoup解析网页下载器下载的网页数据

def parse(self,page_url,html_cont):

if page_url is None or html_cont is None:

return

soup = BeautifulSoup(html_cont,'html.parser',from_encoding='utf8')

#获取新的url集合

new_urls = self._get_new_urls(page_url,soup)

#获取目标数据

new_data = self._get_new_data(page_url,soup)

return new_urls,new_data

#获取新的待爬取url

def _get_new_urls(self, page_url, soup):

new_urls = set()

#使用正则表达式从BeautifulSoup获取的数据中找到新的url

#页面的url格式/item/%E8%9C%98%E8%9B%9B/8135707

#这里的soup.find_all() 可获取全部符合条件的标签对象

links = soup.find_all('a',href =re.compile(r"/item/[%A_Z0_9]+"))

for link in links:

new_url = link['href']

#生成完整的的url:http://baike.baidu.com/item/%E8%9C%98%E8%9B%9B/8135707

new_full_url = urlparse.urljoin(page_url,new_url)

new_urls.add(new_full_url)

return new_urls

#获取目标数据,这里只是获取了标签和中的内容

def _get_new_data(self, page_url, soup):

res_data = {}

#url

res_data['url'] = page_url

#Python

#这里的soup.find() 将获取第一个符合条件的标签对象

title_node = soup.find('dd',class_="lemmaWgt-lemmaTitle-title").find("h1")

res_data["title"] = title_node.getText()

#

#这里的soup.find() 将获取第一个符合条件的标签对象

summary_node = soup.find("div",class_="lemma-summary")

res_data["summary"] = summary_node.getText()

return res_data

数据输出

这里只是将获取的数据输出到一个html文件中。当然,也可以输出到数据库、本地文件等其他地方,看具体需求。

class HtmlOutputer(object):

def __init__(self):

self.datas = []

def collect_data(self,data):

if data is None:

return

self.datas.append(data)

def output_html(self):

fout = open('output.html','w')

fout.write("")

fout.write("")

fout.write("")

#默认是ascii,为了防止中文乱码,需要转成utf8

for data in self.datas:

fout.write("")

fout.write("%s" % data['url'])

fout.write("%s" % data['title'].encode('utf8'))

fout.write("%s" % data['summary'].encode('utf8'))

fout.write("")

fout.write("")

fout.write("")

fout.write("")

最后,连接所有类:

#不要忘记引入其他类

from baike_py import html_downloader, html_outputer, html_parser

from baike_py import url_manager

class SpiderMain(object):

def __init__(self):

self.urls =url_manager.UrlManager()

self.downloader = html_downloader.HtmlDownloader()

self.parser = html_parser.HtmlParse()

self.outputer = html_outputer.HtmlOutputer()

def craw(self, root_url):

count = 1

self.urls.add_new_url(root_url)

while self.urls.has_new_url():

try:

new_url = self.urls.get_new_url()

print ("craw %d : %s" % (count,new_url))

html_cont = self.downloader.download(new_url)

new_urls,new_data = self.parser.parse(new_url,html_cont)

self.urls.add_new_urls(new_urls)

self.outputer.collect_data(new_data)

#这里只是抓取了1000条url数据

if count == 1000:

break

count = count + 1

except :

print (“craw failed”)

self.outputer.output_html()

if __name__=="__main__":

root_url = "http://baike.baidu.com/item/Python"

obj_spider = SpiderMain()

obj_spider.craw(root_url)

总结