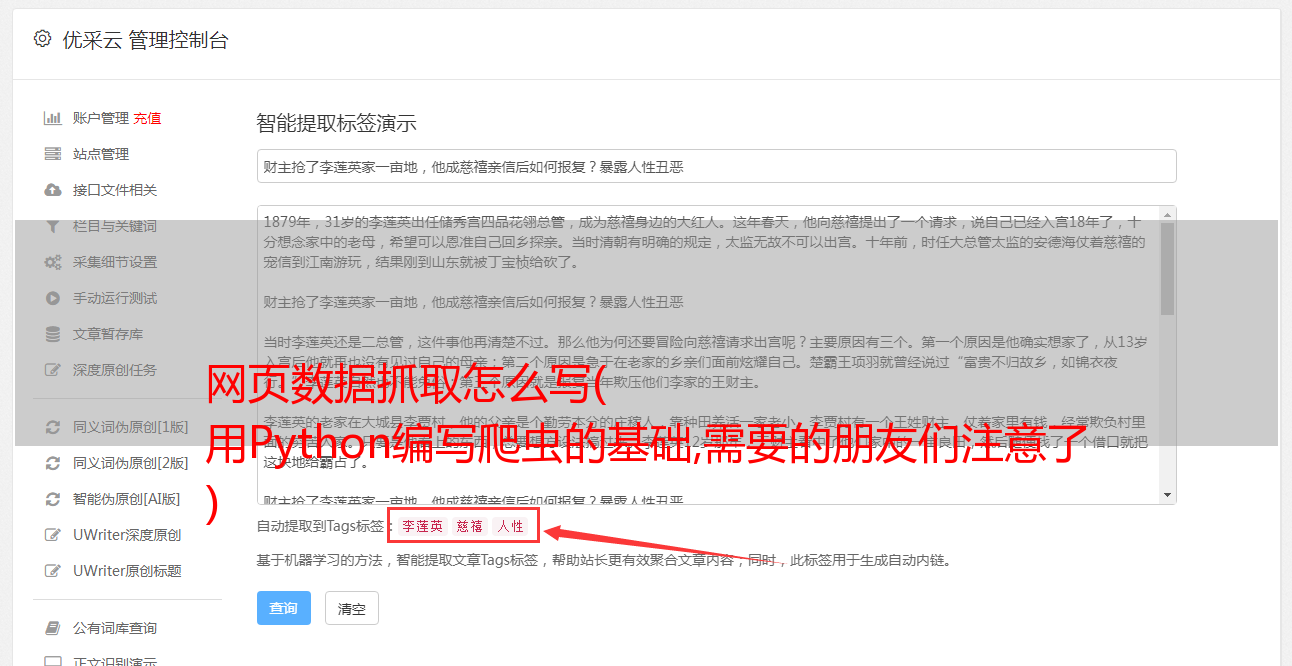

网页数据抓取怎么写( 用Python编写爬虫的基础,需要的朋友们注意了 )

优采云 发布时间: 2021-10-28 10:15网页数据抓取怎么写(

用Python编写爬虫的基础,需要的朋友们注意了

)

一个用Python程序抓取网页HTML信息的小例子

更新时间:2015-05-02 15:02:49 作者:cyqian

本文文章主要介绍一个用Python程序爬取网页HTML信息的小例子。使用的方法也是用Python编写爬虫的基础。有需要的朋友可以参考

抓取网页数据的思路有很多,一般有:直接代码请求http、模拟浏览器请求数据(一般需要登录验证)、控制浏览器实现数据抓取等,本文不考虑复杂的情况,放一个小例子读取简单网页数据:

目标数据

将此页面上所有这些玩家的超链接保存在 ittf网站 上。

数据请求

我真的很喜欢符合人类思维的库,比如请求。如果想直接获取网页的文字,可以一言为定:

doc = requests.get(url).text

解析html获取数据

以beautifulsoup为例,它包括获取标签、链接、按照html层次遍历等方法。请参阅此处以供参考。以下代码段从 ittf网站 获取到指定页面上指定位置的链接。

url = 'http://www.ittf.com/ittf_ranking/WR_Table_3_A2.asp?Age_category_1=&Age_category_2=&Age_category_3=&Age_category_4=&Age_category_5=&Category=100W&Cont=&Country=&Gender=W&Month1=4&Year1=2015&s_Player_Name=&Formv_WR_Table_3_Page='+str(page)

doc = requests.get(url).text

soup = BeautifulSoup(doc)

atags = soup.find_all('a')

rank_link_pre = 'http://www.ittf.com/ittf_ranking/'

mlfile = open(linkfile,'a')

for atag in atags:

#print atag

if atag!=None and atag.get('href') != None:

if "WR_Table_3_A2_Details.asp" in atag['href']:

link = rank_link_pre + atag['href']

links.append(link)

mlfile.write(link+'\n')

print 'fetch link: '+link

mlfile.close()