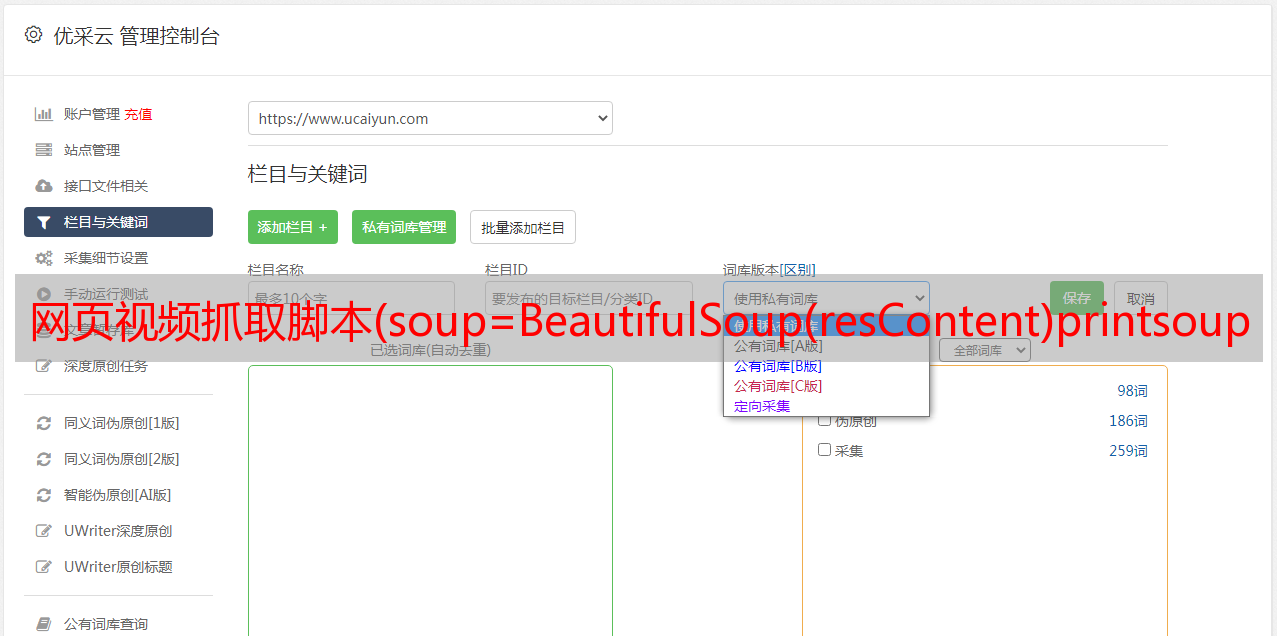

网页视频抓取脚本(soup=BeautifulSoup(resContent)printsoupsoup()本地)

优采云 发布时间: 2021-10-27 18:01网页视频抓取脚本(soup=BeautifulSoup(resContent)printsoupsoup()本地)

这取决于您是捕捉静态还是动态。下面是静态表信息的代码:

from BeautifulSoup import BeautifulSoup import urllib2 import re import string defearse(strline,ch) :left = 0right = strline.find(ch)while right !=-1 :strline = strline.replace(ch,'')right = strline.find(ch)return strline url = r"" resContent = urllib2.urlopen(url).read() resContent = resContent.decode('gb18030').encode('utf8') 汤 = BeautifulSoup (resContent) 打印汤('title')[0].string tab = soup.findAll('table') trs = tab[len(tab)-1].findAll('tr') for trIter in trs :tds = trIter.findAll('td')for tdIter in tds :span = tdIter('span')for i in range(len(span)) :if span[i].string :printearse(span[i].string, '').strip(),else :passprint

使用的python的request和csv模块

import requesimport reimport csv_re = requests.get(url)re_text = re.findall(str, _re.text, re.S) # str 正则 with open('1.csv','wb') as f: csv.writer(f).writerow(re_text)

本地网页?

如果是一般的网页,表格是csv格式或者txt格式,可以使用pandas包来读取,例如:如果是csv格式,就这样写:

将熊猫导入为 pd

df = pd.read_csv('http:\......')#表所在的URL

df#显示表格数据

如果是txt格式,直接用read_table替换read_csv即可。

Python 是一种使用非常广泛的脚本语言。 Google 的网页是用 python 编写的。 Python在生物信息学、统计学、网页制作、计算等诸多领域都展示了强大的功能。 Python和java、R、Perl等其他脚本语言可以直接在命令行上运行脚本。工具/材料

蟒蛇; CMD命令行;视窗操作系统

方法/步骤

1、首先下载安装python,建议安装2.7版本及以上,3.0版本以下,因为3.0版本及以上不向下兼容,体验较差。

2、打开文本编辑器,推荐editplus、notepad等,文件保存为.py格式,editplus和notepad支持python语法识别。

脚本的第一行一定要写#!usr/bin/python

表示脚本文件是一个可执行的python脚本

如果python目录不在usr/bin目录下,替换为当前python执行程序的目录。

3、 写好脚本后注意调试,可以直接用editplus调试。调试方法可以百度。脚本写好后,打开CMD命令行,前提是python已经添加到环境变量中,如果还没有添加到环境变量中,请自行百度

4、在CMD命令行输入“python”+“空格”,即“python”;将已经写入的脚本文件拖到当前光标位置,然后回车运行。

使用beautifulsoup4

resp = urllib.request.urlopen(yoururl).read().decode("utf-8")

soup = bs4.Beautifulsoup(resp)

soup.findall("table", {"width": "550"})[0]

那就做你想做的吧。不懂语言,可以直接在某宝中找到楚江数据,可以代写爬虫,也可以直接让他们爬取数据。

如何使用Python爬虫抓取网页内容? -

------ 首先你要安装requests和BeautifulSoup4,然后执行下面的代码。 62232425262728293031323334 importrequests frombs4 importBeautifulSoup iurl ='

求教如何通过python抓取网页中的表格信息

------ 手头没有现成的代码,就不贴了。告诉你思路:虽然URL中的地址都一样,但实际上是不同的。需要f12来分析后台代码;那么有两种方式, 1. 就是f12解析代码后爬取真实地址; 2. 使用py模拟输入“下一页”。具体代码不麻烦,度娘好找。

如何使用python抓取网页的特定内容-

------ 最简单的使用urllib的方法,python2.x和python3.x的用法不同,以python2.x为例:import urllib html = urllib .open(url) text = html.read() 复杂的可以使用requests库,支持各种请求类型,支持cookies、headers等,复杂的可以使用selenium,支持抓取文本由javascript生成

如何用python抓取网页内容-

------ 给你一个简单的抓取百度页面的爬虫案例代码,自己测试一下:#coding=utf-8import urllib2def postu(url): header = {”User-Agent ": "Mozilla/ 5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52. 0. 2743....

如何用python爬取网页-

------ #coding=utf-8 import urllib import re#*敏*感*词*URL:#根据URL获取网页的HTML内容 def getHtmlContent(url): page = urllib. urlopen(url) return page.read()#从HTML解析所有jpg图片的URL# jpg来自HTML...

如何使用python抓取简单的网页-

------推荐:《pyspider爬虫教程(二):ajax和http》-ajax因为ajax实际上是通过http传输数据的,所以我们可以用chrome开发者工具找到真正的请求,直接发起对真实请求的爬取获取数据,ajax一般通过xmlhttprequest对象接口发送请求,xmlhttprequest一般简写为xhr。

如何使用python抓取网页并实现一些提交操作? -

------ 下面的程序是一个抓取网页的例子。 MyOpener 类是模拟浏览器客户端,使用随机选择的方式来防止网站 把你当机器人。 MyFunc 函数抓取你指定的 url 并提取其中的 href 链接。图像采集类似,一般

比如...

如何使用python抓取网页并实现一些提交操作?

------ 这个,可以百度:python爬虫入门。然后会有一些视频或者在线教程,教你如何抓取网页数据并使用post方式提交操作

如何使用python抓取网页数据

------ 这个需要借用网站的api,自己找,可以用模块解析网页自己抓取

如何使用python抓取国外网站 -

------ 网页抓取是提取网络数据的过程。借助合适的工具,您可以提取任何您能看到的数据。在本文中,我们将重点介绍自动提取过程的程序,以帮助您在短时间内采集大量数据。除了作者提到的用例,爬虫技术的用途还包括:SEO跟踪、职位跟踪、新闻分析,以及作者最喜欢的社交媒体情感分析!