网页数据抓取怎么写(爬一个网页的div标签怎么设计?findfindlist)

优采云 发布时间: 2021-10-25 17:11网页数据抓取怎么写(爬一个网页的div标签怎么设计?findfindlist)

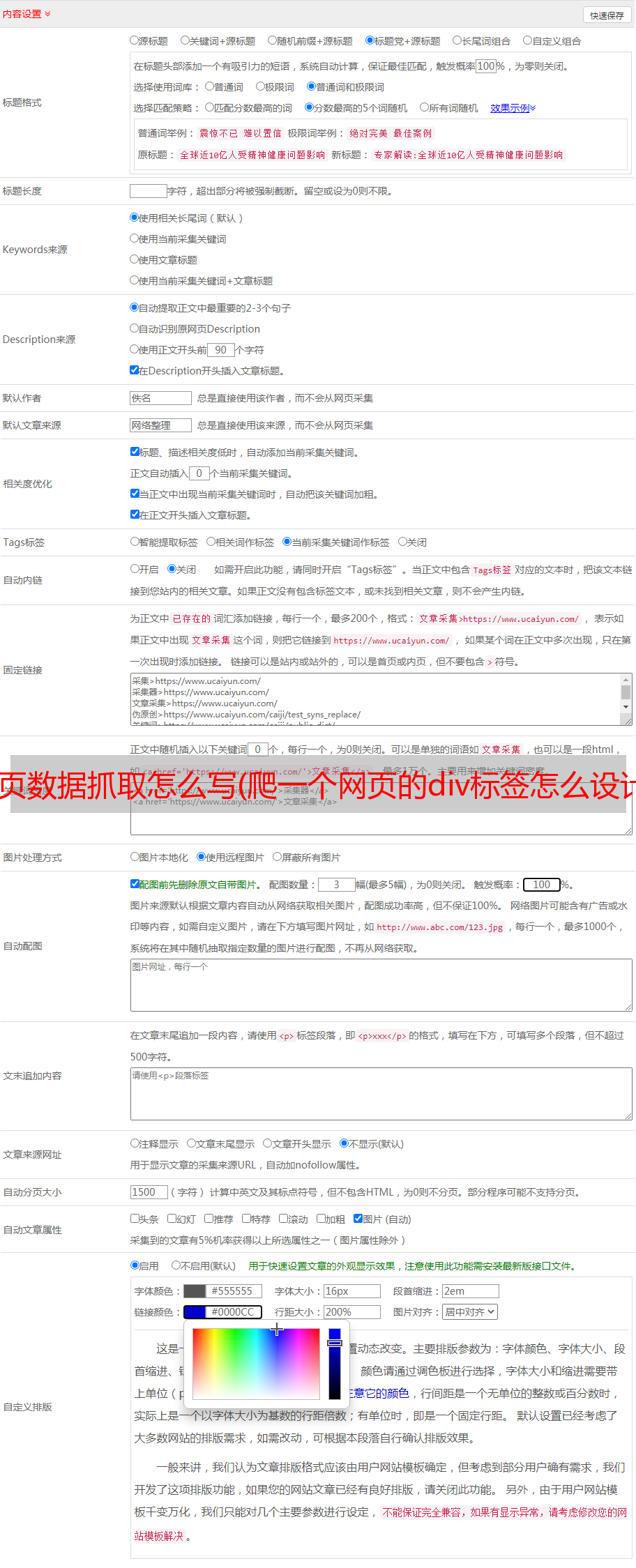

每个 div 都会有一个带有 a 的 h2,并且 a 收录我们想要的标题名称。所以我们使用 find_all 来查找所有这样的 div 标签,将它们存储为一个列表,然后遍历列表,为每个元素提取 h2 a,然后提取标签中的内容。

当然,我们也可以在_all中找到最外层的li标签,然后再往里看,都是一样的。只需找到定位信息的唯一标识(标签或属性)即可。

虽然看这里的源码可以折叠一些无用的代码,但其实有一些更好的工具可以帮助我们在网页的源码中找到我们想要的信息的位置。例如,下面的鼠标符号。

当所有的代码都折叠好后,点击这个鼠标,然后点击网页中的元素,浏览器会自动选择你点击的元素,其实当你悬停在一个元素上时,已经帮你定位了,如图以下

总结

当我们要爬取一个网页时,我们只需要如下过程

现在,对于一些没有丝毫防爬措施的网站,我们都可以做得很好。至于如何将多个字段的数据组织在一起,如何设计爬取多个页面的代码(在常规URL的情况下),不是爬虫知识的范围,有了python的基础知识就可以解决。下一个系列文章将重点介绍这部分。接下来给大家介绍几个目前可以练的网站

如果你在使用BeautifulSoup定位的过程中遇到困难,可以直接上网搜索教程,也可以等待BeautifulSoup的详细介绍,后面会更新我们的话题。

如果你去抢其他网站,最好看看r.text是否和网站的源码完全一样。如果不是,说明你对方的服务器没有给你真实的信息,说明它可能看到你是爬虫(做网页请求的时候,浏览器和requests.get都相当于敲门了)一堆资质证书,对方会查你的资质证书,浏览器资质证书一般都可以,而且代码资质证书可能不合格,因为代码资质证书可能有一些相对固定的特征,并且对方的服务器是预先设置好的,拒绝*敏*感*词*书的请求,因为他们肯定是爬虫。这是反爬虫。机制)。这时候就需要了解一些防爬的措施,才能获得真实的信息。防爬方法的学习是一个积累的过程,后面会讲到。读者如果遇到一些反爬虫机制,可以上网查一下这个网站爬虫。估计能找到一些破解方法的博客,甚至直接贴上代码。

python学习交流群:125240963

转载至:爬虫基本原理