爬虫抓取网页数据(网络爬虫软件都有哪些比较知名的工具,Mark!)

优采云 发布时间: 2021-10-25 05:04爬虫抓取网页数据(网络爬虫软件都有哪些比较知名的工具,Mark!)

目前市场上有几家数据抓取公司,每家公司都有自己的百度爬虫特点。

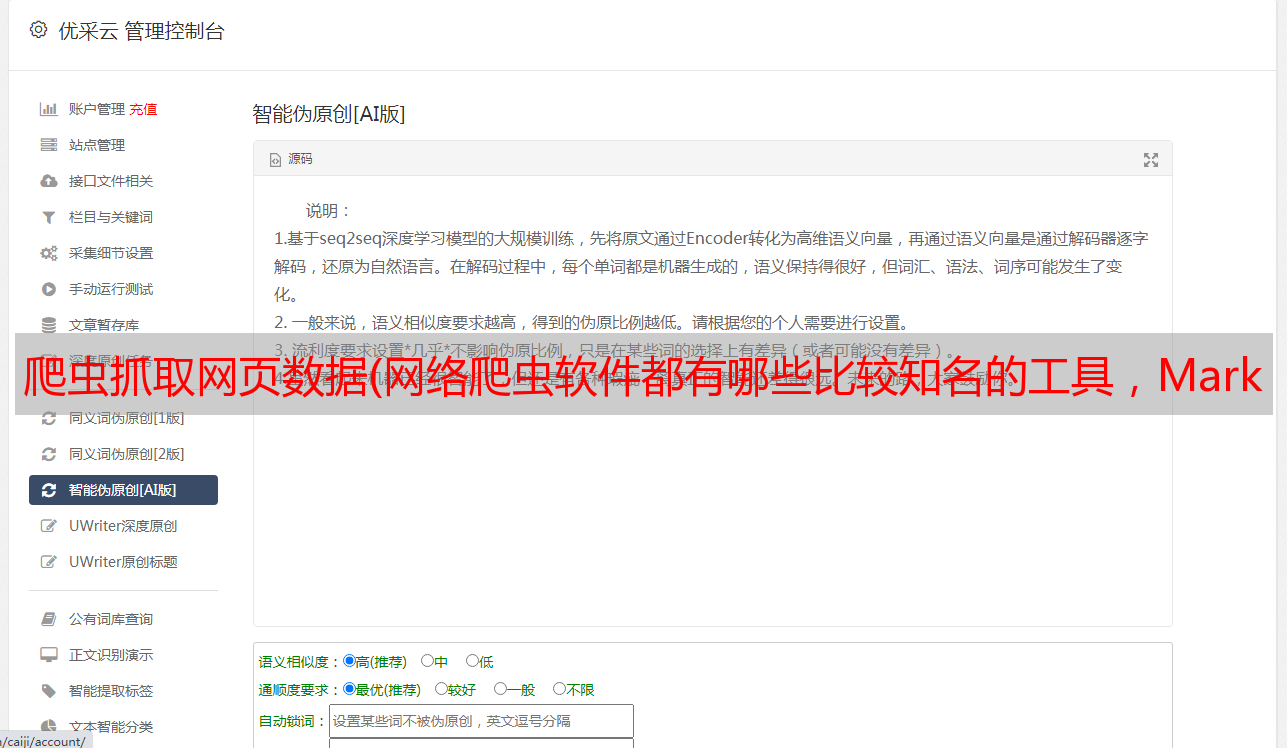

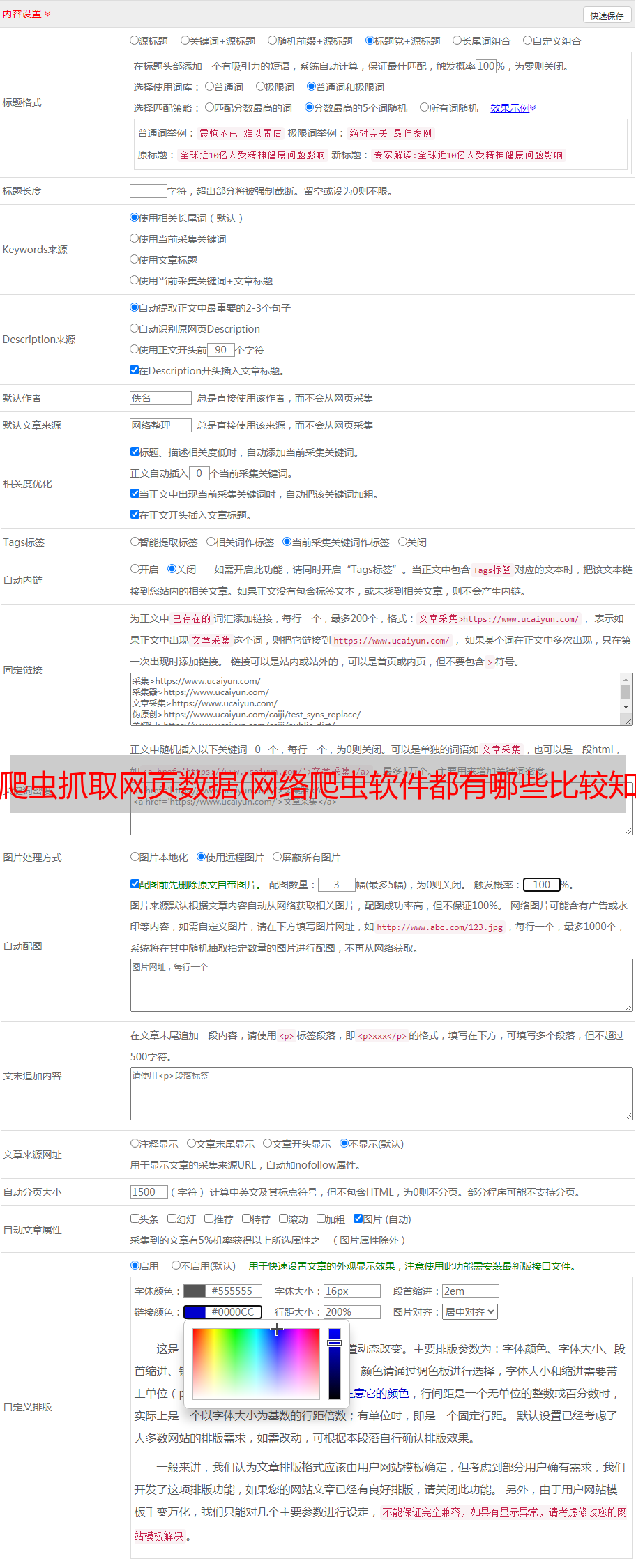

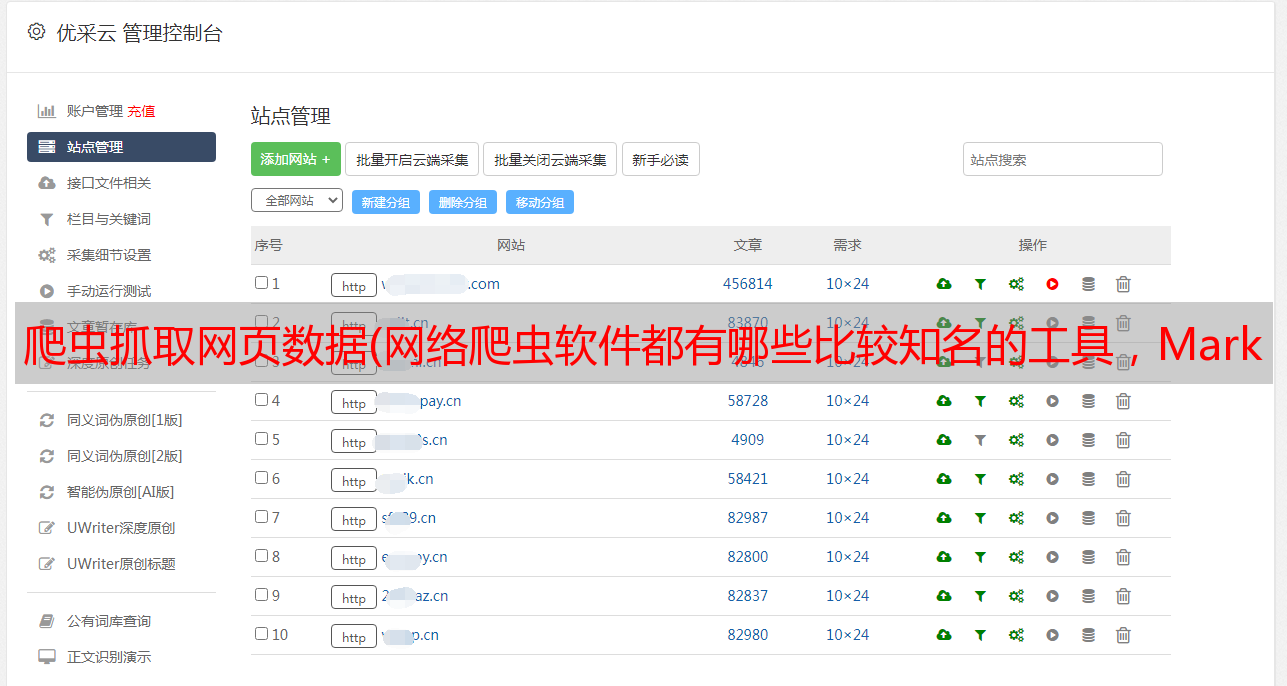

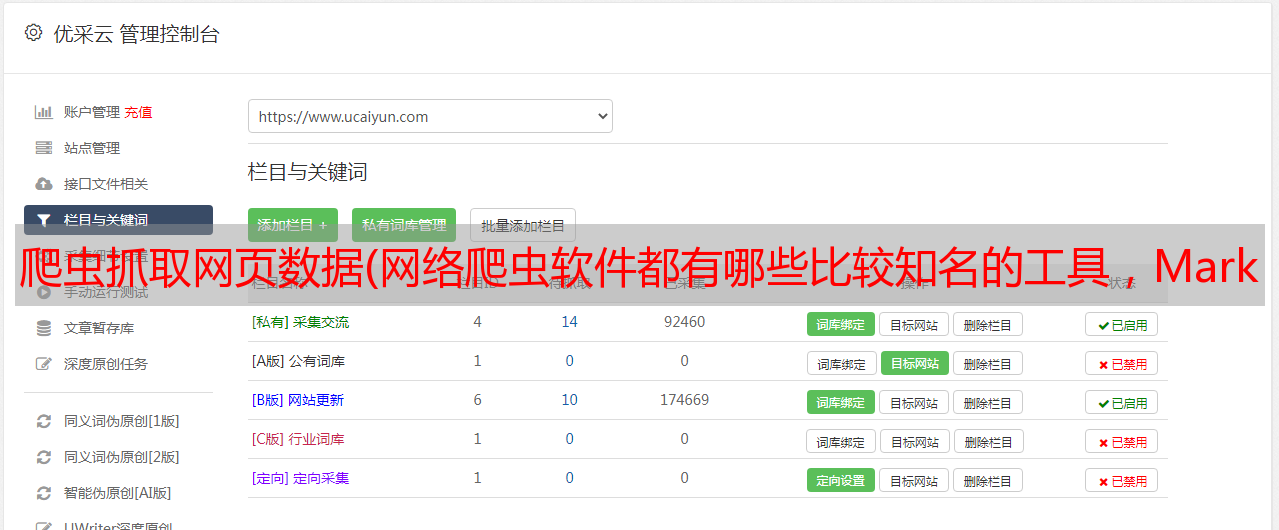

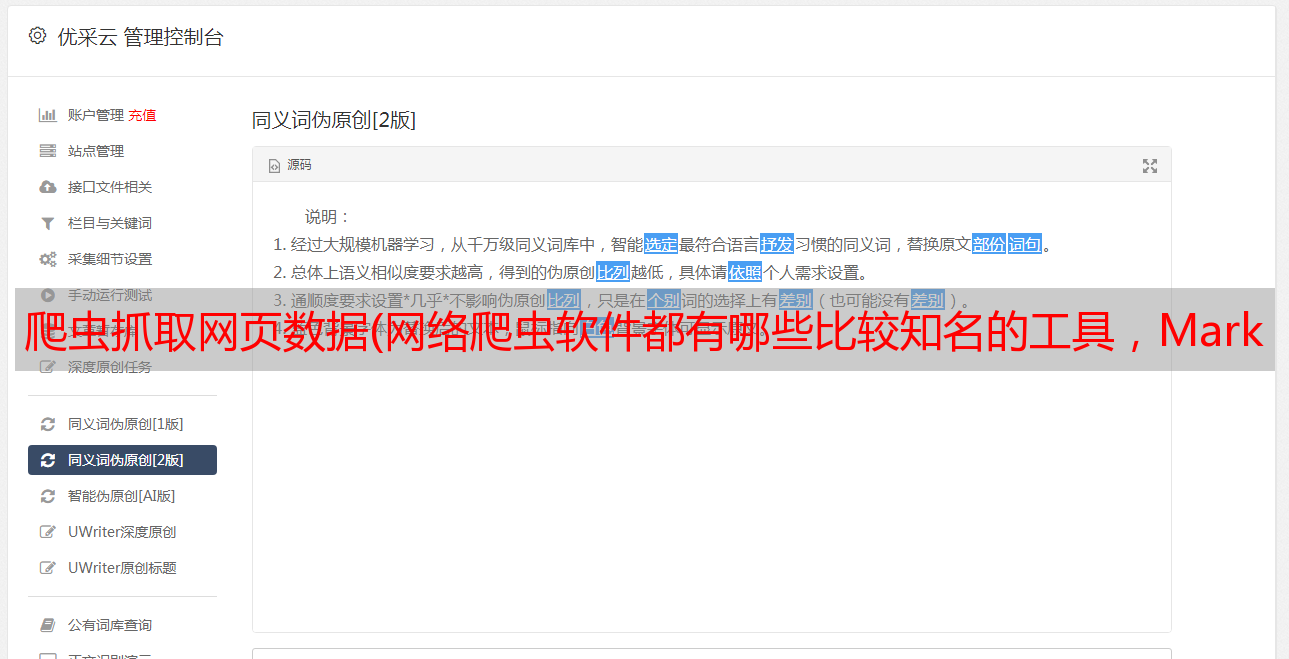

1.优采云:可视化采集百度爬虫,一些比较简单的采集工作基本可以实现,但是对于一些比较难的采集,脚本什么的都需要学写,客服不及时,可能是因为市场份额比较大。

2.前嗅:成立15年,也是视觉运营。不用说,简单的爬取就可以让他们代为爬,也可以直接买模板自己爬,或者让他们代为爬。他们代写脚本,相对小众,但解决了百度爬虫的问题。

3.优采云:爬虫界的大哥,不过对应的就没那么灵活了。现在人不是很多。

比较知名的网络爬虫软件有哪些?

排名前 20 的网络爬虫工具,马克!

网络爬虫广泛应用于许多领域。它的目标是从 网站 获取新数据并将其存储以便于访问。网络爬虫工具越来越为人们所熟悉,因为它们可以简化和自动化整个爬虫过程,让每个人都可以轻松访问网络数据资源。1. Octoparse

Octoparse 是一款免费且功能强大的 网站 爬虫工具,用于从 网站 中提取所需的各种类型的数据。它有两种学习模式——向导模式和高级模式,所以非程序员也可以使用它。您可以下载网站的几乎所有内容,并以EXCEL、TXT、HTML或数据库等结构化格式保存。通过定时云抽取功能,您可以获得网站的最新信息。提供IP代理服务器,不用担心被攻击性的网站检测到。

总之,Octoparse 应该可以满足用户最基本或者高端的爬虫需求,不需要任何编码技能。

2. Cyotek WebCopy

WebCopy 是一款免费的网站 爬虫工具,允许将部分或完整的网站 内容本地复制到硬盘上以供离线阅读。它在将网站的内容下载到硬盘之前扫描指定的网站,并自动重新映射网站中的图像和其他网络资源的链接以匹配它们的本地路径。还有其他功能,例如下载副本中收录的 URL,但不抓取它。您还可以配置域名、用户代理字符串、默认文档等。

但是,WebCopy 不包括虚拟 DOM 或 JavaScript 解析。

3. HTTrack

作为一款网站爬虫免费软件,HTTrack提供的功能非常适合将整个网站从网上下载到PC上。它提供了适用于 Windows、Linux、Sun Solaris 和其他 Unix 系统的版本。它可以镜像一个或多个站点(共享链接)。在“设置”下决定下载网页时同时打开的连接数。您可以从整个目录中获取照片、文件、HTML 代码,更新当前镜像 网站 并恢复中断的下载。

此外,HTTTrack 提供代理支持以最大限度地提高速度并提供可选的身份验证。

4. 左转

Getleft 是一款免费且易于使用的 网站 爬虫工具。启动Getleft后,输入网址,选择要下载的文件,然后开始下载网站 另外,提供多语言支持,目前Getleft支持14种语言。但是,它只提供有限的 Ftp 支持,它可以下载文件但不能递归。

总的来说,Getleft 应该能满足用户基本的爬虫需求,不需要更复杂的技能。

5. 刮板

Scraper 是一款 Chrome 扩展工具,数据提取功能有限,但对于在线研究和导出数据到 Google 电子表格非常有用。适合初学者和专家,您可以轻松地将数据复制到剪贴板或使用 OAuth 将其存储在电子表格中。不提供包罗万象的爬虫服务,但对新手也很友好。

6. OutWit 中心

OutWit Hub 是一个 Firefox 插件,具有数十种数据提取功能,可简化网络搜索。浏览页面后,提取的信息会以合适的格式存储。您还可以创建自动代理来提取数据并根据设置对其进行格式化。

它是最简单的网络爬虫工具之一,可以自由使用,提供方便的网页数据提取,无需编写代码。

7. ParseHub

Parsehub 是一款优秀的爬虫工具,支持使用 AJAX 技术、JavaScript、cookies 等方式获取网页数据。其机器学习技术可以读取、分析网络文档并将其转换为相关数据。Parsehub 的桌面应用程序支持 Windows、Mac OS X 和 Linux 等系统,您也可以使用浏览器内置的 Web 应用程序。

8.视觉抓取工具

VisualScraper 是另一个很棒的免费和非编码爬虫工具,它通过一个简单的点击界面从互联网上采集数据。您可以从多个网页获取实时数据,并将提取的数据导出为 CSV、XML、JSON 或 SQL 文件。除了SaaS,VisualScraper还提供网页抓取服务,例如数据传输服务和创作软件提取服务。

Visual Scraper 使用户能够在特定时间运行他们的项目,也可以使用它来获取新闻。

9. Scrapinghub

Scrapinghub 是一种基于云的数据提取工具,可以帮助成千上万的开发人员获取有价值的数据。其开源的可视化爬虫工具允许用户在没有任何编程知识的情况下爬取网站。

Scrapinghub 使用 Crawlera,一个智能代理微调器,支持绕过 bot 机制,轻松抓取大量受 bot 保护的 网站。它使用户能够通过简单的}

10. Dexi.io

作为基于浏览器的爬虫工具,}

11. Webhose.io

}

捕获的数据可以以 XML、JSON 和 RSS 格式保存,并且可以从其存档中访问历史数据。还,}

12.导入。io

用户只需要从特定网页导入数据,并将数据导出为CSV,即可形成自己的数据集。

无需编写任何代码,您可以在几分钟内轻松抓取数千个网页,并根据您的需求构建 1,000 多个 API。公共 API 提供强大而灵活的功能以编程控制}

为了更好地满足用户的爬取需求,它还提供了Windows、Mac OS X和Linux的免费应用程序来构建数据提取器和爬取工具,下载数据并与在线帐户同步。此外,用户可以每周/每天/每小时安排爬虫任务。

13.80条腿

80legs是一款功能强大的网络爬虫工具,可根据客户需求进行配置。80legs 提供了一个高性能的网络爬虫,可以快速工作,在几秒钟内获取所需的数据。

14. Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 中获取所有数据。Spinn3r 发布了一个防火墙 API 来管理 95% 的索引工作。提供先进的垃圾邮件防护功能,杜绝垃圾邮件和不当语言,提高数据安全性。

Spinn3r 索引类似于 Google 的内容,并将提取的数据保存在 JSON 文件中。

15. 内容抓取器

Content Graber 是一款针对企业的爬虫软件。它允许您创建一个独立的网络爬虫代理。

它更适合具有高级编程技能的人,因为它为有需要的人提供了许多强大的脚本编辑和调试接口。允许用户使用 C# 或}

16. 氦气刮刀

Helium Scraper是一款可视化的网络数据爬取软件,当元素之间的相关性较小时效果更好。它是非编码和非配置的。用户可以根据各种爬取需求访问在线模板。

基本可以满足用户初期的爬取需求。

17. UiPath

UiPath 是一款免费的自动爬虫软件。它可以自动从第三方应用程序抓取网页和桌面数据。Uipath 可以跨多个网页提取表格数据。

Uipath 提供了用于进一步爬行的内置工具。这种方法在处理复杂的 UI 时非常有效。屏幕抓取工具可以处理单个文本元素、文本组和文本块。

18. 刮擦。它

Scrape.it 是一种基于云的 Web 数据提取工具。它是为具有高级编程技能的人设计的,因为它提供了公共和私有包来发现、使用、更新和与全球数百万开发人员共享代码。其强大的集成功能可以帮助用户根据自己的需求构建自定义爬虫。

19. 网络哈维

WebHarvy 是为非程序员设计的。它可以自动抓取来自网站的文本、图片、URL和电子邮件,并将抓取到的内容以各种格式保存。它还提供了内置的调度程序和代理支持,可以匿名爬行并防止被 Web 服务器阻止。可以选择通过代理服务器或VPN访问目标。网站。

当前版本的 WebHarvy Web Scraper 允许用户将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件,或导出到 SQL 数据库。

20. 内涵

Connotate 是一款自动化的网络爬虫软件,专为企业级网络爬虫设计,需要企业级解决方案。业务用户无需任何编程即可在几分钟内轻松创建提取代理。

它可以自动提取95%以上的网站,包括基于JavaScript的动态网站技术,如Ajax。

此外,Connotate 还提供了网页和数据库内容的集成功能,包括从 SQL 数据库和 MongoDB 数据库中提取的内容。