seo网站日志分析工具(怎么进行网站日志分析?网站分析的步骤?(图))

优采云 发布时间: 2021-10-19 01:18seo网站日志分析工具(怎么进行网站日志分析?网站分析的步骤?(图))

对于一个已经入门的SEO,可能会听到网站日志分析,比如之前的编辑。以前总觉得只要认真更新网站的原创的内容,做好外链、内链、nofollow。至于网站的日志,我看网站日志究竟如何帮我优化网站?本来每天都有很多优化工作,实在没时间和精力做网站日志分析。直到有一天,我第一次尝到了网站的日志,分析了这颗禁果后,发现它的神奇功效非同凡响,它能给SEOer带来的各种信息尤为重要。

什么是 网站 日志?

网站Log 是一个以·log 结尾的文件,它记录了Web 服务器接收到的各种原创信息,例如处理请求和运行时错误。准确的说应该是服务器日志。网站 日志最大的意义就是记录网站在空间的操作、请求访问的记录等操作中的操作。通过网站的日志,你可以清楚的知道你的网站的哪个页面,用户是否访问过什么IP,什么时间,什么操作系统,什么浏览器,什么分辨率的显示器。成功。

如果没有网站日志分析这么重要的工具,优化一个网站就会很被动。您不知道您的 网站 是否有任何蜘蛛或搜索引擎爬虫。你网站每天都抢了哪些页面,在你的网站呆了多久。而通过这些基础的、重要的数据,网站的优化工作会变得更加客观。

如何进行网站日志分析?网站 日志分析步骤?

1.下载网站日志文件

登录“FTP”账号,链接网站数据,找到网站日志文件夹。(注:一般情况下,网站日志所在的文件夹与网站文件同级,带有日志字样。只有少数情况下,网站日志文件夹所在网站根目录。)

打开文件夹,下载日志压缩文件!(下载方法很简单,直接选中文件直接拖到电脑桌面,然后点击左下方本地浏览下载目录中文件上的“右键——传输队列”!)

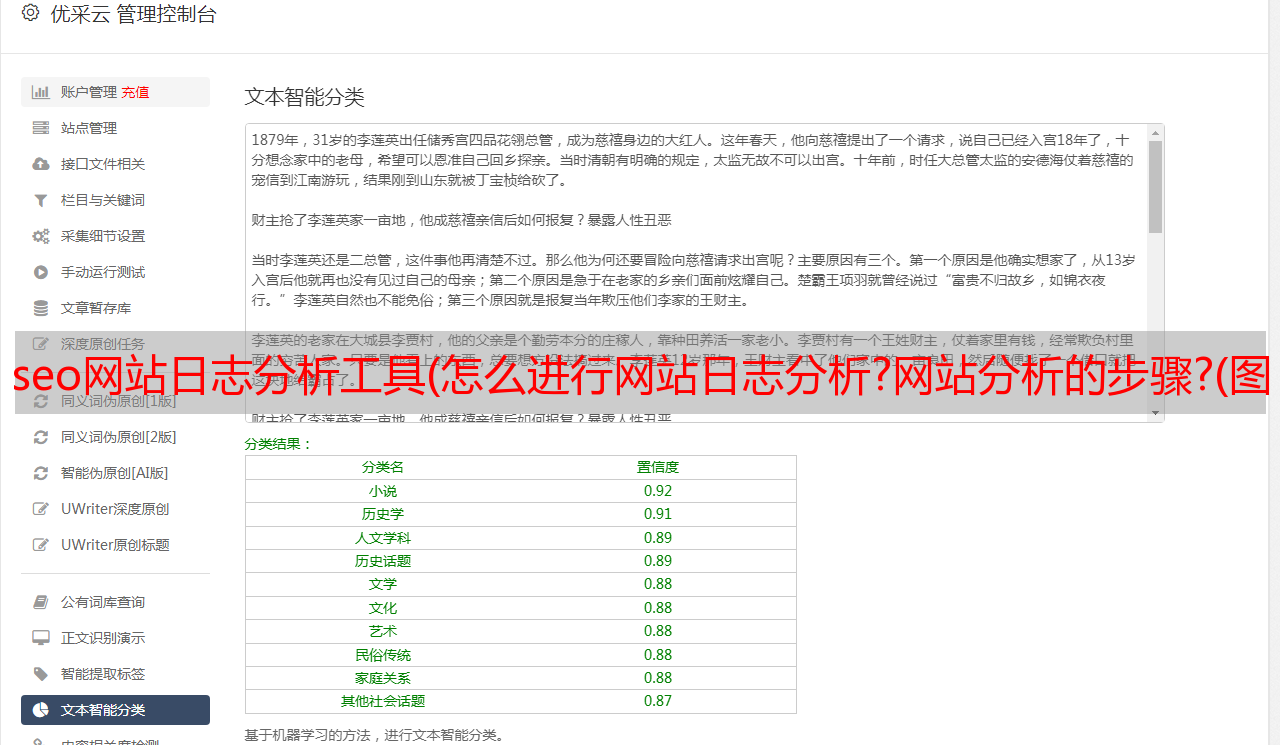

2.将文件导入网站日志分析工具,比如比较简单的Lager

通过网站日志分析的重要信息能给SEO带来什么实际效果?

1、查看蜘蛛访问页面返回的状态码,利用robots文件屏蔽一些死链等异常链接。可能是表面上的一个网站,我觉得优化的很好,几乎没有404页面,但是有些网站可能是通过第三方外包的网站,因为第三方没有考虑SEO角度,会导致网站中出现很多不可见的死链接。通过网站日志分析,我们可以看到百度蜘蛛或其他爬虫访问过哪些页面,页面是否处于200正常状态、301跳转状态或404异常状态。我们在robots文件中屏蔽了这些异常页面后,搜索引擎可以加深对我们网站的印象。我们告诉它我们网站 没有无法打开的页面。它对用户体验非常友好。

2、及时发现网站上的实际死链。经过网站的日志分析,除了跟踪统计蜘蛛的访问数据,当然还有大量真实的用户访问数据。通过查看真实用户的访问数据,我们还可以了解用户访问了哪些页面。如果出现404状态码,我们可以通过其上级访问页面快速定位到网站的哪个页面的死链接。帮助SEO人员快速找到死链,去除死链。网站死链接的危害对于已经开始研究网站日志的同事来说,应该没有必要了,我们可以用心去理解。

3、你可以找到一些搜索引擎爬虫的规则。博主发现搜索引擎爬虫,尤其是百度蜘蛛,每天固定时间来到我们的网站。通过这个规则,我们可以更加合理的安排新文章每天的更新时间,保证蜘蛛能够获取到当天网站的第一手信息,有利于新内容的及时收录。

4、可以整理出一些恶意爬虫和恶意ip地址。做网站,尤其是在竞争比较激烈的行业网站,很容易招来竞争对手的嫉妒。排名终于上来之后,竞争对手使用DDOS攻击等手段进行攻击网站、网站虽然日志分析帮不上什么忙,但毕竟偶尔还是能帮上忙的。至于可疑爬虫,是指那些通过爬虫爬到我们网站的原创文章,整合成伪原创发布给自己的网站类爬虫。

5、还可以帮助站长分析订单来源渠道。对于一个企业网站来说,了解并统计订单来源很重要。它可以帮助站长了解该订单是通过外部链接、搜索引擎还是直接访问获得的。进一步细分,我们还可以统计这些交易访问者的网络中断是在PC端还是移动端,以及他们使用的是Android还是Apple。理解清楚后,可以帮助我们大大提高网站的转化率,让我们的网站更加适合。