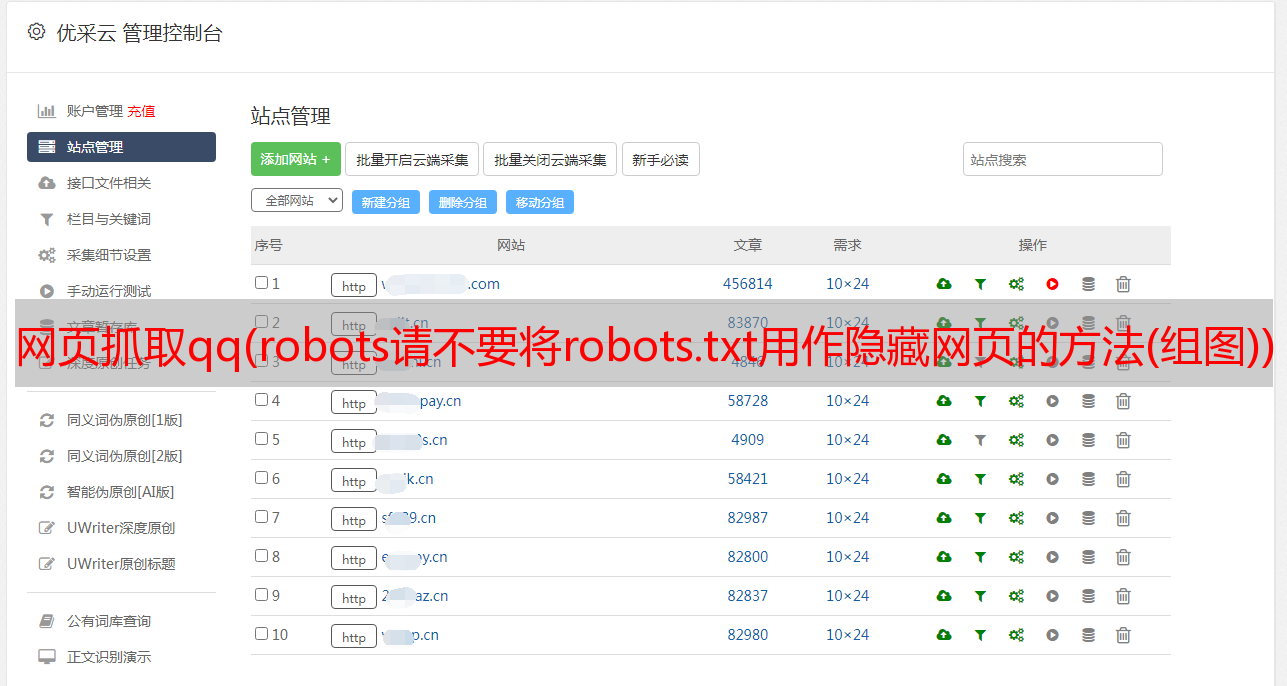

网页抓取qq(robots请不要将robots.txt用作隐藏网页的方法(组图))

优采云 发布时间: 2021-10-17 04:08网页抓取qq(robots请不要将robots.txt用作隐藏网页的方法(组图))

为了防止某些网页被搜索引擎收录抓取,大家想到的第一种方法就是使用robots.txt。没错,几乎每一个网站都有一个robots.txt文件,目的是为了禁止某些目录被搜索引擎收录抓取并加入到所有搜索结果的索引中。但是,如果您想禁止搜索引擎抓取某些网页,仅使用 robots.txt 是不够的。

机器人.txt

请不要使用 robots.txt 作为隐藏网页的方式

robots.txt 文件位于网站 的根目录下,用于指明您不希望搜索引擎爬虫访问您的网站 上的哪些内容。本文档使用机器人排除标准,这是一个收录一小组命令的协议,可以基于网站的各个部分和特定类型的网络爬虫(例如移动爬虫和桌面版本)。爬虫),表示可访问的 网站 内容。

◆非图片文件

对于非图片文件(即网页),您应该只使用 robots.txt 来控制抓取流量,因为通常您不希望搜索引擎抓取工具使您的服务器过载或浪费抓取预算。 @网站。如果您不希望您的网页出现在搜索引擎搜索结果中,请不要使用 robots.txt 作为隐藏网页的方式。这是因为其他网页可能指向您的网页,从而导致您的网页被编入索引并使 robots.txt 文件无用。如果您想阻止您的网页出现在搜索结果中,请使用其他方法,例如密码保护或 noindex 标签或说明。

◆图片文件

robots.txt 可以阻止图片文件出现在搜索引擎搜索结果中(但不会阻止其他网页或用户链接到您的图片)。

◆资源文件

如果您认为在加载网页时跳过不重要的图片、脚本或样式文件不会造成太大影响,那么您可以使用robots.txt 来屏蔽这些资源文件。但是,如果缺少这些资源会增加爬虫分析网页的难度,建议您不要屏蔽这些资源,否则搜索引擎将无法正确分析依赖这些资源的网页。

了解 robots.txt 的局限性

在创建 robots.txt 之前,您应该了解这种 URL 拦截方法的潜在风险。有时,您可能需要考虑其他机制来确保搜索引擎无法在 Internet 上找到您的 URL。

◆Robots.txt 命令只是指令

robots.txt 文件中的命令不会强制爬虫对您的 网站 采取特定操作;为了访问您的 网站 爬虫,这些命令只是说明。常规的网络爬虫工具会按照robots.txt文件中的命令执行,但其他爬虫工具可能不一样。因此,如果您想确保您在网站上的特定信息不会被网络爬虫抓取,建议您使用其他屏蔽方式(例如为您服务器上的私人文件提供密码保护)。

◆不同的爬虫工具有不同的语法分析

尽管正式的网络爬虫遵循 robots.txt 文件中的说明,但这些爬虫可能会以不同的方式解析这些说明。您应该仔细查看不同网络爬虫的正确语法,因为有些爬虫可能无法理解某些命令。

◆如果其他网站上有链接指向被robots.txt文件屏蔽的网页,该网页仍可能被索引

尽管搜索引擎不会抓取或索引被 robots.txt 阻止的内容,但如果网络上其他地方存在指向禁止 URL 的链接,搜索引擎仍可能找到该 URL 并将其索引。因此,相关 URL 和其他公开显示的信息(例如相关页面链接中的锚文本)可能仍会出现在搜索结果中。为了正确防止您的 URL 出现在搜索结果中,您应该为服务器上的文件提供密码保护或使用 noindex 元标记或响应标头(或完全删除相关网页)。

您可能还对以下文章感兴趣

如何编写robots.txt Disallow 和Allow 下级目录或文件

robots.txt语法详解:*、$、?等字符的含义及用法